AWS punta a semplificare la gestione dei dati con DataZone e l'integrazione tra Redshift, Aurora e Apache Spark

di Riccardo Robecchi pubblicata il 01 Dicembre 2022, alle 16:45 nel canale Cloud

AWS ha annunciato diverse novità nella gestione dei dati: DataZone consente di facilitarne la catalogazione, e c'è poi l'integrazione tra Redshift e Aurora (servizio di DBMS) e tra Redshift e Apache Spark (per gestire i "big data")

Sono diverse le novità per quanto riguarda la gestione dei dati che AWS ha annunciato a Re:Invent 2022, la sua conferenza annuale che si tiene a Las Vegas e alla quale abbiamo partecipato. L'azienda ha presentato un'integrazione "zero ETL" tra Amazon Redshift e Amazon Aurora, e un'integrazione tra Redshift e Apache Spark che consente di usare i servizi di analisi dei dati e di machine learning forniti da AWS. Sempre in tema di gestione dei dati, AWS ha annunciato anche Amazon DataZone, un servizio che consente alle aziende di ottenere un migliore controllo sui propri dati.

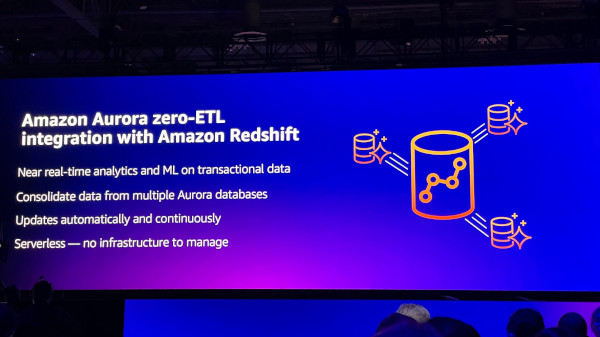

Basta ETL tra Amazon Aurora e Amazon Redhisft

Uno dei principali problemi che le aziende devono affrontare quando usano sistemi differenti è quello della trasformazione dei dati: il processo ETL (dall'inglese "extract, transform, load", ovvero "estrarre, trasformare, caricare") rappresenta spesso uno dei problemi più lunghi e complessi da affrontare nell'integrazione tra applicativi.

Per questo è particolarmente significativo l'annuncio di AWS che non sarà più necessario costruire complesse pipeline di ETL tra Amazon Aurora, servizio di database relazionale compatibile con MySQL e PostgreSQL, e Amazon Redshift, servizio per analizzare dati strutturati e semi-strutturati in database, data warehouse e data lake.

Come scrive la stessa AWS nel comunicato di annuncio, "molte realtà oggi si affidano a una soluzione in tre parti per analizzare i propri dati transazionali: un database relazionale per archiviare i dati, un data warehouse per analizzarli e una pipeline di ETL tra il database relazionale e il data warehouse. Le pipeline possono essere costose da costruire e difficili da manutenere, dato che richiedono agli sviluppatori di scrivere codice su misura e gestire costantemente l'infrastruttura per assicurarsi che scali con la domanda."

La nuova soluzione consente invece di avere i dati transazionali di Aurora automaticamente e continuamente replicati in Redshift, così da poterli analizzare tramite, ad esempio, tecniche di machine learning.

Amazon Redshift si integra con Apache Spark

Apache Spark è uno dei framework open source più usati per gestire attività di analisi dei cosiddetti "big data". AWS ne offre una sua versione che, a suo dire, è tre volte più veloce di quella open source. Tuttavia, non esisteva un'integrazione nativa tra Spark e Redshift e le aziende dovevano rivolgersi a terze parti. AWS ha dunque deciso di fornire un proprio connettore che consente alle aziende di analizzare più facilmente i propri dati con Apache Spark all'interno di Redshift, tagliando fuori allo stesso tempo la concorrenza.

La nuova integrazione consente, stando ad AWS, agli sviluppatori di eseguire interrogazioni con Redshift sui dati di applicazioni basate su Spark "in pochi secondi" usando i linguaggi di programmazione più diffusi (come Java, Python, R e Scala). Il vantaggio del nuovo connettore è che le fasi intermedie sono gestite in automatico dal sistema, cosicché gli utilizzatori non devono preoccuparsi di configurarle e gestirle da sé.

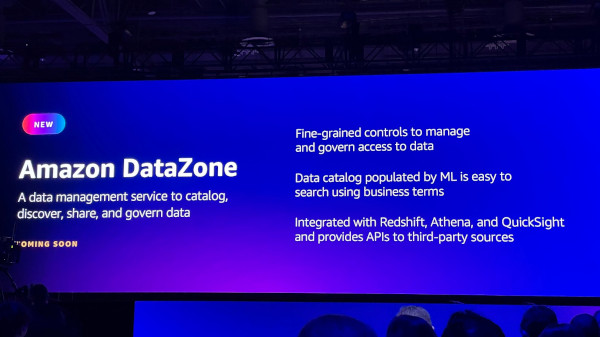

Amazon DataZone punta a semplificare la gestione dei dati

Le aziende fanno sempre più fatica a capire di quali dati sono in possesso e dove questi siano archiviati, grazie anche al crescente numero di luoghi sia fisici, sia virtuali in cui possono essere custoditi. Oltre alle tradizionali infrastrutture on premise, si aggiungono infatti i servizi di cloud computing e quelli di terze parti. Amazon DataZone punta ad aiutare le aziende a trovare, catalogare, condividere e amministrare i dati ovunque essi si trovino.

Tramite il servizio, i produttori dei dati aziendali possono usare il portale Web di DataZone per creare un catalogo dei dati con una propria tassonomia, impostando altresì le corrispondenti politiche di amministrazione e il collegamento con servizi terzi (sia di AWS, come S3 e Redshift, sia di terzi, come Salesforce e ServiceNow).

DataZone impiega il machine learning per raccogliere e suggerire metadati da impiegare per catalogare i dati, e per renderli poi disponibili tramite il proprio portale Web. In tale modo è possibile cercare tra i dati, richiedervi l'accesso ed esaminare i metadati. Viene quindi creato un progetto che è condiviso tra i membri della squadra e consente di gestire più facilmente l'accesso ai dati. È inoltre possibile sfruttare le API per integrare DataZone con soluzioni come DataBricks, Snowflake e Tableau.

FRITZ!Repeater 1700 estende la rete super-veloce Wi-Fi 7

FRITZ!Repeater 1700 estende la rete super-veloce Wi-Fi 7 Fondazione Chips-IT, l'Italia alla riscossa nei chip. Il piano e la partnership EssilorLuxottica

Fondazione Chips-IT, l'Italia alla riscossa nei chip. Il piano e la partnership EssilorLuxottica Nutanix: innovazione, semplicità e IA al centro della strategia hybrid multicloud

Nutanix: innovazione, semplicità e IA al centro della strategia hybrid multicloud Ayaneo svela Pocket Play: è uno smartphone con controlli fisici e un design che ricorda Xperia Play

Ayaneo svela Pocket Play: è uno smartphone con controlli fisici e un design che ricorda Xperia Play Apple sotto indagine in Svizzera: è tutta colpa del chip NFC

Apple sotto indagine in Svizzera: è tutta colpa del chip NFC Anthropic, Kaplan avverte: entro il 2030 una scelta cruciale sul futuro dell'AI

Anthropic, Kaplan avverte: entro il 2030 una scelta cruciale sul futuro dell'AI

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".