AWS spinge sui chip custom con Graviton4 e Trainium2: ecco di cosa si tratta

di Manolo De Agostini pubblicata il 30 Novembre 2023, alle 09:51 nel canale Cloud

Amazon Web Services (AWS) ha presentato durante AWS re:Invent 2023 due nuovi chip proprietari, una soluzione ARM chiamata Graviton4, e un chip dedicato all'IA, Trainium2, che inserirà nella propria infrastruttura. Rafforzata anche la partnership con NVIDIA.

Nel corso di AWS re:Invent 2023, Amazon Web Services (AWS) e la sua sussidiaria Annapurna Labs hanno svelato AWS Graviton4, un nuovo processore basato su architettura ARM, ma anche AWS Trainium2, un acceleratore di intelligenza artificiale. Inoltre, AWS e NVIDIA hanno annunciato una collaborazione per realizzare un supercomputer AI nel cloud. Il sistema, soprannominato Ceiba, si baserà su 16.384 acceleratori GH200 Superchip.

Graviton4: più core ARM e maggiori prestazioni

Graviton4 prevede 96 core single-thread che, secondo la società, consentono al chip di offrire prestazioni di calcolo il 30% superiori (di media) alla precedente soluzione, Graviton3. Non solo, Graviton4 sarebbe anche (sempre di media) il 40% più veloce in applicazioni database e il 45% in applicazioni Java.

Inoltre, AWS indica un incremento del 75% nella bandwidth di memoria di picco rispetto al predecessore, per un valore di 536,7 GB/s. Quest'ultimo numero indica che il processore ha più canali di memoria di Graviton3, probabilmente 12 contro gli 8 precedenti.

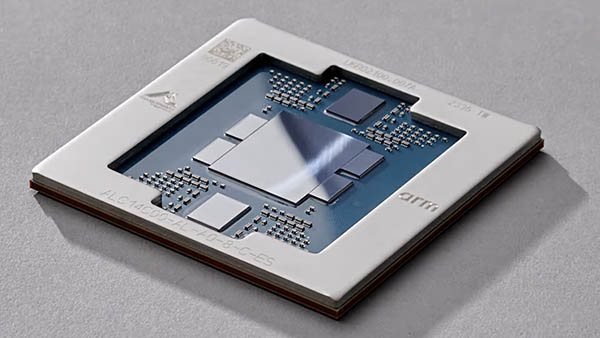

Per quanto riguarda i core, è plausibile che la CPU adotti i Neoverse V2 di ARM, ma non ci sono conferme. Si vocifera inoltre del raddoppio della cache L2 per core, con il passaggio da 1 a 2 MB. Dalle foto si può vedere che il nuovo Graviton, come il predecessore, si basa su un progetto con più tile sullo stesso package, nel caso specifico sette.

Graviton4 sarà il cuore delle istanze R8g di Amazon EC2 ottimizzate per la memoria, cosa particolarmente utile per aumentare le prestazioni nei database di fascia alta e nell'analisi. Inoltre, le istanze R8g forniranno fino a tre volte più vCPU e memoria rispetto alle istanze R7g basate su Graviton 3, consentendo un throughput più elevato per l'elaborazione dei dati, migliore scalabilità, risultati più rapidi e costi ridotti.

Per garantire la sicurezza delle istanze AWS EC2, Amazon ha dotato tutte le interfacce hardware fisiche ad alta velocità delle CPU Graviton4. "Concentrando la progettazione dei nostri chip su carichi di lavoro reali che contano per i clienti, siamo in grado di fornire loro l'infrastruttura cloud più avanzata", ha affermato David Brown, vicepresidente di Compute and Networking di AWS. "Graviton4 segna la quarta generazione che abbiamo fornito in soli cinque anni ed è il chip più potente ed efficiente dal punto di vista energetico che abbiamo mai realizzato per un'ampia gamma di carichi di lavoro".

AWS Trainium2 per addestrare l'IA

Per quanto concerne AWS Trainium2, si tratta di una soluzione per l'addestramento di IA che, secondo la società, offre velocità di addestramento fino a quattro volte superiori e con una capacità di memoria tripla rispetto ai chip Trainium originali.

Inoltre, Trainium2 ha migliorato l'efficienza energetica, raggiungendo fino al doppio delle prestazioni per watt. Le macchine basate su Trainium2 saranno connesse utilizzando AWS Elastic Fabric Adapter (EFA), che offre prestazioni su scala petabit.

A colpire di Trainium2 è che sarà disponibile in istanze EC2 Trn2 che potranno scalare fino a 100.000 chip Trainium2, impostati per fornire una potenza di calcolo IA fino a 65 exaflops, consentendo agli utenti di accedere a prestazioni simili a quelle dei supercomputer.

Una tale scalabilità consentirà l'addestramento di modelli linguistici di grandi dimensioni con 300 miliardi di parametri, cosa che in precedenza richiedeva mesi e che ora potrà essere completata in poche settimane. Da un punto di vista della progettazione, si notano sul package due chiplet di calcolo, quattro HBM e due altri chiplet non meglio precisati.

"Stiamo lavorando a stretto contatto con AWS per sviluppare i nostri futuri modelli di base usando i chip Trainium", ha affermato Tom Brown, cofondatore di Anthropic. "Trainium2 ci aiuterà a mettere in piedi e addestrare modelli su larga scala e ci aspettiamo che sarà almeno 4 volte più veloce dei chip Trainium di prima generazione per alcuni dei nostri carichi di lavoro principali. La nostra collaborazione con AWS aiuterà le società di tutte le dimensioni a sbloccare nuove possibilità".

AWS e NVIDIA insieme per NVIDIA GH200 NVL32, ma non solo

Ad AWS re:Invent 2023, AWS e NVIDIA hanno annunciato diverse collaborazioni. AWS sarà il primo provider cloud a integrare le soluzioni NVIDIA GH200 Grace Hopper Superchip all'interno della piattaforma multi-nodo NVIDIA GH200 NVL32 che connette 32 Grace Hopper Superchip con le tecnologie NVLink e NVSwitch in una istanza.

La piattaforma sarà disponibile su istanze Amazon Elastic Compute Cloud (Amazon EC2) connesse con la potete rete di Amazon (EFA), supportata virtualizzazione avanzata (AWS Nitro System) e clustering hyper-scale (Amazon EC2 UltraClusters), consentendo ai clienti comuni di raggiungere migliaia di GH200 Superchip.

NVIDIA e AWS collaboreranno per ospitare NVIDIA DGX Cloud, il servizio di formazione AI di NVIDIA, su AWS. Sarà il primo DGX Cloud con GH200 NVL32, così da restituire agli sviluppatori la più grande memoria condivisa in una singola istanza. DGX Cloud on AWS accelererà la formazione di IA generativa e di modelli linguistici di grandi dimensioni che possono raggiungere oltre 1 trilione di parametri.

NVIDIA e AWS stanno collaborando anche su Project Ceiba con l'obiettivo di progettare il supercomputer AI basato su GPU più veloce al mondo: un sistema su larga scala con GH200 NVL32 e interconnessione Amazon EFA, ospitato da AWS per il team di ricerca e sviluppo di NVIDIA. Questo supercomputer unico nel suo genere, dotato di 16.384 NVIDIA GH200 Superchip e in grado di toccare una potenza di calcolo IA di 65 exaflops, sarà utilizzato da NVIDIA per innovare nel campo dell'IA generativa.

Infine, AWS introdurrà tre ulteriori istanze Amazon EC2: leistanze P5e, basate su GPU NVIDIA H200 Tensor Core, per carichi di lavoro AI e HPC generativi su larga scala; e le istanze G6 e G6e, basate rispettivamente su GPU NVIDIA L4 e GPU NVIDIA L40S, per un'ampia gamma di applicazioni come ottimizzazione dell'intelligenza artificiale, inferenza, grafica e carichi di lavoro video. "Le istanze G6e sono particolarmente adatte per lo sviluppo di flussi di lavoro 3D, gemelli digitali e altre applicazioni basate su NVIDIA Omniverse", sottolinea AWS.

TCL 65C7K, televisore Mini-LED di qualità, versatile e dal prezzo competitivo

TCL 65C7K, televisore Mini-LED di qualità, versatile e dal prezzo competitivo Fujifilm X-E5: la Fuji X che tutti gli appassionati volevano

Fujifilm X-E5: la Fuji X che tutti gli appassionati volevano Recensione REDMAGIC 10S Pro: il gaming phone definitivo?

Recensione REDMAGIC 10S Pro: il gaming phone definitivo? La missione cinese Apophis Recon Swarm (ARS) vuole raggiungere e studiare l'asteroide Apophis

La missione cinese Apophis Recon Swarm (ARS) vuole raggiungere e studiare l'asteroide Apophis Offerta Starlink kit Standard: l'hardware non si paga, rimane l'abbonamento mensile a partire da 29 euro

Offerta Starlink kit Standard: l'hardware non si paga, rimane l'abbonamento mensile a partire da 29 euro 3I/ATLAS è la cometa interstellare che attraverserà il Sistema Solare e che gli scienziati vogliono studiare

3I/ATLAS è la cometa interstellare che attraverserà il Sistema Solare e che gli scienziati vogliono studiare

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".