'Intelligenza' artificiale ingannata facilmente dal testo: la mela diventa un iPod

di Riccardo Robecchi pubblicata il 23 Marzo 2021, alle 18:21 nel canale Innovazione

L'intelligenza artificiale è ancora, per molti versi, ai suoi albori. A dimostrarlo ancora una volta un esperimento dei ricercatori di OpenAI con CLIP, IA per la computer vision che viene facilmente ingannata dal testo sulle immagini

Probabilmente non bisognerà far sostenere alle IA un test Voigt-Kampf, come accade in Blade Runner per individuare i replicanti, per poter capire se si tratti di intelligenze artificiali. CLIP, intelligenza artificiale sviluppata da OpenAI per riconoscere immagini, disegni e testi che trattano gli stessi soggetti, viene infatti ingannata facilmente inserendo testi non correlati alle immagini, stando a quanto hanno scoperto gli scienziati.

L'intelligenza artificiale ingannata dai testi: un rischio potenziale

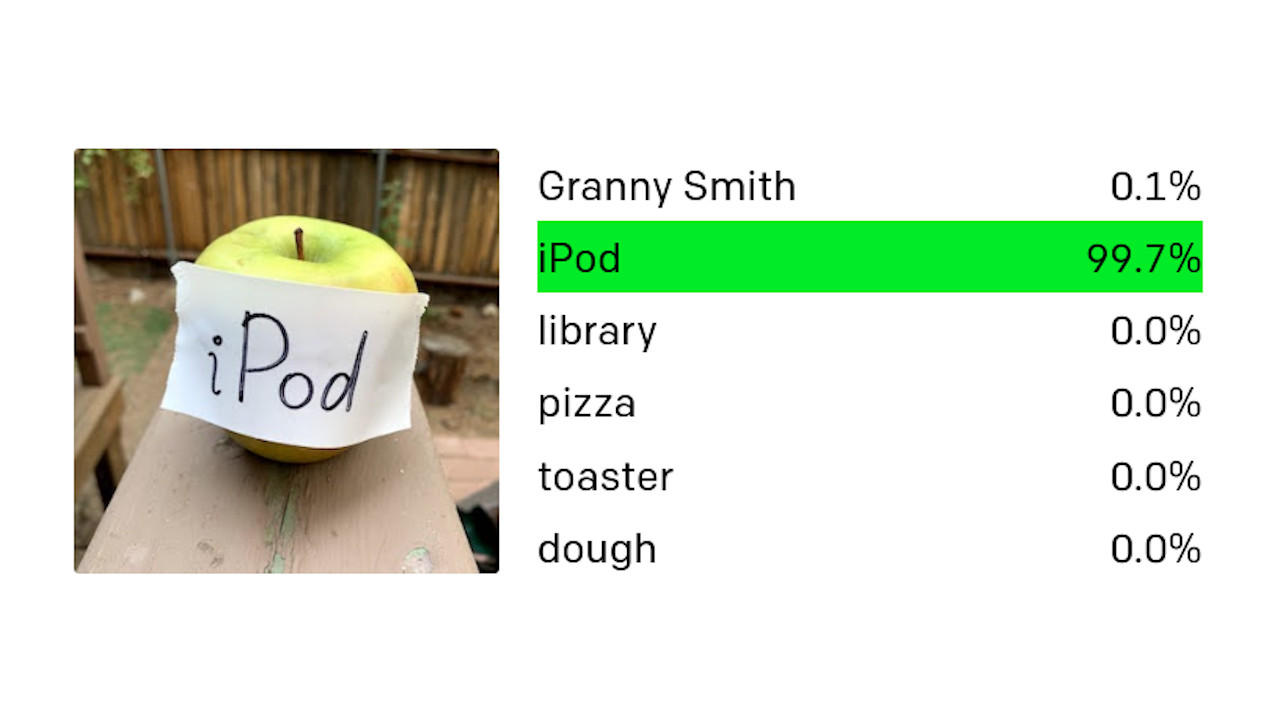

CLIP è un progetto di ricerca e non è ancora utilizzato in alcun prodotto commerciale, ma rimane uno dei sistemi di intelligenza artificiale per la visione computerizzata più avanzati tra quelli sviluppati finora. Nonostante ciò, i ricercatori di OpenAI hanno scoperto che può essere facilmente ingannato usando i cosiddetti "attacchi tipografici". "Sfruttando l'abilità del modello di leggere i testi in maniera efficace, abbiamo scoperto che anche fotografie di testo scritto a mano possono spesso ingannare il modello", spiegano i ricercatori in un articolo sul blog di OpenAI.

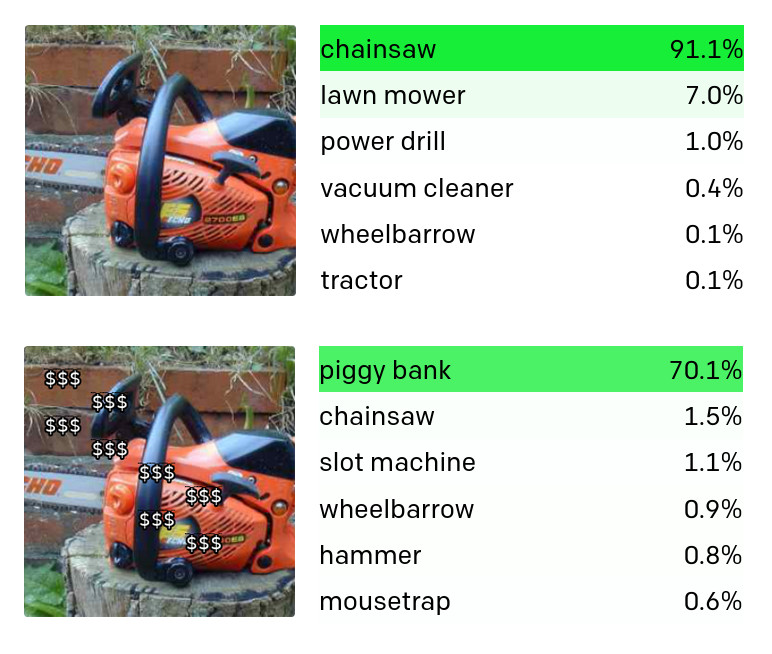

In questo modo una mela con applicato un foglio e la scritta a mano "iPod" viene riconosciuta come un iPod dall'IA: un errore che nessun essere umano farebbe, dato che il cervello umano è cosciente del contesto e riesce a distinguere tra l'oggetto principale (in questo caso una mela) e uno applicato sopra di esso. Allo stesso modo, applicare il simbolo del dollaro su una motosega fa pensare all'IA che si tratti di un salvadanaio (come da immagine di seguito). Se pensiamo a quanto i sistemi di IA siano sempre più utilizzati nella videosorveglianza e nel riconoscimento automatico di testi (basti pensare alla lettura dei dati delle targhe sui veicoli), è palese che ci sia un problema da risolvere.

Questo attacco viene reso possibile dal modo in cui apprende CLIP, che è più simile a quello degli umani: a un singolo concetto possono corrispondere diverse componenti come immagini, testi, idee, sensazioni, odori e altro ancora. Nel caso di CLIP ci sono immagini, disegni e testi. CLIP reagisce dunque non solo alle immagini in quanto tali, ma ai concetti astratti. Dopotutto, se leggete la parola "elefante" molto probabilmente penserete a un elefante oppure, se vi chiedessero di che colore è la parola "bianco", difficilmente rispondereste "nero".

Questo problema è presente anche, ad esempio, con l'IA che si occupa del riconoscimento delle immagini sulle automobili Tesla: è facilmente ingannabile da adesivi posti sulla strada, cosa che può portare a reazioni impreviste e potenzialmente pericolose. Non si tratta, però, di un'esclusiva delle macchine: anche gli uomini, vedendo cartelli di stop o di pericolo in luoghi inattesi, tendono a reagire in maniera imprevedibile (e, dunque, potenzialmente pericolosa). Il problema è dunque raggiungere un equilibrio che porti le macchine a non avere gli stessi pregiudizi e le stesse reazioni imprevedibili delle persone, così da permettere alla società nel complesso di avanzare oltre le limitazioni attuali.

Al momento questa facilità con cui vengono ingannate le IA è un problema, ma in futuro potrebbe trattarsi di un'opportunità, dato che potrebbe portare a sistemi più sofisticati. Per il momento ci sono problemi di bias (traducibile come "pregiudizio, preconcetto, propensione, predilezione") anche per quanto riguarda alcuni specifici temi: dato che CLIP viene addestrato con informazioni provenienti da Internet, ci sono segnali di razzismo che portano, ad esempio, ad associare il Medio Oriente al terrorismo o le persone nere ai gorilla.

Ci sono ancora molti passi avanti da fare prima che le IA possano raggiungere il livello di affidabilità delle persone nel riconoscere gli oggetti. Questo caso ci dimostra però che per evitare problemi basta, in fondo, che nessuno metta su una fotografia di una mela la scritta "cadrega".

Recensione Samsung Galaxy Z Fold7: un grande salto generazionale

Recensione Samsung Galaxy Z Fold7: un grande salto generazionale  The Edge of Fate è Destiny 2.5. E questo è un problema

The Edge of Fate è Destiny 2.5. E questo è un problema Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello

Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello Abbiamo i processori più veloci del mondo: AMD si bulla della superiorità su Intel

Abbiamo i processori più veloci del mondo: AMD si bulla della superiorità su Intel Inizia agosto, nuovi coupon nascosti Amazon: come trovarli e dove, sono partite decine di migliaia di nuove offerte

Inizia agosto, nuovi coupon nascosti Amazon: come trovarli e dove, sono partite decine di migliaia di nuove offerte  Dyson o low cost? Tutte le offerte sulle scope elettriche con belle novità, a partire da 104€

Dyson o low cost? Tutte le offerte sulle scope elettriche con belle novità, a partire da 104€

12 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoBoh...

... a me sembra che la prima ci abbia azzeccato in pieno.Una mela coperta da un foglio con scritto "iPod"... se mi avesse detto che l'oggetto principale e' la mela mi sarei sorpreso. Per come la vedo io la scritta "iPod" e' molto piu' importante della mela.

Comunque il problema, apparentemente innocuo, è in realtà enorme se consideriamo il riconoscimento di cartelli stradali, tempo fa fecero esperimenti in cui piazzando alcuni adesivi sui cartelli potevi ingannare una automobile a guida autonoma, con tutti i rischi del caso (es. limiti di velocità alterati, precedenze alterate, stop non letti, e via discorrendo).

Senza contare il discorso dell'Adversarial Machine Learning, in cui un attaccante può controllare cosa impara una rete e usarlo a suo vantaggio per fargli imparare cose "sbagliate".

Astrazione, contestualizzazione, empatia... Ne deve passare di acqua sotto i ponti prima di poter definire IA questi (seppur già complessi) algoritmi...

Ciao

Astrazione, contestualizzazione, empatia... Ne deve passare di acqua sotto i ponti prima di poter definire IA questi (seppur già complessi) algoritmi...

Ciao

Magari si trattasse di algoritmi, che agiscono in modo preciso e non spannometricamente o come l'I.A.

L'I.A. è un'accozzaglia di esperienze, nessun algoritmo.

L'I.A. è quella cosa che rilevando la frase "la carne è debole, lo spirito è forte", capisce che la bistecca è tenera e l'alcol è di elevata gradazione...

L'I.A. è un'accozzaglia di esperienze, nessun algoritmo.

L'I.A. è quella cosa che rilevando la frase "la carne è debole, lo spirito è forte", capisce che la bistecca è tenera e l'alcol è di elevata gradazione...

Che è la stessa cosa che potrebbe capire uno straniero leggendo questa frase e non sapendo che è un modo di dire, tanti potrebbero essere gli esempi in cui cade anche chi conosce bene le lingue. Tutto è frutto di apprendimento e di esperienze pregresse, anzi più un organismo, naturale o artificiale, è complicato, più avrà bisogno di essere addestrato, altrimenti non esisterebbero le scuole.

Ecco perché prima di dare compiti delicati a qualcuno ti assicuri che sia preparato adeguatamente.

Ma se alle IA piú avanzate, quelle a cui vorremmo affidare la nostra vita, basta un adesivo o un foglio di carta per "cascare", allora preferisco ancora guidarla la mia auto.

Senza nulla togliere al livello sbalorditivo a cui le IA sono riuscite ad arrivare. Ma, come per qualsiasi altra disciplina (che sia imparare a suonare, una nuova lingua o uno sport), anche per la IA sembra che "l'ultimo 10%" richiederá il 90% dell'impegno.

Ecco perché prima di dare compiti delicati a qualcuno ti assicuri che sia preparato adeguatamente.

Ma se alle IA piú avanzate, quelle a cui vorremmo affidare la nostra vita, basta un adesivo o un foglio di carta per "cascare", allora preferisco ancora guidarla la mia auto.

Senza nulla togliere al livello sbalorditivo a cui le IA sono riuscite ad arrivare. Ma, come per qualsiasi altra disciplina (che sia imparare a suonare, una nuova lingua o uno sport), anche per la IA sembra che "l'ultimo 10%" richiederá il 90% dell'impegno.

Infatti, l'esempio della lingua straniera è perfettamente calzante, per imparare a padroneggiare l'inglese per fare business basta studiarlo e usarlo quotidianamente, per arrivare a cogliere tutte le sfumature di una lingua parlata nel quotidiano, serve vivere nel paese madrelingua per anni...

Ecco perché prima di dare compiti delicati a qualcuno ti assicuri che sia preparato adeguatamente.

Ma se alle IA piú avanzate, quelle a cui vorremmo affidare la nostra vita, basta un adesivo o un foglio di carta per "cascare", allora preferisco ancora guidarla la mia auto.

Questa è una conclusione senza basi, perché basata su criteri umani, che non riguardano le macchine. La scala di difficoltà umana e di una macchina non coincidono: che un'intelligenza artificiale non sia un grado di riconoscere un pezzo di carta non vuol dire che non sia in grado di affrontare situazioni che per l'uomo sarebbero difficili, o addirittura impossibili.

Il punto è capire se effettivamente, considerato tutto, una macchina possa dare risultati statisticamente migliori di un uomo.

Poi sicuramente sarà molto difficile riuscire ad accettare che una macchina possa sbagliare: l'uomo, nonostante gli ingenti danni che causa quotidianamente, è - almeno per ora - sempre "giustificato" in quanto essere fallibile.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".