Advancing AI 2024: le novità di AMD per i datacenter, tra CPU e GPU

di Paolo Corsini pubblicato il 10 Ottobre 2024 nel canale Device

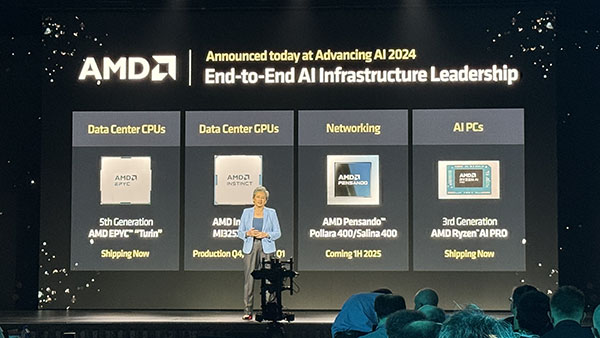

AMD annuncia la nuova famiglia di processori EPYC di quinta generazione, nome in codice Turin, accanto alle GPU Instinct MI325X e a proposte specifiche per il networking: queste novità, assieme ai prodottiin arrivo nel 2025 già anticipati, pongono le basi per la continua crescita della quota di mercato dell'azienda nel settore delle soluzioni datacenter

Advancing AI 2024 è il nome con il quale AMD ha identificato il proprio evento incentrato sulle soluzioni per i datacenter, con particolare enfasi sull'intelligenza artificiale, che si è tenuto quest'oggi a San Francisco. Per AMD questa è la cornice all'interno della quale mostrare le proprie innovazioni nel settore delle soluzioni CPU, GPU e networking specificamente sviluppate per i datacenter. Parliamo quindi delle CPU EPYC di nuova generazione, delle GPU della famiglia Instinct e delle soluzioni di networking della famiglia Pensando.

AMD si posiziona in questo mercato in modo significativo, potendo offrire ai propri partner di mercato e ai clienti un pacchetto di soluzioni di calcolo che si adattano al meglio alle differenti necessità. Tutto questo avviene bilanciando al meglio la richiesta di potenza di elaborazione tra CPU e GPU, mantenendo le prestazioni sempre elevate grazie alla propria infrastruttura di rete.

Lisa SU, CEO di AMD, annuncia il chip Instinct MI325X

durante l'evento Advancing AI 2024

E' significativo evidenziare come AMD sia stata capace negli ultimi anni di guadagnare una importante quota di mercato nel settore dei server: alla metà del 2024 questa era del 34% in termini di fatturato complessivo del settore, partendo nel 2017 da una quota di mercato di fatto pari a zero. E' stato con il debutto dei primi processori EPYC nel 2017, noti con il nome in codice di Naples, che AMD ha iniziato il proprio progressivo ingresso nel mercato dei datacenter.

Un elemento che ha indubbiamente facilitato questa crescita è stata la scelta di mantenere per quanto possibile invariata, al debutto di nuove versioni di processori EPYC, la piattaforma: per le prime 3 generazioni il socket è rimasto invariato e quello SP5 attualmente in utilizzo è compatibile con le CPU basate su architettura Zen 4 oltre a quelle Zen 5 ora al debutto sul mercato. Questa stabilità è molto apprezzata dai partner produttori di server, che in questo possono sfruttare al meglio i propri investimenti nello sviluppo dei sistemi server adattandoli rapidamente a nuovi processori.

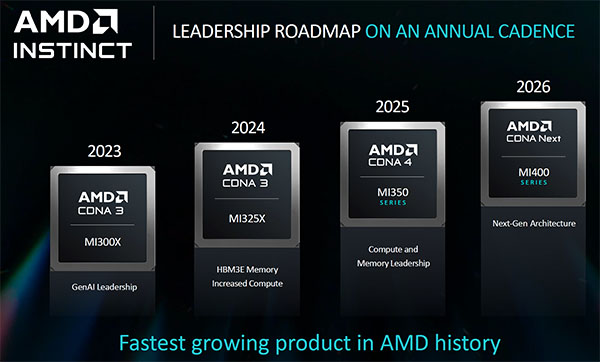

Il tasso di aggiornamento nei sistemi server è stato in questi anni molto serrato: di fatto AMD ha introdotto processori EPYC basati su nuove generazioni di architettura ogni 18-24 mesi, riuscendo con ogni versione a offrire incrementi a livello di IPC e in alcuni casi anche incrementando il numero dei core per socket. Meglio ancora è stato fatto con le GPU della famiglia Instinct, che si stanno muovendo di fatto su una cadenza di aggiornamento annuale. Del resto è il settore dei datacenter nel complesso che è caratterizzato da queste tempistiche di sviluppo che toccano non solo AMD ma tutte le aziende coinvolte.

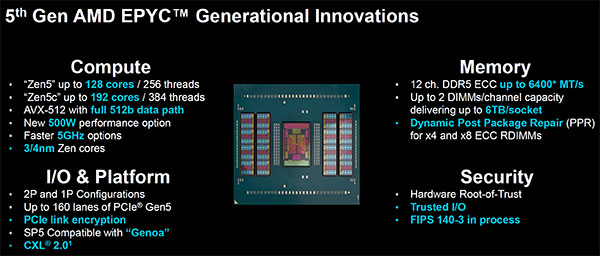

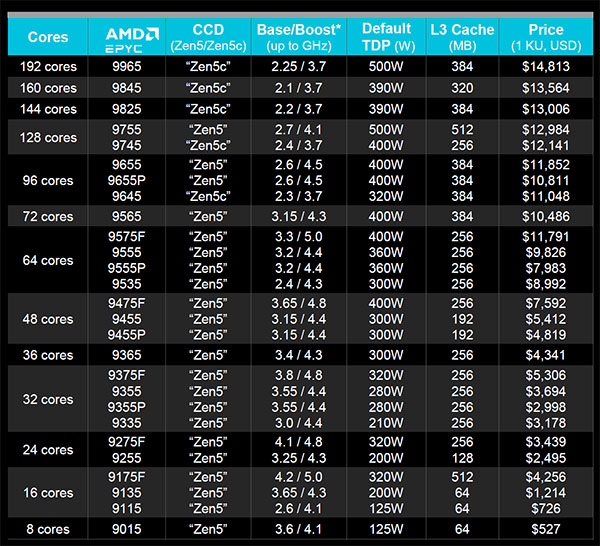

Dopo aver anticipato alcune delle caratteristiche tecniche in occasione del Computex 2024 di Taipei, lo scorso mese di maggio, AMD annuncia quest'oggi le CPU EPYC della serie 9000 basate su architettura Zen 5 e note con il nome in codice di Turin. Troviamo due famiglie di processori, che si differenziano per il tipo di core utilizzato: una adotta sino ad un massimo di 16 CCDs Zen 5, per un totale di 128 core quale picco massimo, mentre per l'altra troviamo sino a un massimo di 12 CCDs con architettura Zen 5c che permettono di avere sino a 192 core. Per entrambi i processori troviamo 12 canali memoria DDR5-6400 e 128 link PCI Express Gen 5.0 con supporto alla tecnologia CXL 2.0.

Interessante evidenziare come i core Zen 5 siano costruiti con tecnologia produttiva a 4 nanometri, mentre per quelli Zen 5c è stato adottato processo a 3 nanometri. Altra novità riguarda la disponibilità di versioni con TDP sino a 500 Watt, partendo da un minimo di 125 Watt per le proposte più parche dal punto di vista energetico, oltre all'integrazione per entrambe le tipologie di core Zen 5 di supporto alle istruzioni AVX-512 con data path nativo a 512bit.

Nel confronto con i processori AMD EPYC di precedente generazione, meglio noti con il nome in codice di Genoa (Zen 4) e Bergamo (Zen 4c) AMD è stata in grado di incrementare le prestazioni velocistiche sino al 17% in più in termini di IPC per enterprise e cloud, passando sino al +37% di IPC con applicazioni per ambito HPC e per intelligenza artificiale.

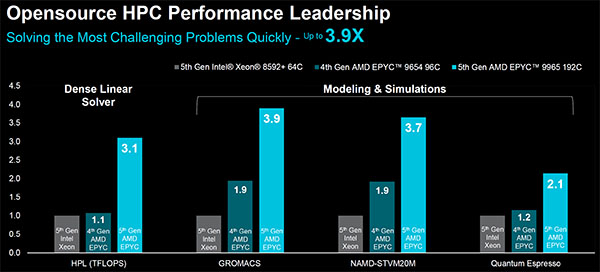

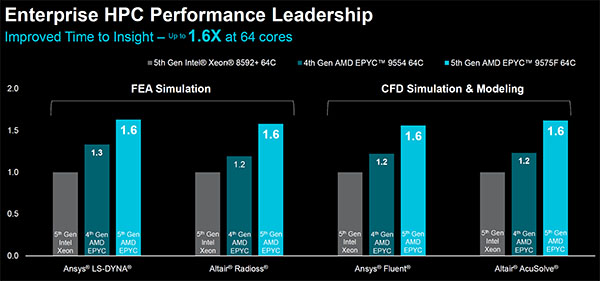

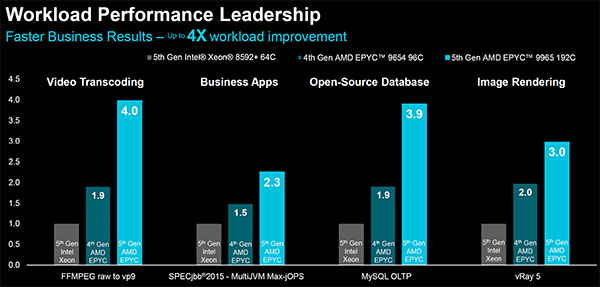

AMD ha inoltre fornito alcuni benchmark di riferimento che mettono a confronto le nuove CPU EPYC con le soluzioni di precedente generazione basate su architettura Zen 4 oltre che con quelle concorrenti di Intel Xeon 8000. In attesa di vedere cosa saranno capaci di fare le nuove CPU Xeon 6 che Intel ha recentemente annunciato, è evidente come nel passaggio alle soluzioni EPYC della famiglia Turin AMD sia in grado di offrire un netto balzo in avanti delle prestazioni velocistiche, sia offrendo un maggior numero di core sia mantenendo invariato il numero di core grazie ad un incremento dell'IPC.

La gamma dei nuovi processori EPYC della famiglia Turin vede versioni che partono da un minimo di 8 core per socket sino a un massimo di 192, con livelli di potenza, quantitativo di cache L3 e ovviamente di core che cambiano in modo netto. AMD ha reso pubblici i prezzi delle differenti versioni di processore EPYC di quinta generazione ed è da evidenziare come a parità di numero di core integrato le versioni con core Zen 5 e quelle con core Zen 5c abbiano di fatto prezzi molto allineati tra di loro.

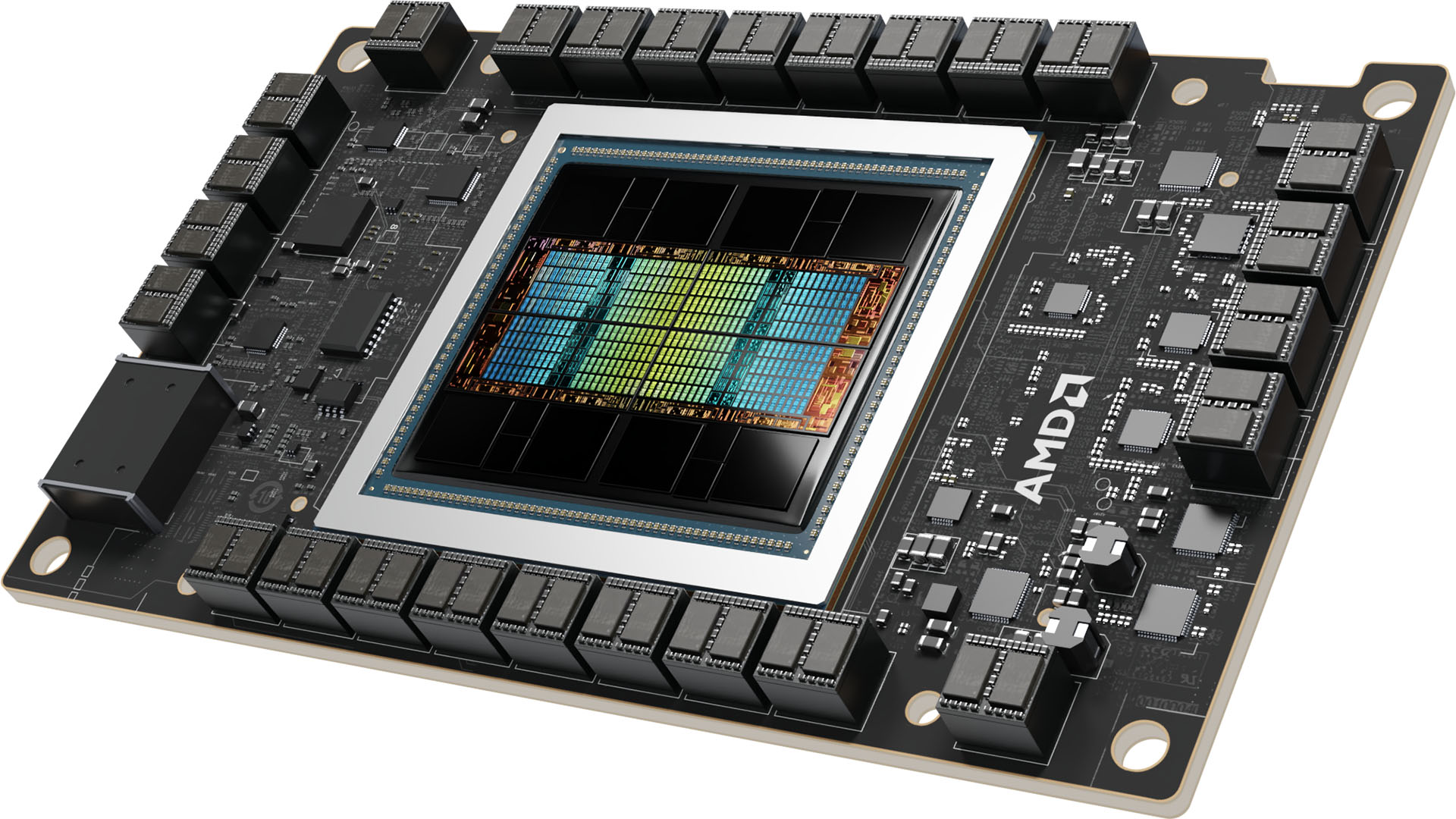

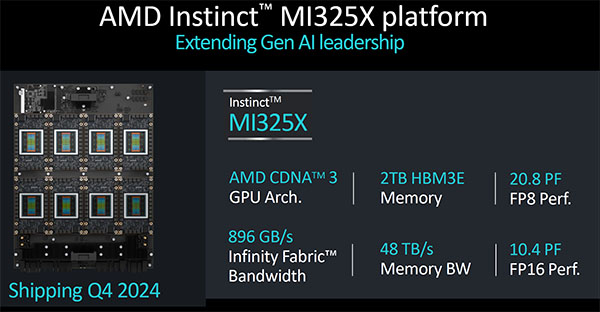

Passando alle soluzioni GPU, AMD annuncia quest'oggi le nuove proposte della famiglia Instinct che si affiancano alle schede MI300X disponibili da poco meno di 1 anno. Il nuovo chip è quello Instinct MI325X, soluzione da ben 153 miliardi di transistor sempre basata su architettura CDNA 3 abbinata a 256GB di memoria HBM3E per una bandwidth masima che tocca i 6 TB/s. Le prestazioni velocistiche di picco parlano di 2,6 PFlops con elaborazioni FP8 e 1,3 PFLOPs con elaborazioni FP16.

Le schede Instinct MI325X saranno commercializzate a partire dal quarto trimestre 2024, anche in configurazione con 8 GPU integrate all'interno di un singolo sistema indicato con il nome di AMD Instinct MI325X Platform: in questa configurazione sarà possibile ottenere potenze di elaborazione di picco pari a 20,8 PFLOPs con elaborazioni FP8 e 10,4 PFLOPs con quelle FP16.

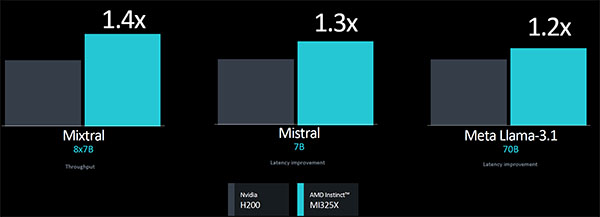

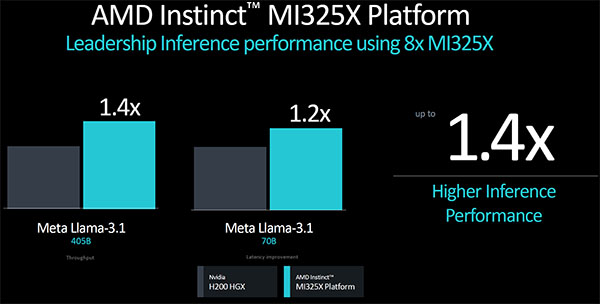

Nel confronto con le soluzioni concorrenti di NVIDIA H200, con dati forniti da AMD, si evidenzia un margine di vantaggio che varia dal 20% al 40% con elaborazioni legate all'inferenza.

Dinamica simile è quella che AMD evidenzia anche mettendo a confronto la piattaforma Instinct MI325X Platform con la proposta concorrente NVIDIA H200 HGX, entrambe basate su 8 GPU affiancate tra di loro in un singolo chassis rack. Le prestazioni di intelligenza artificiale con inferenza raggiungono un picco del 40% più elevato rispetto a quello della concorrente NVIDIA.

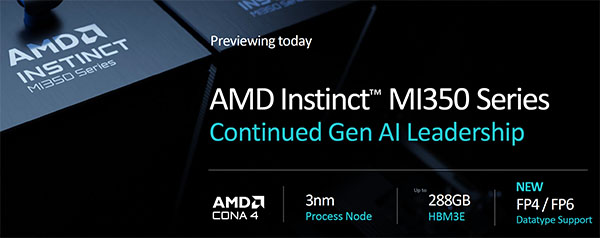

Per il 2025 AMD ha anticipato il debutto delle soluzioni Instinct MI350 di nuova generazione, basate sulla nuova architettura CDNA4 costruite con tecnologia produttiva a 3 nanometri. Per queste soluzioni AMD incrementerà il quantitativo di memoria onboard dai 256GB delle schede MI325X a 288GB, con bandwidth massima che passerà dai 6GB delle schede MI325X sino a 8TB/s.

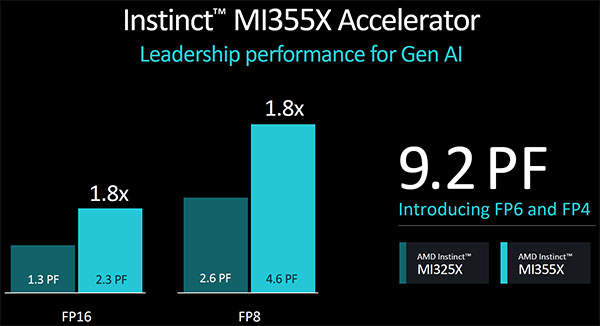

Grazie all'utilizzo della nuova architettura CDNA4, stando a quanto anticipato da AMD, le soluzioni MI350X sono in grado di registrare un netto balzo in avanti delle prestazioni rispetto a quelle offerte dalle schede MI325X: AMD indica un balzo in avanti che tocca l'80% di incremento con elaborazioni di generative AI. Le soluzioni MI350X potranno anche sfruttare elaborazioni in FP6 e FP4, riducendo la precisione e ottenendo in questo modo un ulteriore incremento delle prestazioni complessive.

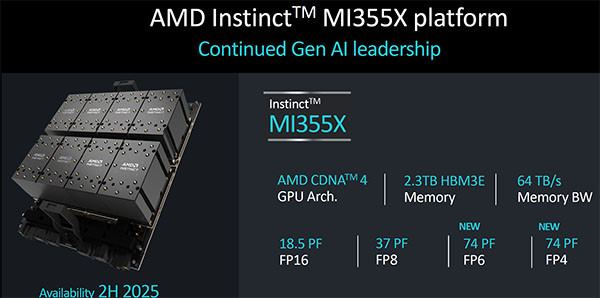

Anche per le soluzoni MI350X avremo una piattaforma dedicata con 8 GPU integrate all'interno di un singolo chassis rack. Il livello prestazionale scalerà di conseguenza in modo pressoché lineare, con una potenza di elaborazione che toccherà i 18,5PFLOPs con elaborazioni FP16 e i 37 PFLOPs con quelle PF8 spingendosi su valori ancora più elevati utilizzando le nuove modalità di elaborazione FP6 e FP4.

Se nel 2025 vedremo le soluzioni MI350X con architettura CDNA4, per il 2026 la roadmap anticipata da AMD prevede le propose MI400X che saranno basate su un'architettura di nuova generazione per la quale AMD al momento attuale non ha ancora fornito dettagli. Da rimarcare come la roadmap di evoluzione delle GPU di nuova generazione in ambito datacenter si muova con tempistiche annuali, con una cadenza quindi che è ancora più serrata di quanto non avvenga in ambito processori.

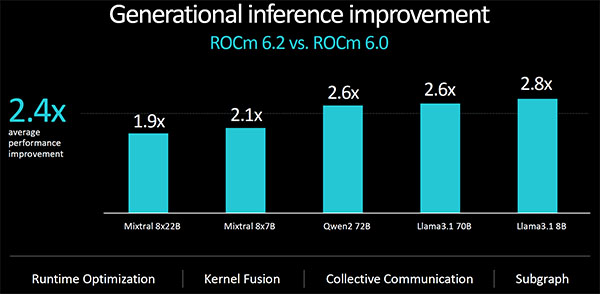

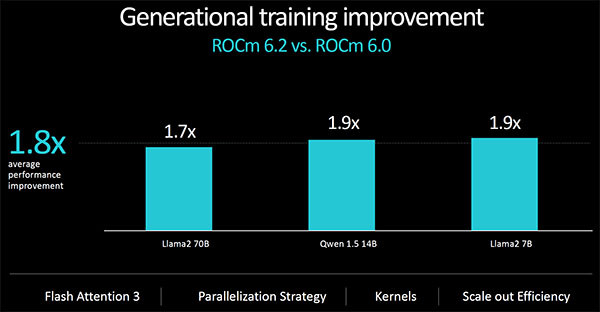

Le evoluzioni nel mondo delle elaborazioni di intelligenza artificiale in datacenter passano indubbiamente attraverso la disponibilità di nuove soluzioni hardware ma non possiamo non evidenziare il ruolo fondamentale della componente software. L'ecosistema AMD ROCm è stato costantemente evoluto e ottimizzato nel corso degli ultimi 12 mesi, sin dalla disponibilità delle prime schede Instinct MI300X: passando dalla release 6.0 a quella 6.2 AMD è stata in grado di incrementare sensibilmente le prestazioni in inferencing con un margine medio di 2,4x, mentre nel training del modelli di intelligenza artificiale l'incremento medio registrato è stato di 1,8x.

L'abbinamento tra le CPU EPYC e le GPU Instinct permette ai partner di AMD di offrire un livello di potenza e di flessibilità di elaborazione, ma per AMD questo richiede che il tutto sia efficacemente organizzato a livello di networking.

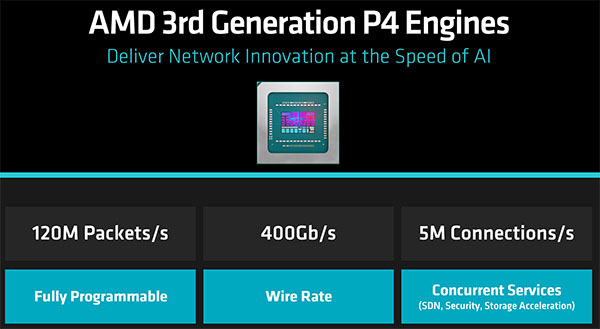

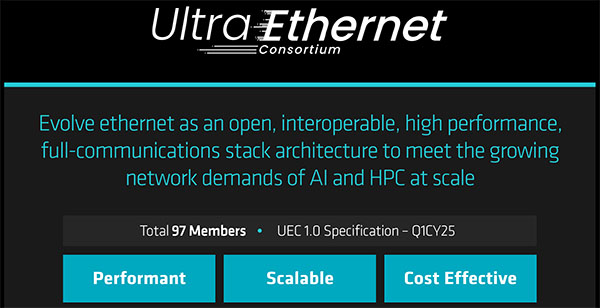

Le operazioni di training e i modelli di distribuited inference tendono infatti a dipendere fortemente dalle prestazioni del networking, che può diventare un netto collo di bottiglia alle prestazioni complessive. Il tasso di utilizzo del networking con applicazioni di AI tende ad essere in media del 95%, richiedendo latenza molto ridotta: è indispensabile gestire al meglio le congestioni del network e secondo AMD questo richiede di continuare lo sviluppo dell'interfaccia Ethernet, considerata essere non solo quella più diffusa e accessibile sul mercato ma anche capace di offrire un ideale connubio tra prestazioni, flessibilità di configurazione e costo.

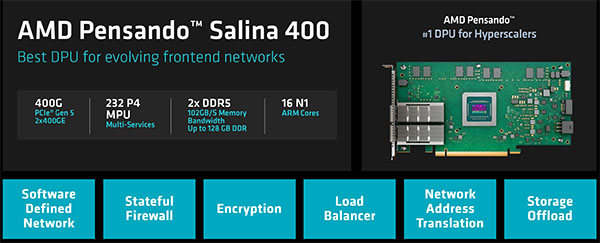

Da questo nasce il lavoro specifico dell'azienda, con la terza generazione di engine AMD P4 completamente programmabile che può toccare velocità di trasferimento di 400 Gb/s sino a 120 milioni di pacchetti al secondo e 5 milioni di connessioni al secondo.

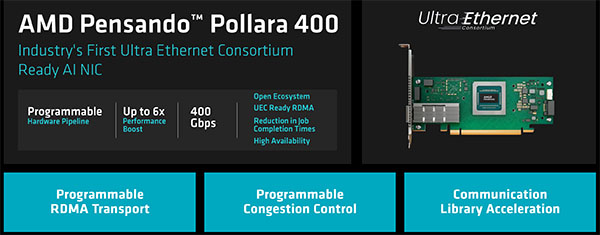

Sono due le proposte che AMD annuncia quest'oggi per la propria struttura di networking: AMD Pensando Salina 400 e AMD Pensando Pollara 400. La prima è pensata per rispondere alle specifiche esigenze del front-end del network, mentre per la seconda il target di riferimento è quello delle soluzioni AI con la previsione che questa sarà la prima proposta certificata dal consorzio UltraEthernet.

Per rafforzare lo sviluppo dell'infrastuttura di rete ed evolvere il ruolo delle connessioni Ethernet AMD è entrata come socio fondatore all'interno dell'Ultra Ethernet Consortium: il consorzio è stato fondato 15 mesi fa e al momento conta 97 membri. Il target è quello di avere le prime specifiche UEC 1.0 nel corso del primo trimestre del 2025, periodo nel quale debutteranno anche i primi prodotti certificati tra i quali vi saranno le soluzioni AMD Pensando Pollara 400.

Advancing AI 2024 è stata per AMD l'occasione di fare il punto sia sull'attuale scenario del mercato dei datacenter, sia di offrire uno sguardo ai prodotti che arriveranno nei prossimi mesi. Sono due i trend che emergono, entrambi legati ad una domanda di soluzioni di elaborazione per i datacenter che no sembra voler conoscere sosta. Il primo è che AMD si propone sempre più come un'azienda in grado di offrire un pacchetto di soluzioni completo che tenga conto delle necessità di elaborazione lato CPU e GPU, oltre che dell'infrastruttura di rete.

Il secondo è che la crescita della quota di mercato di AMD nel settore dei datacenter è stata repentina negli ultimi anni ma che la spinta non sembra destinata a calare. E' questo il tempo della maturità per AMD, alle prese con la pressione competitiva di NVIDIA dal comparto GPU e di Intel per quanto riguarda i processori ma che a quest'oggi è stata capace di dimostrare alle aziende del settore di essere un partner affidabile in grado di garantire uno sviluppo futuro, con le proprie roadmap, certo e prevedibile.

Polestar 3 Performance, test drive: comodità e potenza possono convivere

Polestar 3 Performance, test drive: comodità e potenza possono convivere Qualcomm Snapdragon X2 Elite: l'architettura del SoC per i notebook del 2026

Qualcomm Snapdragon X2 Elite: l'architettura del SoC per i notebook del 2026 Recensione DJI Mini 5 Pro: il drone C0 ultra-leggero con sensore da 1 pollice

Recensione DJI Mini 5 Pro: il drone C0 ultra-leggero con sensore da 1 pollice Le auto cinesi battono tutti: ecco chi accelera più di Tesla e Lamborghini

Le auto cinesi battono tutti: ecco chi accelera più di Tesla e Lamborghini I 2 portatili tuttofare più venduti del Black Friday: MSI Modern da 549€ spopola, ma c'è un HP da 499€ eccezionale

I 2 portatili tuttofare più venduti del Black Friday: MSI Modern da 549€ spopola, ma c'è un HP da 499€ eccezionale Roborock Q7 M5 da 10.000Pa in offerta Black Friday: il robot che lava e aspira scende a 149€, occasione da prendere al volo

Roborock Q7 M5 da 10.000Pa in offerta Black Friday: il robot che lava e aspira scende a 149€, occasione da prendere al volo

6 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoZen 6 sicuro, rdna5 penso in parte

Roba mostruosa comunque, la mi325x fa +30% sulla h200 e su tutte le precisioni

Adesso è ora di spingere ancora di più sul sw (librerie, sdk, partnership con software house, ecc, ecc).

Il monopolio (CUDA) non è mai una cosa positiva.

Adesso è ora di spingere ancora di più sul sw (librerie, sdk, partnership con software house, ecc, ecc).

Il monopolio (CUDA) non è mai una cosa positiva.

Del monopolio CUDA si lamentano tutti,non solo AMD e Intel ma pure Keller con Tenstorrent.

Sarà anche buono cuda ma sembra che ci sia un astio artificiale per usare software alternativi,non vorrei dire mazzette ma, è quello su cui stanno indagando alcune autorità sulla IA e il software che ci gira intorno e su come una sola azienda ha viziato il mercato,anche con contratti "sporchi".....

Non voglio arrivare a pensare questo, ma a credito di Nvidia bisogna riconoscere che:

- CUDA è uscito prima di tutte le altre alternative ed era più semplice.

- Nvidia ha creduto e spinto su CUDA fin da subito.

Ovvio che, negli anni, se gli sviluppatori sono cresciuti con CUDA è anche difficile farli "migrare" verso altri linguaggi/piattaforme.

Ci stanno provando quelli dello standard ISO C++, spingendo quel linguaggio come un "base" tra le varie piattaforme (Cuda, OpenCl, Rocm, ecc)

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".