Oltre cloud e data center: l’IA si estende sull’edge. Massimo Chiriatti di Lenovo ci spiega perché

di Alberto Falchi , Vittorio Manti pubblicata il 09 Ottobre 2023, alle 17:31 nel canale data

A tu per tu con Massimo Chiriatti di Lenovo, uno dei principali esperti di intelligenza artificiale, che ci spiega come questa tecnologia sta cambiando il modo di lavorare. E come Lenovo sta affrontando questa rivoluzione, con nuovi dispositivi e servizi per portare l'IA sull'edge

Recentemente Lenovo ha annunciato una serie di nuovi servizi e soluzioni di intelligenza artificiale sull’edge. Fra questi, Lenovo TruScale for Edge and AI, che consente alle aziende di implementare rapidamente l’IA lì dove i dati sono generati, con un modello di pagamento a consumo. Ma anche Lenovo ThinkEdge SE455 V3, che secondo la multinazionale è a oggi il server edge più potente sul mercato, adatto anche ai carichi di lavoro più impegnativi rispetto all’IA.

.png)

L’IA si sta quindi spostando verso l’edge? Non proprio. "L'IA non si sposta, ma si estende. Continuiamo ad avere l'IA nel data center, ma abbiamo l’esigenza di estenderla anche al di fuori. Ci sono motivazioni sociali, tecniche ed economiche per farlo". Lo sottolinea Massimo Chiriatti, Chief Technology Officer, Infrastructure Solutions Group, Italy di Lenovo, che è anche autore del libro Incoscienza Artificiale, che approfondisce proprio le tematiche legate all’intelligenza artificiale. Ma quali sono queste motivazioni?

IA sull’edge: le motivazioni tecniche

Portare l’intelligenza artificiale sull’edge è un vantaggio prima di tutto dal punto di vista tecnico. Facendolo, ci si apre alla possibilità di applicare l’intelligenza artificiale ai dati lì dove sono generati, abbassando di molto le latenze. Applicare l’IA solo sul cloud, infatti, “impone di mandare tutto lo stream di informazioni verso i data center, elaborarlo e poi rimandare indietro i dati lavorati. Oggi non è più opportuno farlo. Abbiamo bisogno di fare analisi “qui e ora”, dove nasce il dato“, sottolinea Chiriatti. “Analizzi tutto subito e, in caso di eventi particolari, mandi solo questi dati sul cloud, non tutto lo stream. Dal momento che la tecnologia sta migliorando, dobbiamo trovare una combinazione che permette di elaborare i carichi di lavoro sull’edge”. Il riferimento è ai sistemi ThinkEdge di Lenovo, estremamente potenti – anche sotto il profilo delle GPU - e allo stesso tempo compatti. Ma la potenza di calcolo, pur fondamentale, non è l’unica caratteristica richiesta a queste macchine. Che devono essere dotate di dispositivi di sicurezza particolari, come le misure antitampering che “distruggono” l’hardware se viene rilevato un tentativo di intrusione fisica o manomissione. E anche in grado di resistere a condizioni ben diverse dai data center: sull’edge non possiamo aspettarci ambienti confortevoli come nei data center, e di conseguenza è necessario realizzare macchine in grado di resistere a polvere, schizzi d’acqua e anche temperature estreme, sia verso l’alto sia verso il basso. Nel caso dei ThinkEdge, parliamo di dispositivi in grado di operare senza problemi in un arco di temperature compreso fra i -5° e +55°.

IA sull’edge: le motivazioni economiche e sociali

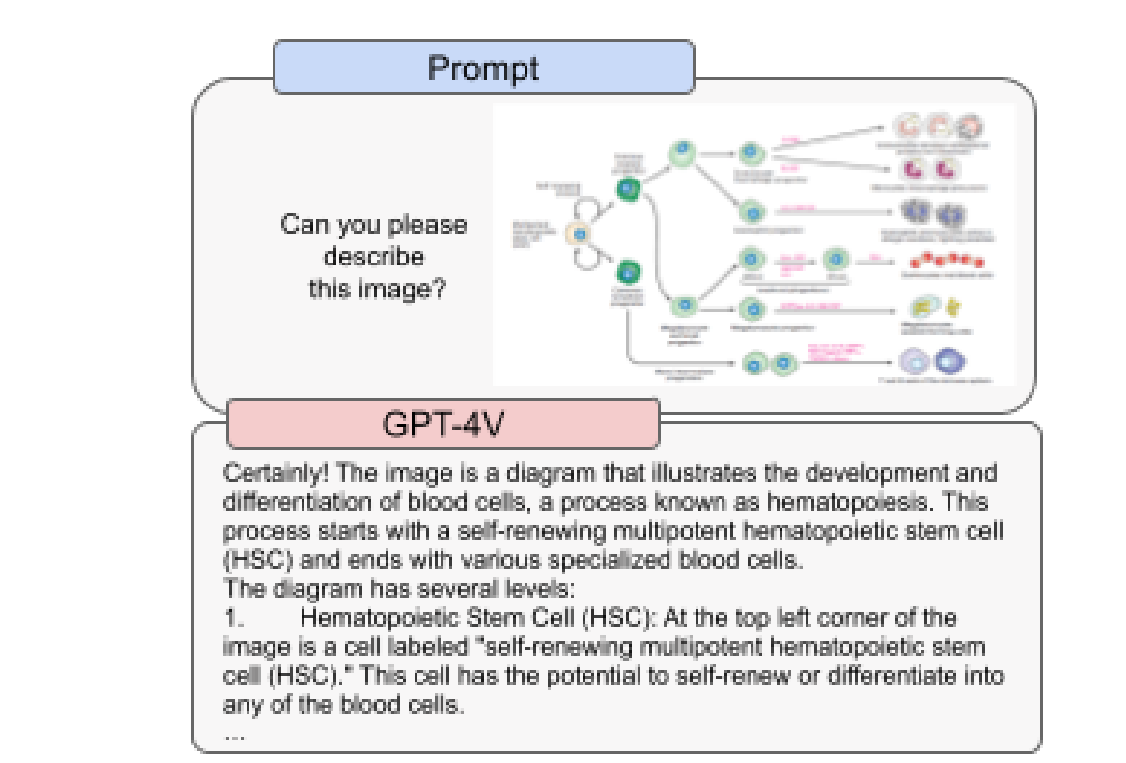

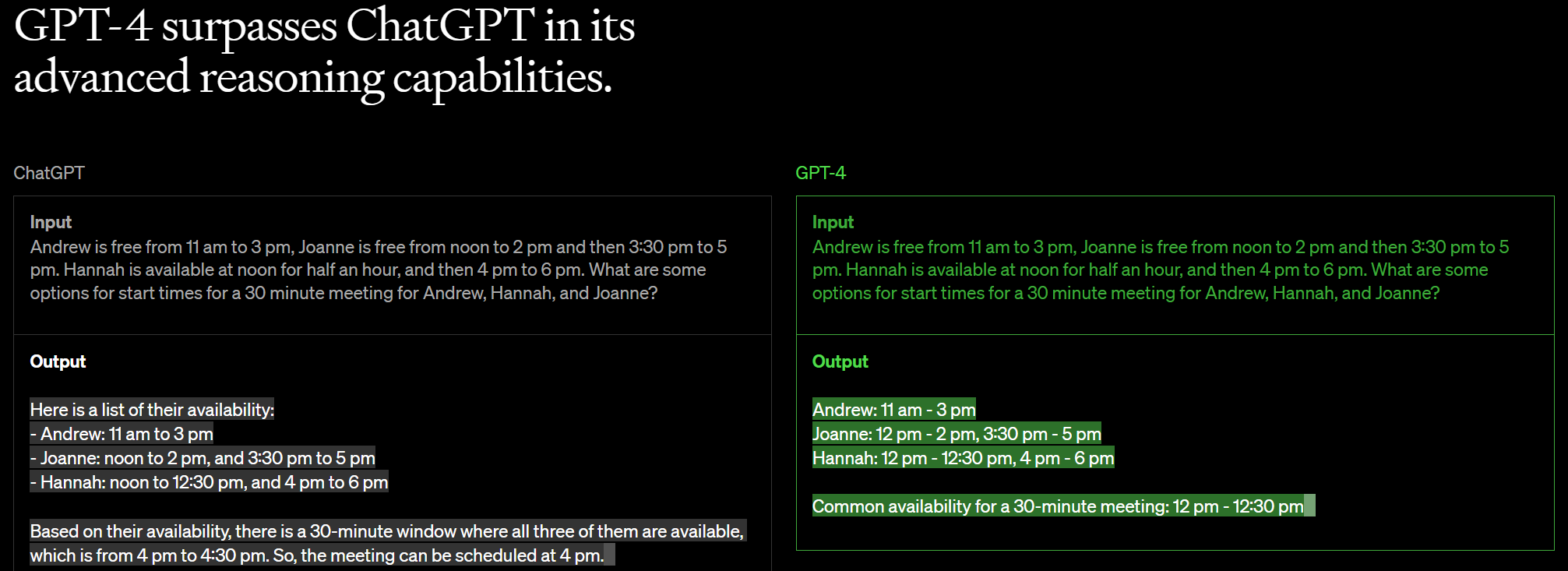

Abbassare le latenze non è l’unico motivo per applicare l’IA sull’edge. Secondo Chiriatti è importante anche “poter decentralizzare i carichi di lavoro”. Oltre che consentire l’accesso a queste tecnologie anche alle piccole e medie imprese, che non hanno sufficienti risorse economiche per acquistare e gestire in casa i server più potenti. Ma l’aspetto che più preme sottolineare al manager di Lenovo è il cambio culturale che stiamo attraversando. Chiriatti cita il recente annuncio di GPT-4V, un nuovo modello di IA generativa progettata per aprire le porte alla computer vision.

Non parliamo di un generatore di immagini, ma di uno strumento in grado di analizzare le immagini che gli vengono fornite. “Stiamo culturalmente passando da una situazione in cui ci scambiamo informazioni [con le macchine] digitando su una tastiera a una comunicazione attraverso il parlato e, successivamente, al video”, afferma Chiriatti, sottolineando come ognuno di questi passaggi porti a un maggior numero di informazioni. Facendo un paragone con la comunicazione con le persone, è come passare da una e-mail a una telefonata, con le sue sfumature di intonazione, per arrivare alla videochiamata, che include anche una serie di informazioni non verbali, come i gesti delle mani e le espressioni facciali. “Un’immagine vale 1000 parole”, scherza Chiriatti, sottolineando che ora stiamo iniziando ad applicare questo approccio anche alla comunicazione con le macchine. Video e immagini, però, richiedono molta più banda e sarebbe impensabile di muovere tutto verso i data center o il cloud. Per questo motivo l’IA sull’edge, secondo Chiriatti, acquisirà una sempre crescente importanza.

.png)

Chiriatti evidenzia anche un altro aspetto: i nuovi server edge non sono caratterizzati solo da una maggior potenza di calcolo. L’aspetto più rilevante, secondo il manager, è che cambia (in meglio) il rapporto prezzo/prestazioni, e questo spinge le imprese a cambiare anche i loro modelli di business. Pensiamo alla tipica PMI che tende a fare le sue previsioni basandosi sull’intuito. Se potesse permettersi un server edge in grado di elaborare le informazioni sul campo e ricavarne insights con poca spesa, il modello di business si adatterebbe di conseguenza, e al posto dell’intuito le previsioni potranno basarsi sui dati.

C’è anche un altro aspetto, legato alla privacy e alla sicurezza: questi server sono sufficientemente potenti da poter elaborare i LLM in locale, senza passare per il cloud e i servizi degli hyperscaler. Questo significa avere la certezza che le proprie informazioni non usciranno mai dal perimetro dell’azienda, un vantaggio non da poco, soprattutto per le aziende che operano in UE, e devono conformarsi a rigide normative sulla gestione dei dati.

Comprendere vantaggi e limitazioni dell’IA generativa

ChatGPT e altre forme di IA generativa sono state in grado di stupire per la loro capacità, ma hanno degli innegabili limiti, a partire dalle famose “allucinazioni”, cioè il fatto che si inventano – letteralmente - informazioni. Questo accade perché i sistemi di IA generativa attualmente disponibili forniscono risposte probabilistiche: mettono insieme sequenze di caratteri formalmente corrette, ma non è detto che siano sempre attendibili, e per questo è sempre necessario verificarle. Se questo può essere un concetto ovvio per gli addetti al settore, non è scontato che lo sia per il grande pubblico.

Per spiegare questo concetto, Chiriatti fa un paragone. “Immagina di bere da un idrante. Con un prompt sussurri qualcosa, poi vieni invaso dall’output”. Per il manager “dobbiamo ricostruire i modi con i quali comprendiamo questa realtà”. Un tema che Chiriatti ha affrontato già nel 2020 in un paper scritto insieme al filosofo Luciano Floridi. Un testo nel quale spiegava come GPT-3 non è una macchina deduttiva, non è come un normale software per il quale io scrivo le regole, le traduco in codice e la macchina esegue quanto richiesto. “È una macchina induttiva, che trova dei dati e genera un output”. Per utilizzare l’IA generativa in maniera adeguata è fondamentale comprendere questo concetto, tanto che Lenovo si occupa di formazione, anche nelle scuole, su questi temi. Formazione mirata a spiegare ai ragazzi, anche nelle università, a cosa servono questi strumenti e come vanno utilizzati. Un tema, quello della formazione, molto caro a Chiriatti. Se non si investe sulla formazione, a partire dalle scuole, il Paese non può fare dei balzi in avanti. “Se non colmiamo questi gap culturali – spiega il manager – gli imprenditori non investiranno sulla tecnologia”. E gli imprenditori vanno rassicurati e supportati: è importante aiutarli a comprendere di quali tecnologie hanno realmente bisogno, non cercare di limitarsi a vendergli qualsiasi soluzione a catalogo.

Privacy e accentramento di potere

Abbiamo accennato prima al fatto che applicare l’IA sull’edge può significare anche eseguire i LLM in locale, su hardware proprietario, con maggiori garanzie di privacy, ma anche evitando di addestrare i modelli delle grandi multinazionali, col rischio di dare loro ancora più potere e limitare la concorrenza. Secondo Chiriatti, sotto un certo profilo siamo fortunati. Perché non tutte le aziende hanno bisogno di modelli di IA estremamente complessi, per esempio LLM che supportano 200 lingue. In molti casi, sono sufficienti modelli meno evoluti e che quindi richiedono meno potenza di calcolo. Modelli che, al contrario di quelli mastodontici come GPT-3 o simili, possono essere gestiti anche da un singolo, ma potente, server edge. E qui torniamo al tema iniziale: avere server edge sempre più potenti e con un miglior rapporto costo/prestazioni permetterà di diffondere maggiormente modelli di IA a misura di PMI, meno generalisti, adatti a specifici casi d’uso. “Per andare da Roma a Milano non hai bisogno di una Formula 1”, scherza Chiriatti, spiegando che il suo lavoro in Lenovo è quello di aiutare le aziende a comprendere quello di cui hanno bisogno sotto il profilo della tecnologia. Solo così possono comprendere cosa possono fare con l’IA, e quanto possono risparmiare investendo nella sua adozione, capire che “possono non solo aumentare le vendite o risparmiare di più, ma anche creare qualcosa di nuovo”.

Il futuro dell’IA secondo Chiriatti

Ma cosa possiamo aspettarci dall’IA nel futuro a breve termine, diciamo 4/5 anni? Chiriatti, sottolineando di non potere prevedere il futuro, ci racconta che auspica di vedere modelli “non solo open asset, come oggi, ma anche open source”. Oggi è infatti possibile prendere un LLM già pronto e addestrarlo sui propri dati (open asset), ma sono per lo più ancora proprietari. “Io vorrei vedere tanti modelli open source puri, perché così si amplia il mercato, e aumentano le possibilità di scelta per gli imprenditori”. Un vantaggio quindi per gli utenti finali, cioè le imprese che adottano questi modelli. Ma anche per realtà come Lenovo, che non guadagnano creando e distribuendo LLM, ma fornendo alle imprese le infrastrutture necessarie a gestirli.

Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello

Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello Acer TravelMate P4 14: tanta sostanza per l'utente aziendale

Acer TravelMate P4 14: tanta sostanza per l'utente aziendale Hisense M2 Pro: dove lo metti, sta. Mini proiettore laser 4K per il cinema ovunque

Hisense M2 Pro: dove lo metti, sta. Mini proiettore laser 4K per il cinema ovunque Xbox: dal prossimo mese verifica dell'identità obbligatoria in UK, in futuro anche in altre regioni

Xbox: dal prossimo mese verifica dell'identità obbligatoria in UK, in futuro anche in altre regioni Corsair AI Workstation 300: poco più grande di un Mini PC, ma con la potenza di un desktop

Corsair AI Workstation 300: poco più grande di un Mini PC, ma con la potenza di un desktop Addio a Elio Marioli, un pioniere della mobilità elettrica quando nessuno ne parlava

Addio a Elio Marioli, un pioniere della mobilità elettrica quando nessuno ne parlava

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".