Con Edge AI Storage Server QNAP porta l'IA on premise

di Alberto Falchi pubblicata il 11 Giugno 2025, alle 15:49 nel canale Device

Il QNAP Edge AI Storage Server consente di gestire con grande flessibilità macchine virtuali e applicazioni containerizzate per modelli linguistici di grandi dimensioni privati e carichi di lavoro di IA. È ideale per l'installazione in uffici intelligenti, in fabbrica, nel retail e per la sorveglianza basata su IA

La soluzione QNAP Edge AI storage server mette a disposizione delle aziende una soluzione di IA privata e sicura. A tutti gli effetti, parliamo di una soluzione di edge computing all in one, che integra storage, virtualizzazione e calcolo, appoggiandosi a una GPU integrata. I clienti potranno utilizzarla per realizzare infrastruttura di IA in locale, potendo contare su una maggiore sicurezza dei dati e su un maggior controllo sui costi per l'utilizzo dell'IA.

Con QNAP Edge AI storage server gli LLM possono essere eseguiti in locale

Sempre più aziende, PMI incluse, stanno adottando l'IA per ottimizzare ed efficientare i processi, ma in certi casi appoggiarsi a soluzioni cloud non è il massimo. Ci sono situazioni in cui poter gestire localmente l'infrastruttura di IA offre maggiori garanzie in termini di conformità normativa e di privacy dei dati. QNAP Edge AI storage server nasce per supportare queste esigenze, oltre a offrire una soluzione completa e versatile per storage, backup e per la gestione delle macchine virtuali, come praticamente tutti i NAS dell'azienda.

Nello specifico, il modello QAI-h1290FX, in uscita a breve, è basato su processore AMD EPYC 7302P a 16-core, è dotato di 256 GB di RAM e supporta un massimo di 12 unità flash NVMe. I pesanti calcoli relativi all'IA sono invece affidati a una GPU NVIDIA RTX 6000 con 48 GB di VRAM GDDR6.

Una soluzione che ovviamente non può competere con server dedicati dotati di decine di GPU, ma che è sufficientemente potente da eseguire modelli linguistici di piccole dimensioni (SLM) e anche LLM. Fra i casi d'uso tipici di un simile dispositivo la videosorverglianza "intelligente", dove l'IA si occupa del riconoscimento facciale: considerati i dati sensibili trattati, questo tipo di applicazioni è meglio che venga eseguito in locale, sull'edge, così da non passare informazioni sul cloud.

Non è l'unico esempio: altri ambiti dove il piccolo ma potente server può distinguersi sono lo smart retail, per esempio l'analisi dei flussi di persone nei punti vendita, e la manifattura. Integrare un sistema di IA in un impianto produttivo permette di abilitare funzioni evolute come la manutenzione predittiva dei macchinari.

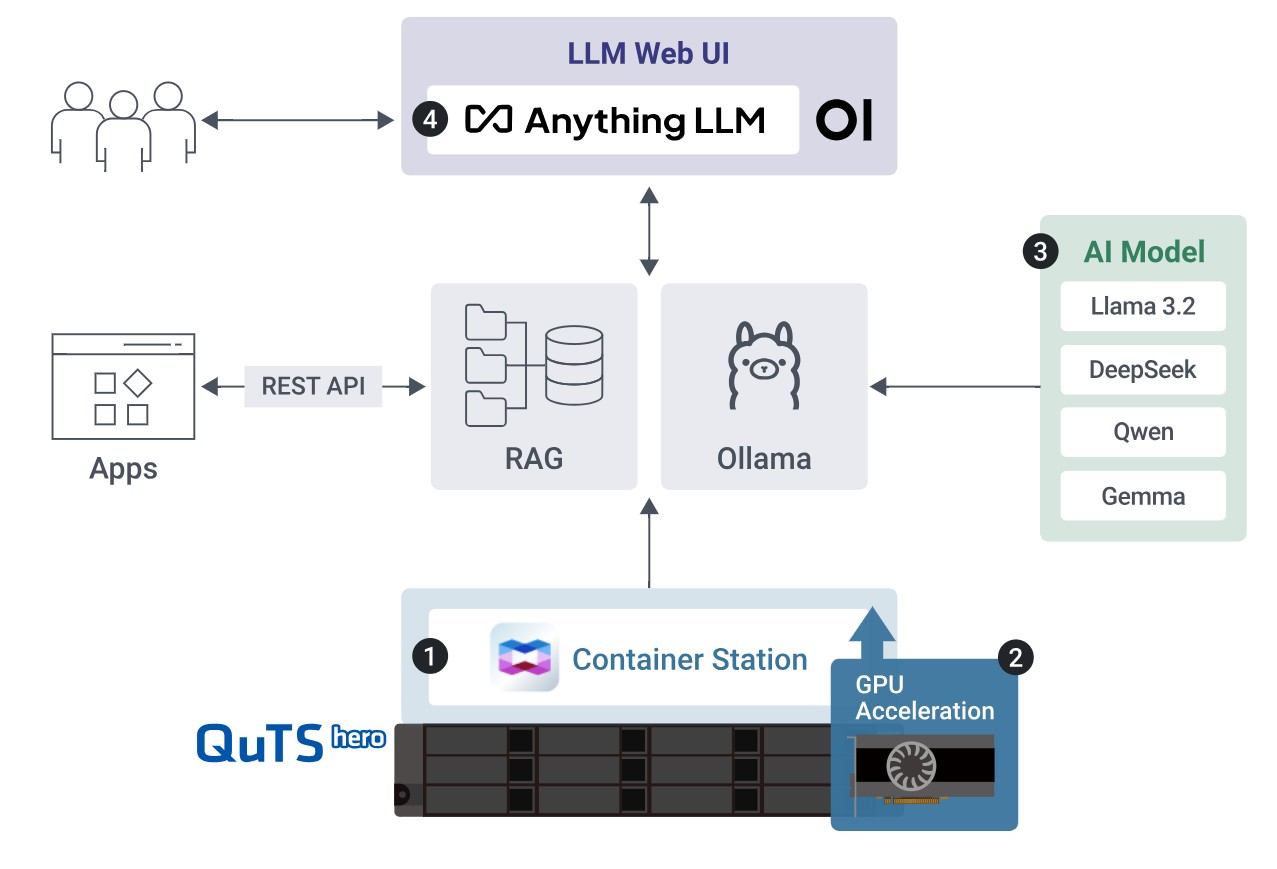

Per gestire l'IA in locale QNAP ha scelto di affidarsi ad Ollama, software che permette di distribuire facilmente diversi modelli linguistici di grandi dimensioni open source, come LLaMA, DeepSeek, Qwen e Gemma, e offre la possibilità di cambiare o aggiornare i modelli secondo le proprie esigenze.

"L'attenzione sull'AI si è spostata dal semplice sviluppo dei modelli alla realizzazione dell'infrastruttura giusta”, spiega CT Cheng, Product Manager di QNAP. “Per le aziende che adottano LLM, AI generativa o virtualizzazione, ciò che conta davvero è disporre di una piattaforma in grado di gestire grandi dataset, garantire la sicurezza dei dati e fornire prestazioni affidabili. Il nostro Edge AI Storage Server è molto più di un semplice sistema storage. Integra funzionalità di inferenza IA, virtualizzazione e backup per aiutare le aziende a implementare l'IA in modo sicuro e flessibile”.

Intervista a Stop Killing Games: distruggere videogiochi è come bruciare la musica di Mozart

Intervista a Stop Killing Games: distruggere videogiochi è come bruciare la musica di Mozart Samsung Galaxy S25 Edge: il top di gamma ultrasottile e leggerissimo. La recensione

Samsung Galaxy S25 Edge: il top di gamma ultrasottile e leggerissimo. La recensione  HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto

HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto Tesla sta per lanciare il Robotaxi nella Bay Area, ma ancora una volta è FSD con supervisore a bordo

Tesla sta per lanciare il Robotaxi nella Bay Area, ma ancora una volta è FSD con supervisore a bordo Dead Island 2 arriva su Mac, ma a un prezzo triplo rispetto a Steam e senza cross-play

Dead Island 2 arriva su Mac, ma a un prezzo triplo rispetto a Steam e senza cross-play FIA e Formula E rinnovano il matrimonio: campionato elettrico fino al 2048

FIA e Formula E rinnovano il matrimonio: campionato elettrico fino al 2048

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".