VMware presenta Project Capitola: in arrivo i server di memoria?

di Riccardo Robecchi pubblicata il 20 Ottobre 2021, alle 18:10 nel canale Device

VMware ha presentato Project Capitola, una soluzione software per creare dei "server di memoria", ovvero server che fungano di fatto da memoria swap di rete

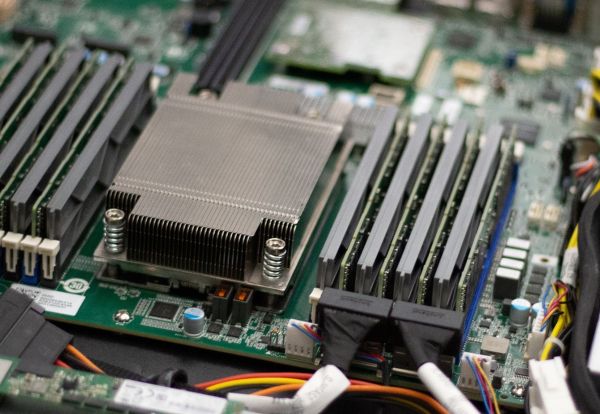

Nonostante da tempo si parli di infrastrutture iperconvergenti, in cui ciascun server è dotato delle risorse necessarie a svolgere qualunque ruolo, VMware vede nel futuro un concetto differente: l'azienda ha infatti recentemente presentato a VMworld 2021 Project Capitola, un sistema per condividere memoria RAM tramite la rete che potrebbe portare alla creazione di server di memoria.

VMware propone Project Capitola, aprendo la strada ai "memory server"

Il principio di località è un noto principio dell'informatica che afferma come sia molto probabile che una certa istruzione sia ripetuta entro poco tempo o, dall'altro lato, che un ristretto insieme di istruzioni o dati sia usato in maniera preponderante durante l'esecuzione di un programma. Tale concetto è, ad esempio, alla base dello sviluppo delle cache, che sfruttano proprio questa caratteristica per mettere a disposizione un modo più rapido di accedere a tali istruzioni o dati. La memoria swap è invece il risultato dell'inverso: le pagine di memoria meno usate possono essere spostate fuori dalla RAM perché è molto probabile che siano usate poco anche in futuro.

Visto il prezzo elevato della RAM e dell'aggiornamento dei server, VMware vede la possibilità di creare un nuovo livello nella gerarchia della memoria che si posizioni poco sopra lo swap: Project Capitola punta infatti a consentire ai server che eseguono vSphere di spostare le pagine di memoria meno usate su server terzi, il cui scopo precipuo è quello di mettere a disposizione la propria RAM ad altri dispositivi sulla rete. In questo modo si creerebbero, di fatto, server di memoria, esattamente come esistono server di storage.

L'idea non è nuova, visto che la paginazione della memoria sulla rete era già stata sperimentata negli anni '80, ma secondo VMware questo metodo potrebbe portare a risparmi significativi nell'acquisto dell'hardware: la società stima che la spesa sia inferiore del 30-50%, in gran parte perché è possibile aggiungere memoria in un secondo momento senza dover rimpiazzare la precedente. VMware afferma inoltre che non sarebbe necessario aggiornare i software se questi sono già compatibili con l'esecuzione all'interno di una macchina virtuale, poiché il meccanismo di paginazione via rete sarebbe perfettamente trasparente.

Dall'altro lato, però, l'azienda non nasconde che ci sarebbe una riduzione nelle prestazioni. Tale calo può essere anche significativo, in base al tipo di applicazione, e c'è da tenere in considerazione il fatto che anche la rete è coinvolta, dato che il traffico aumenta e dev'essere pertanto disponibile banda sufficiente.

Non è dato sapere se quest'idea avrà successo, ma VMware ha già affermato che Dell e Cisco hanno espresso interesse, così come piccoli fornitori di servizi cloud che vedono una buona opportunità di business in server dalle prestazioni inferiori con, però, un prezzo più contenuto.

Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello

Ryzen Threadripper 9980X e 9970X alla prova: AMD Zen 5 al massimo livello Acer TravelMate P4 14: tanta sostanza per l'utente aziendale

Acer TravelMate P4 14: tanta sostanza per l'utente aziendale Hisense M2 Pro: dove lo metti, sta. Mini proiettore laser 4K per il cinema ovunque

Hisense M2 Pro: dove lo metti, sta. Mini proiettore laser 4K per il cinema ovunque Xbox: dal prossimo mese verifica dell'identità obbligatoria in UK, in futuro anche in altre regioni

Xbox: dal prossimo mese verifica dell'identità obbligatoria in UK, in futuro anche in altre regioni Corsair AI Workstation 300: poco più grande di un Mini PC, ma con la potenza di un desktop

Corsair AI Workstation 300: poco più grande di un Mini PC, ma con la potenza di un desktop Addio a Elio Marioli, un pioniere della mobilità elettrica quando nessuno ne parlava

Addio a Elio Marioli, un pioniere della mobilità elettrica quando nessuno ne parlava

6 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoNon credo sia pensato per quello scopo.

Sono soluzioni pensati all'interno di datacenters, dove i collegamenti frà i server sono fatti con link frà i 40 e i 100 gbit, e forse anche più se si usano tecnologie proprietarie.

In quel caso, una soluzione del genere, può anche avere un senso per alcune applicazioni.

Sono soluzioni pensati all'interno di datacenters, dove i collegamenti frà i server sono fatti con link frà i 40 e i 100 gbit, e forse anche più se si usano tecnologie proprietarie.

In quel caso, una soluzione del genere, può anche avere un senso per alcune applicazioni.

C'è un'asimmetria tale tra la velocità del bus CPU/RAM (anche con numa e sistemi multisocket) e quello di un link infiniband con RDMA tale che non riesco ad immaginare per quali applicazioni una roba del genere possa essere utile ed eventualmente più economica di fare upgrade del ferro.

Tra l'altro le HBA e gli switch infiniband di fascia alta non li regalano con i fustini del dash.

Tra l'altro le HBA e gli switch infiniband di fascia alta non li regalano con i fustini del dash.

Non sono poi così costosi se puoi permetterti di avere 1 nodo solamente che faccia da "memory server" di VMWare, visto che un server discreto lo paghi almeno 10k€

Noi abbiamo speso 35k€ per 4 switch HPE A5830AF-48G.

Se decidi di applicare quella scelta architetturale, sicuramente non compri un solo memory server da collegare punto punto con un compute node.

Uno swtich 40 porte HDR infiniband costa sulle 30k, a cui aggiungere $800 di scheda HBA per una porta da 100Gb/s + $200 di cavo IB per ogni server.

Questo per avere 12.5GB/s ipotetici (saranno una decina se usi RDMA) di throughput verso le ram remote.

Continuo a pensare che ti costa meno fare upgrade delle ram dei nodi ed hai performance triple.

Tra l'altro, quando dimensioni dei nodi compute, lo fai in base al carico che devono sostenere. Dover pluggare della ram esterna in pratica significa ammettere che si è fatta una cappellata in fase di dimensionamento dell'infrastruttura IMHO.

Uno swtich 40 porte HDR infiniband costa sulle 30k, a cui aggiungere $800 di scheda HBA per una porta da 100Gb/s + $200 di cavo IB per ogni server.

Questo per avere 12.5GB/s ipotetici (saranno una decina se usi RDMA) di throughput verso le ram remote.

Continuo a pensare che ti costa meno fare upgrade delle ram dei nodi ed hai performance triple.

Tra l'altro, quando dimensioni dei nodi compute, lo fai in base al carico che devono sostenere. Dover pluggare della ram esterna in pratica significa ammettere che si è fatta una cappellata in fase di dimensionamento dell'infrastruttura IMHO.

Sono d'accordo con te, però probabilmente, anzi, sicuramente queste soluzioni sono nate per hardware dove non è più possibile fare upgrade e che dovresti cambiarlo.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".