AMD espande le CPU EPYC per il datacenter e lancia una GPU dedicata all'AI

di Paolo Corsini pubblicato il 13 Giugno 2023 nel canale Device

In occasione dell'evento Data Center & AI Technology Premiere AMD ha annunciato nuove versioni di processore EPYC di quarta generazione, segmentando al meglio la propria offerta per il datacenter. Non solo CPU: tra le novità anche proposte per il networking che scaricano la CPU di calcoli gravosi e una nuova GPU, MI300X, dedicata alle elaborazioni di intelligenza artificiale

Le nuove CPU della famiglia EPYC

È a San Francisco, in occasione dell'evento "Data Center & AI Technology Premiere" che Lisa Su, CEO di AMD, ha presentato le novità dell'azienda americana per il mondo del datacenter. Al centro degli annunci non solo i processori della famiglia EPYC ma anche acceleratori dedicati all'intelligenza artificiale, prodotti che sono fondamentali nel processo di trasformazione che sta caratterizzando il mondo dei datacenter, e soluzioni specifiche per il networking che liberano risorse di calcolo del processore all'interno dei sistemi.

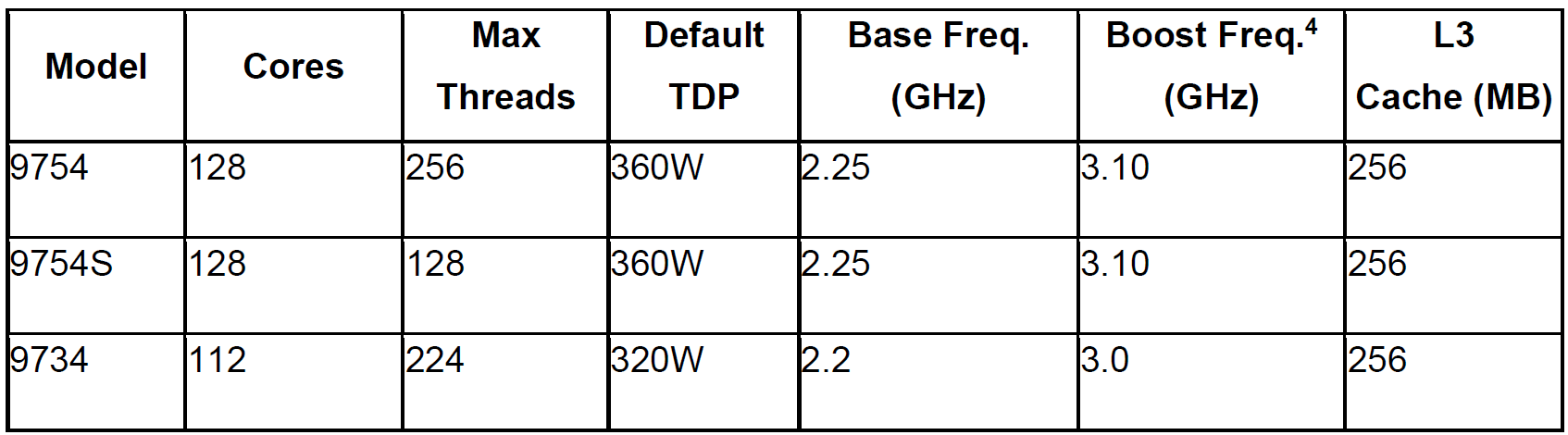

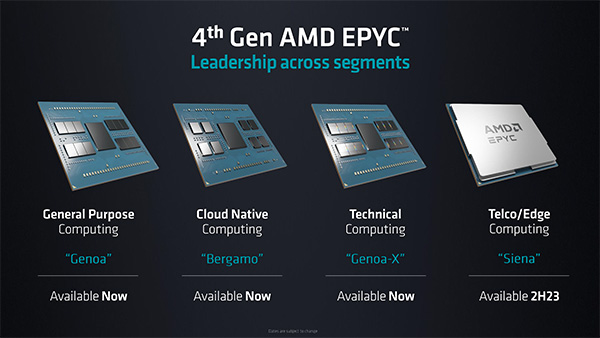

La prima novità sono i nuovi processori della famiglia EPYC di quarta generazione, che si affiancano alle soluzioni Genoa annunciate dall'azienda lo scorso novembre. Troviamo ora nella gamma anche le CPU EPYC di quarta generazione indicate con il nome di Bergamo, che integrano sino a 128 core della famiglia Zen 4c. Queste CPU sono pensate per quegli scenari di utilizzo nei quali si deve massimizzare la densità in termini di numero di core, come ad esempio negli scenari cloud nei quali permettono di avere un elevato numero di virtual machine contemporaneamente in uso.

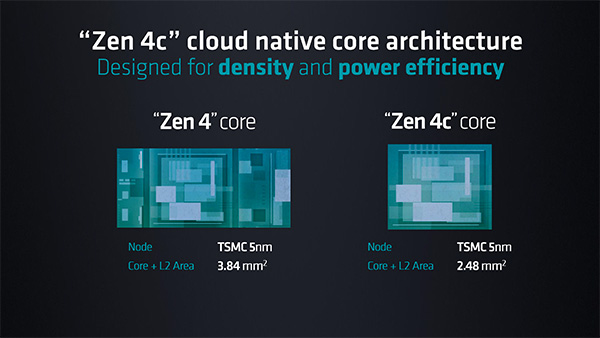

Le caratteristiche tecniche dei core Zen 4c sono speculari a quelle dei core Zen 4 adottati delle CPU EPYC Genoa, con alcune differenze sostanziali legate alla cache L3 per core che è stata dimezzata passando da 4MB a 2MB. AMD è intervenuta anche a livello di transistor ridisegnando alcune delle componenti interne con il fine di ridurre la superficie complessiva del die. Questo è stato reso possibile fissando una frequenza di clock massima inferiore ai 6GHz che sono il target di Zen 4, aprendo in questo modo spazio ad un redesign interno che ha ridotto le dimensioni.

Gli ambiti di riferimento delle CPU EPYC della famiglia Bergamo sono quelli che beneficiano di un throughput molto elevato e di un contenimento dei consumi per ogni singolo core. I core Zen 4c sono sempre basati su tecnologia produttiva a 5 nanometri, costruiti da TSMC, con una ottimizzazione interna che ha permesso di contenere la superficie di ogni singolo core del 35% rispetto a quelli Zen 4 delle proposte Genoa e al contempo di mantenere un consumo inferiore.

Cambia la struttura dei CCD all'interno del package dei processori EPYC Bergamo: troviamo infatti 8 CCD in totale, contro i 12 delle proposte Genoa, con un raddoppio nel numero di core integrati per ogni CCD. Si passa infatti dagli 8 core per CCD delle proposte Genoa ai 16 di quelle Bergamo, un aumento della densità reso possibile proprio dalla riduzione nella superficie di ogni singolo core Zen 4c rispetto ai precedenti Zen 4.

specifiche tecniche delle 3 versioni di processore AMD EPYC Bergamo

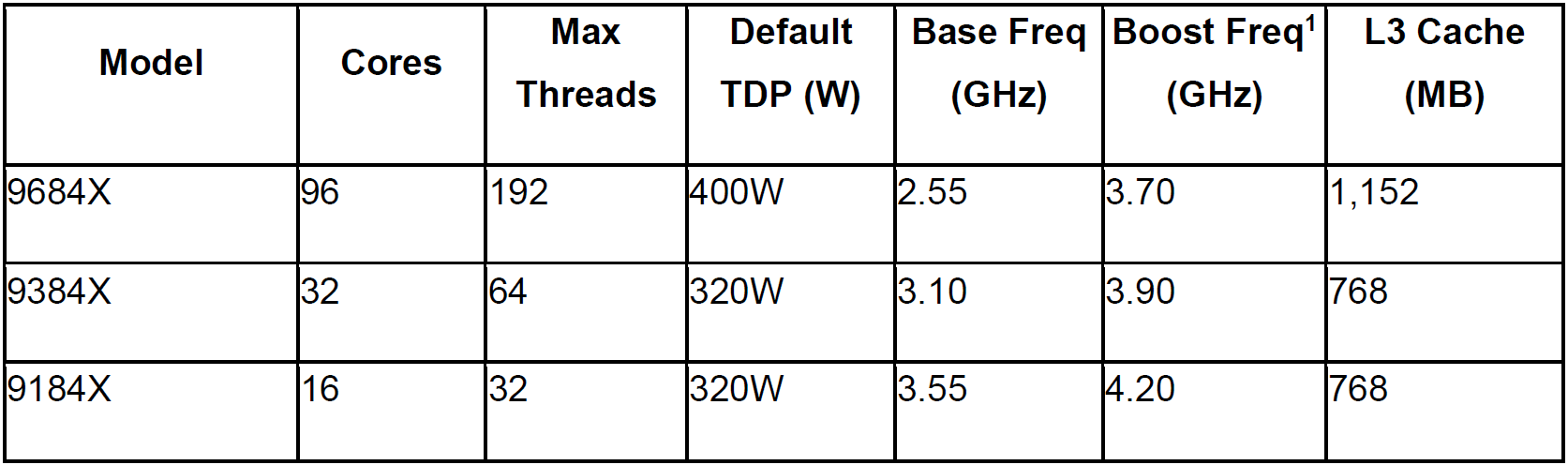

La seconda novità in ambito CPU è legata ai processori EPYC della famiglia Genoa abbinati a 3D V-Cache, indicati con il nome in codice di Genoa-X. Si tratta di soluzioni che partono dall'architettura delle soluzioni EPYC di quarta generazione arricchendole con la cache di terzo livello che abbiamo già visto adottata da AMD anche in alcune delle proposte Ryzen per il mondo consumer oltre che nelle proposte EPYC della serie Milan-X. Queste CPU arrivano a integrare sino a un massimo 1,156 GB di cache L3 complessiva nelle declinazioni con 96 core per socket (96MB di cache L3 per ognuno dei 12 CCD presenti nel processore).

specifiche tecniche delle 3 versioni di processore AMD EPYC Genoa-X

Agli annunci odierni si affiancano anche le proposte EPYC indicate con il nome in codice di Siena, previste al debutto nel corso della seconda metà del 2023. Queste CPU sono pensate per rispondere alle necessità specifiche dei clienti impegnati nel mondo delle telecomunicazioni, oltre a quelle dell'edge computing quindi dell'elaborazione dei dati che avviene non nel datacenter ma direttamente all'interno dei dispositivi di edge computing.

Con gli annunci odierni il portfolio di CPU AMD EPYC è ora nettamente segmentato: le CPU EPYC Genoa sono rivolte ai classici sistemi datacenter per general purpose computing, mentre le proposte EPYC con architettura Bergamo sono indirizzate al cloud native computing. Le proposte Genoa-X, con tecnologia 3D V-Cache, sono rivolte agli ambiti di Technical Computing più specifici nei quali la cache L3 integrata nel processore può fare la differenza in termini di tempi di elaborazione. Le proposte EPYC Siena, infine, andranno a rispondere alle necessità specifiche degli ambiti legati al mondo delle telecomunicazioni e a quello dell'edge computing.

AMD guarda oltre i processori per il datacenter

La trasformazione dei datacenter che sta avvenendo negli ultimi anni richiede però strumenti di elaborazione che sono diversi dalle sole CPU, per quanto specializzate e differenziate come l'attuale gamma EPYC di quarta generazione. Le necessità legate all'intelligenza artificiale portano allo sviluppo di soluzioni di elaborazione sempre più specialistiche, ma a questo deve essere anche affiancato il ruolo del networking nel suo complesso. AMD vede quindi la sua presenza nel datacenter non limitata alle sole CPU, ma in grado di offrire una gamma di soluzioni che rispondano alle necessità di networking e virtualizzazione oltre a quelle, sempre più pressanti, delle elaborazioni di intelligenza artificiale.

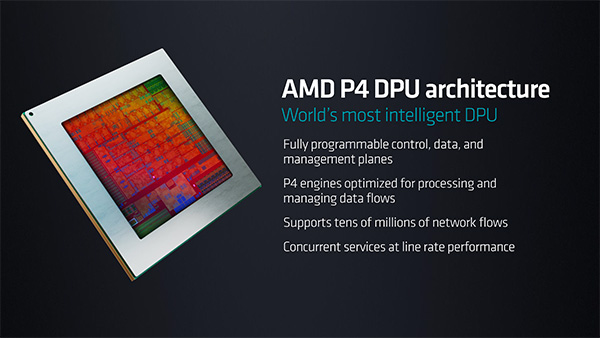

L'architettura AMD P4 DPU, data processing unit, integrata all'interno di ogni server con CPU AMD EPYC, permette di eliminare l'overhead sul processore legato alla creazione di server virtuali lasciando tutte le risorse del processore a disposizione delle elaborazioni richieste al server. È scontato evidenziare come soluzioni di questo tipo permettano di ottimizzare il funzionamento dei server all'interno del datacenter, evitando che le risorse dei processori possano venir anche in parte non sfruttate per l'elaborazione del pattern di calcolo richiesto, venendo "sprecate" per gestire un overhead generato da specifiche necessità quali quelle dei software di virtualizzazione.

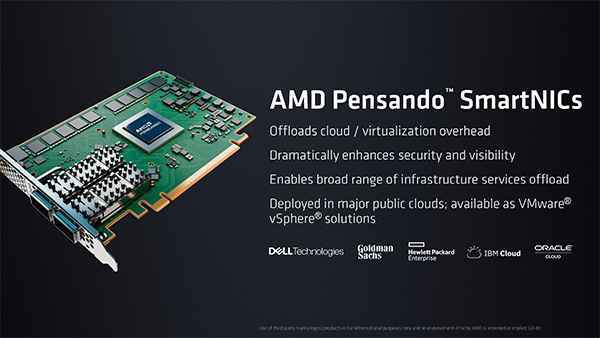

Altro prodotto che permette ad AMD di incrementare le prestazioni in datacenter sono le soluzioni di SmartNIC AMD Pensando: anche in questo caso eliminano l'overhead creato dalle operazioni di virtualizzazione. Le soluzioni P4 DPU possono venir integrate anche all'interno degli switch, con un approccio che AMD indica con il nome di smart switch e che è al momento implementato all'interno delle soluzioni HPE Aruba.

AMD è quindi impegnata, nel contesto dei datacenter, non solo a sviluppare processori della gamma EPYC che siano in grado di rispondere alle differenti necessità di elaborazione richiesti dai tipici carichi di lavoro, ma anche fornire ai propri partner tutta una serie di soluzioni hardware che possano velocizzare e ottimizzare sempre più il funzionamento dei cluster nel datacenter. Evidente in tutto questo il ruolo dell'acquisizione di Xilinx, acquistata da AMD all'inizio del 2022, oltre a quella di Pensando perfezionata nella primavera del 2022: l'integrazione in AMD di queste aziende procede in modo spedito come ben evidenziato dagli annunci odierni.

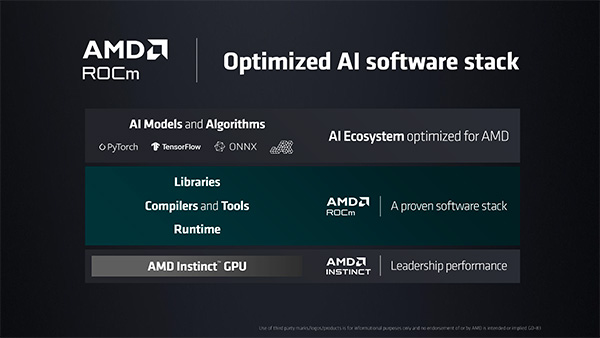

Accanto alle novità hardware AMD rimarca il ruolo fondamentale, per le elaborazioni nel datacenter, della componente software: l'approccio adottato è quello basato su AMD ROCm, lo stack software per l'intelligenza artificiale che è giunto alla quinta generazione e che si propone, con un approccio open, di essere lo strumento d'uso quotidiano nei datacenter per sfruttare al meglio la potenza delle architetture hardware.

Tutte le aziende hardware impegnate nei datacenter propongono un proprio approccio software ai carichi che verranno poi eseguiti sul proprio hardware: quale uscirà vincitore tra le differenti proposte, sempre che emerga un unico vincitore, sarà il tempo a decretarlo. Quello che possiamo ora dire è però rimarcare l'importanza di quello stack software che permette di sfruttare al meglio le architetture hardware sempre più complesse che i produttori rendono disponibili sul mercato.

Instinct MI300X: la GPU per l'AI

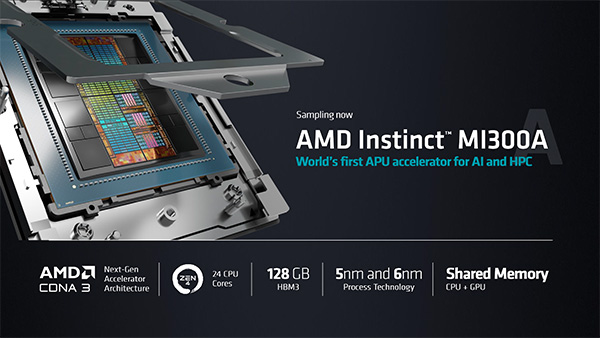

In occasione del CES 2023 di Las Vegas a gennaio, AMD aveva mostrato per la prima volta la propria APU Instinct MI300A dedicata ai datacenter. Si tratta di una soluzione che integra una componente CPU con 24 core Zen 4 e una GPU con architettura CDNA 3, il tutto abbinato a 128 GB di memoria HBM3. Per ottenere questo prodotto AMD ha ovviamente adottato un approccio a chiplet, abbinando componenti costruiti con tecnologie produttive a 5 e 6 nm: le soluzioni MI300A sono attualmente in consegna ai partner, che le implementeranno nei propri sistemi.

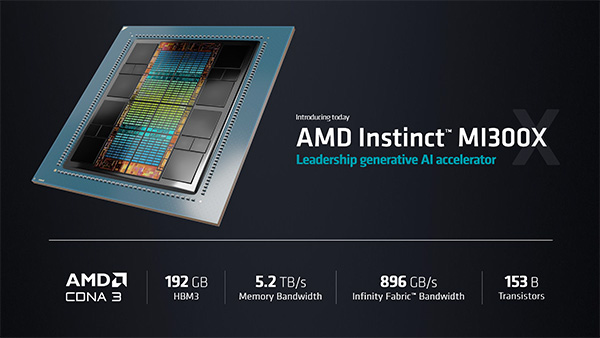

Quest'oggi AMD, nell'ottica di fornire strumenti di elaborazione ancora più performanti per i calcoli legati all'intelligenza artificiale, ha presentato Instinct MI300X: si tratta di una GPU sempre basata su architettura CDNA 3, abbinata a ben 192 GB di memoria HBM3 per una bandwidth della memoria che tocca il valore di 5,2 TB/s.In Instinct MI300X AMD ha rimosso i 3 CCD presenti in Instinct MI300A, sostituendoli con due unità GPU addizionali: il loro totale è quindi pari a 8, contro le 6 presenti in Instinct MI300A per un aumento delle prestazioni lato GPU che possiamo quantificare nel 33% in MI300X rispetto a MI300A. I chip sfruttano una bandwidth dell'Infinity Fabric di ben 896 GB/s: in tutto sono presenti circa 153 miliardi di transistor, costruiti con tecnologie produttive sempre a 6 e 5 nm.

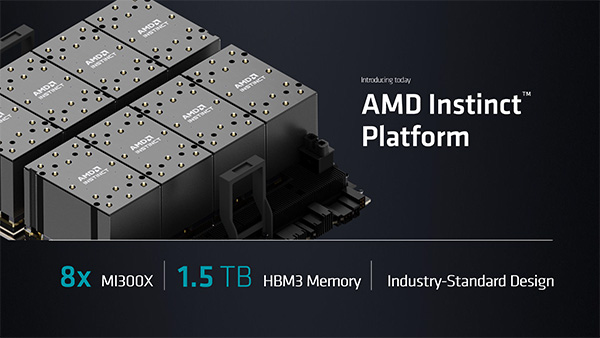

Ben 8 GPU Instinct MI300X verranno implementate all'interno di quella che AMD chiama la sua Instinct Platform, una soluzione di calcolo specifica per l'Intelligenza Artificiale che abbina 1,5 TB di memoria HBM3 a un design che è basato sugli standard delle soluzioni adottate nei server con GPU. In questo modo AMD standardizza un proprio approccio al calcolo dell'IA più complesso, con un modello che replica quanto proposto da NVIDIA con le proprie proposte e che vuole proprio rappresentare un'alternativa a quanto offerto dall'azienda di Santa Clara.

Con questi annunci AMD rilancia la propria presenza nel mondo dei datacenter, segmentando ancora di più la propria offerta. È evidente come il tutto non si fermi più alle sole CPU EPYC, che da quest'oggi sono disponibili in due ulteriori versioni rispetto a quelle Genoa già in commercio, ma si espanda a tutta la struttura dei datacenter.

In questo è evidente l'influenza di Xilinx, acquisita poco più di 12 mesi fa, oltre al ruolo della componente GPU con le nuove architetture Instinct MI300A e MI300X. Anche alla luce dei recenti annunci di Intel e NVIDIA è evidente come il mondo dei datacenter sia in fermento, con annunci di novità tecnologiche sempre più interessanti che sono per la maggior parte dei casi influenzate dal ruolo delle elaborazioni di intelligenza artificiale.

Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator

Sony Alpha 7 V, anteprima e novità della nuova 30fps, che tende la mano anche ai creator realme GT 8 Pro Dream Edition: prestazioni da flagship e anima racing da F1

realme GT 8 Pro Dream Edition: prestazioni da flagship e anima racing da F1 OVHcloud Summit 2025: le novità del cloud europeo tra sovranità, IA e quantum

OVHcloud Summit 2025: le novità del cloud europeo tra sovranità, IA e quantum Robot da 19.000 Pa al prezzo del Black Friday: Mova Z50 Ultra resta a 609€ su Amazon

Robot da 19.000 Pa al prezzo del Black Friday: Mova Z50 Ultra resta a 609€ su Amazon Gaming ultra-fluido a 200 Hz a 80€: questo monitor è l'affare del momento

Gaming ultra-fluido a 200 Hz a 80€: questo monitor è l'affare del momento Prime Video sotto accusa: doppiaggi anime generati dall'IA risultano 'robotici', fan in rivolta

Prime Video sotto accusa: doppiaggi anime generati dall'IA risultano 'robotici', fan in rivolta

7 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoPerche' in un evento che si chiama "Data Center & AI Technology Premiere" ci si aspetta la risposta al DLSS3... Ossignur....

Era ironico

Le arch hpc sono propedeutiche alle arch consumer, tutto qui

si ma darà , giustamente eh per se stessa, sempre piu priorità in termini di risorse allocate al settore server e elaborazioni

si capisce dall'indifferenza con cui affronta la quota gpu consumer paurosamente bassa

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".