AMD Advancing AI 2025: le nuove GPU per l'intelligenza artificiale

di Paolo Corsini pubblicato il 12 Giugno 2025 nel canale Device

La domanda di nuove soluzioni hardware per gestire le elaborazioni legate all'intelligenza artificiale sta diventando sempre più pressante: AMD annuncia nuove GPU della famiglia Instinct MI350, mostrando anche quelle che saranno le innovazioni previste nel 2026 per quanto riguarda GPU, CPU e networking nei datacenter. A collegare il tutto ROCm 7, anello di congiunzione tra le componenti hardware e il lavoro degli sviluppatori

AI sempre più al centro del mondo ICT

Era il mese di ottobre 2024 quello nel quale AMD, durante il proprio evento Advancing AI 2024, aveva delineato la direzione del proprio sviluppo futuro nel settore dell'Intelligenza Artificiale. In quell'occasione si era partiti con la principale novità data dai processori EPYC di quinta generazione, noti con il nome in codice di Turin e basati su architettura Zen 5. Ma per AMD il mondo dell'IA non si limita alle sole CPU, comprendendo un ecosistema molto ricco che spazia dalle GPU alle piattaforme software proposte agli sviluppatori, sino alle infrastrutture di rete.

Se 8 mesi fa il centro degli annunci di AMD è stato rappresentato dai processori EPYC di quinta generazione, sono le nuove GPU Instinct a a farla da padrona in Advancing AI 2025, l'evento che si sta svolgendo in queste ore nella cornice del Convention Center di San Jose. Siamo del resto nel cuore della Silicon Valley, a pochi chilometri di distanza dalle sedi di tutte le aziende del settore impegnate da alcuni anni a questa parte ad accelerare la diffusione dell'IA in ogni ambito di utilizzo tanto aziendale come del singolo utente.

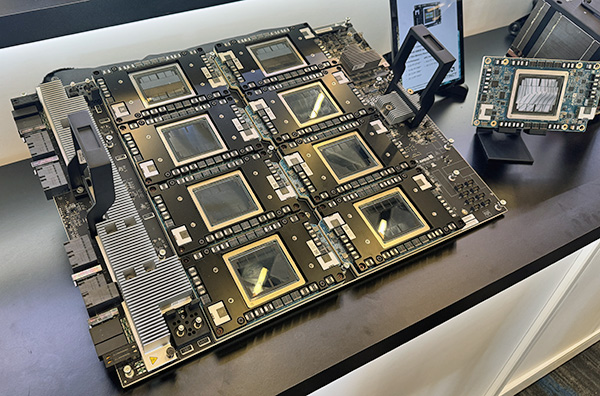

Dopo aver anticipato alcune delle caratteristiche architetturali in occasione dell'evento 2024, AMD quest'oggi lancia sul mercato la nuova serie di schede Instinct MI350 composta da due differenti modelli: Instinct MI355X e Instinct MI350X. Si tratta di acceleratori pensati per la nuova generazione di applicazioni AI, in grado di offrire un salto generazionale in termini di prestazioni ed efficienza energetica complessiva grazie sia ad uan nuova architrttura CDNA 4 sia al supporto a nuovi datatype.

Perché così tanto interesse verso le elaborazioni di intelligenza artificiale? La risposta è molto semplice: si tratta del mercato con la più rapida crescita prevista per i prossimi anni, in grado di arrivare ad un controvalore di 500 miliardi di dollari nel 2028 con un tasso annuo medio di crescita superiore al 60%. Tra training e inferencing, i due filoni che caratterizzano il mondo dell'IA, è il secondo quello per il quale si prevede lo sviluppo più sostenuto nel corso dei prossimi anni con un tasso annuo medio di crescita previsto oltre l'80%.

Le nuove GPU della gamma Instinct MI350

Come detto, sono due le nuove GPU che AMD introduce sul mercato quest'oggi: le GPU Instinct MI350X e Instinct MI355X condividono la stessa struttura di base, con differenze legate al tipo di sistema di raffreddamento che viene abbinato a ciascuna e di conseguenza anche al livello di prestazioni di picco e mantenute nel tempo di cui sono capaci.

Per Instinct MI350X l'abbinamento è con sistemi di raffreddamento ad aria di tipo tradizionale, con un massimo di 8 GPU che sono integrate in uno chassis rack da 4 unità per un totale di 8 sistemi che possono essere installati in un armadio rack. Passando a Instinct MI355X l'abbinamento è con sistemi di raffreddamento a liquido: in questo caso è possibile inserire sempre un massimo di 8 GPU in uno chassis rack da 2 unità di spessore, con un numero massimo di 16 sistemi che possono essere implementati in un armadio rack e di conseguenza un numero doppio di GPU per armadio.

Cambia anche la potenza massima di ogni scheda, con un TBP (total board power) che passa dai 1.000 Watt di Instinct MI350X ai 1.400 Watt di Instinct MI355X. Secondo quanto indicato da AMD le due proposte hanno una differenza, in termini di potenza di elaborazione, di circa il 20% tra di loro per via della superiore frequenza di clock della scheda Instinct MI355X oltre che della capacità di questa ultima di meglio sostenere frequenze di clock elevate grazie al raffreddamento a liquido al quale sono abbinate.

Le nuove schede sono basate su architettura CDNA4, costruite con tecnologia produttiva a 3 nanometri e dotate al proprio interno di ben 185 miliardi di transistor. Queste GPU sono abbinate a memoria HBM3E, in quantitativo di 288Gbytes e capaci di offrire una bandwidth massima di 8TB/s, con alcune differenze tra le due schede quanto a dati di picco nelle differenti tipologie di elaborazione di AI quantificabili in meno del 10%. Le differenti tipologie di sistemi di raffreddamento adottati per le due GPU fanno in modo che, in scenari di utilizzo pratici, Instinct MI355X sia più veloce in media di almeno il 20% rispetto a Instinct MI350X stando a quanto indicato da AMD.

Da segnalare come la nuova architettura abbia permesso di implementare il supporto ai datatype FP4 e FP6, sempre più spesso utilizzati nelle elaborazioni di IA. Il loro supporto è una delle principali innovazioni implementate nelle scheda CDNA 4 e che permette di ottenere un netto balzo in avanti in termini di prestazioni nelle elaborazioni di IA.

Nel corso degli ultimi mesi le modalità di utilizzo dei modelli IA si sono spostate verso una precisione inferiore, cercando in questo modo di ottenere un risultato bilanciato che privilegi la velocità di elaborazione. E' proprio con la disponibilità di architetture hardware che in modo nativo supportano queste nuove modalità come FP4 e FP6, tanto da parte di AMD come di NVIDIA, che il mercato si è rapidamente spostato verso questa tipologia di utilizzo dei modelli IA che privilegia velocità e volume complessivo scendendo a compromessi accettabili quanto a precisione.

AMD ha fornito alcune informazioni sulle capacità prestazionali di queste nuove schede, a confronto con le proposte di precedente generazione Instinct MI300X: si passa da un 3x medio nelle elaborazioni legate all'inferencing servendosi dei principali modelli AI a disposizione al momento attuale.

Le prestazioni sono altrettanto valide quando vengono confrontate a quelle ottenibili con le soluzioni concorrenti NVIDIA B200 e NVIDIA GB200 sempre in ambito inferencing, con un margine che può toccare il 30% stando ai dati forniti dall'azienda.

I risultati rimangono molto validi anche passando al training dei modelli di IA: nel confronto con le schede Instinct MI300X di precedente generazione si ha un 3x nelle prestazioni quale media tra i differenti scenari d'utilizzo, mentre i dati registrati sono di fatto allineati a quelli delle due soluzioni concorrenti di NVIDIA B200 e GB200. Segnaliamo come AMD abbia preso quale riferimento la scheda Instinct MI355X, la più potente tra le due annunciate quest'oggi e che per le sue caratteristiche è mediamente del 20% più veloce rispetto a quella Instinct MI350X raffreddata ad aria.

ROCm 7, il software stack per l'IA di AMD

Si tende a pensare che sia la disponibilità di nuove archtietture hardware a permettere di ottenere importanti balzi in avanti in termini di prestazioni velocistiche, ma il ruolo della componente software è ancora più rilevante. Questo elemento non solo è fondamentale per sfruttare al meglio le potenzialità delle nuove generazioni di soluzioni hardware, ma anche per permettere agli sviluppatori di lavorare al meglio sulle proprie applicazioni.

Con la nuova versione 7 di ROCm AMD non solo introduce supporto ufficiale alle nuove schede della famiglia Instinct MI350 ma permette di ottenere significativi balzi in avanti in termini di prestazioni rispetto a quanto accessibile con ROCm 6, a parità di hardware. AMD ha dichiarato incrementi nell'ordine di 3 volte tanto con l'inferencing come nel training dei modelli AI.

AMD ha inoltre annunciato ROCm for Enterprise AI, una specifica versione del proprio stack software che è specificamente pensato per venire incontro alle esigenze delle aziende che operano cluster di sistemi dedicati alla AI. Un'altra iniziativa che AMD sta portando avanti è legata al supporto diretto agli sviluppatori, attraverso una serie di eventi specifici nella forma di workshops, hackatons, meet-ups e community. Quest'oggi AMD ha annunciato l'accessibilità di un proprio Developer Cloud, al quale gli sviluppatori avranno accesso sfruttando crediti appositamente rilasciati così da utilizzare hardware AMD dedicato per le proprie elaborazioni di intelligenza artificiale.

AMD ha inoltre annunciato l'espansione di ROCm anche a livello client, con una versione di ROCm che dalla seconda metà del 2025 sarà accessibile non solo con installazioni Linux ma anche in ambiente Windows. Questo permetterà agli sviluppatori di creare le prorpie applicazioni non solo in ambiente cloud ma anche in locale sul proprio sistema basato au architetture AMD, tanto in ambiente notebook, desktop o workstation.

L'importanza delle soluzioni di networking

Le elaborazioni di intelligenza artificiale non chiamano solo in causa le GPU e le CPU integrate nei rack, ma necessitano di soluzioni di connettività che permettano di scalare le elaborazioni all'interno dei cluster. Da questo nasce la soluzione AMD Pensando Pollara 400 AI NIC, che come il nome lascia facilmente intendere è stata sviluppata da AMD proprio con l'intento di tenere il passo delle elaborazioni di IA.

Questa è la prima soluzione certificata Ultra Ethernet sviluppata da AMD, basata sulle specifiche UEC 1.0 che sono state ratificate nella giornata di ieri. Stando ai dati forniti da AMD questa scheda è in grado di ottenere un Throughput superiore tra il 10% e il 20% rispetto alle soluzioni concorrenti NVIDIA CX7 e Broadcom Thor2.

Per AMD l'approccio offerto dall'Ultra Accelerator Link è la strada che permette di sviluppare infrastrutture di networking complesse che sono richieste per sviluppare cluster di elaborazione con Intelligenza Artificiale, aprendo spazio alla collaborazione su strutture differenti senza limitare il supporto a specifici modelli o marchi.

Ma già si guarda alla prossima generazione di infrastruttura di rete con la soluzione AMD Pensando Vulcano, con la quale raddoppierà il throughput della rete dagli attuali 400G ai previsti 800G. In generale è il lavoro dell'Ultra Ethernet Consortium che viene messo al centro degli sviluppi delle soluzioni di networking, per le quali viene privilegiato un approccio open e l'utilizzo di standard consolidati come quello Ethernet.

Uno sguardo al futuro di AMD

AMD ha inoltre voluto fornire uno sguardo allo sviluppo futuro, anticipando come nel 2026 metterà a disposizione nuove piattaforme di elaborazione basate sui processori EPYC della serie Venice di sesta generazione, abbinati alle GPU della serie Instinct MI400 e alle NIC Pensando "Vulcano".

Queste ultime saranno costruite con tecnologia produttiva a 3 nanometri, offrendo una bandwidth di scale out superiore di 8 volte per ogni GPU rispetto a quanto accessibile al momento con un throughput del network che toccherà gli 800G.

Per le soluzioni EPYC Venice di sesta generazione AMD offrirà versioni sino a 256 core, con un raddoppio della bandwidth verso le GPU grazie all'utilizzo dello standard PCI Express 6, un raddoppio della bandwidth della memoria di sistema sino a 1,6 TB/s e un incremento delle prestazioni sino al 70% rispetto alle soluzioni EPYC di quinta generazione.

Per il 2026 AMD prevede anche il debutto delle schede Instinct MI400, soluzioni di prossima generazione per le quali è stato anticipato un quantitativo di memoria HBM4 di ben 432 Gbytes, con una bandwidth di poco inferiore a 20 TB/s e una potenza di elaborazione di 40 PF con elaborazioni FP4 e 20 PF con quelle FP8. Di fatto questi dati fanno prevedere un raddoppio delle prestazioni massime teoriche con le soluzini Instinct MI400 rispetto a quanto ottenibile ora con quelle Instinct MI350.

Tutte queste novità dal punto di vista hardware rientrano all'interno del concetto di Helios, nome che contraddistingue il nuovo approccio alla costruzione di architetture Rack che AMD vuole implementare nel 2026. Al centro le connessioni Ultra Ethernet e l'utilizzo di Ultra Accelerator Link, un collegamento che permetta di mettere in comincazione tra di loro sino a 1.024 GPU a prescindere da quale ne sia il produttore oltre a qualsiasi tipologia di processore. Il tutto mantenendo quell'approccio open source che ha sempre caratterizzato l'attività di AMD nel mondo dei datacenter e delle elaborazioni ad alta potenza.

Il debutto, nel 2026, della nuova struttura di rack per elaborazioni di intelligenza artificiale Helios è parte di una roadmap che vedrà dopo 12 mesi il debutto di una nuova generazione di rack: nel 2027 questa soluzione adotterà CPU EPYC della serie Verano, con GPU Instinct MI500 e infrastruttura di rete AMD Pensando Vulcano. Le dimensioni di queste nuove generazioni di rack, stando alle immagini fornite da AMD, sono differenti da quelle standard che hanno caratterizzato i datacenter per tutti questi anni: maggiore sviluppo in larghezza per tenere conto sia della superiore potenza di elaborazione complessiva da gestire sia dell'ingombro dei sistemi di raffreddamento.

Al termine del keynote con il quale Lisa Su, carismatico CEO di AMD, ha annunciato le molte novità che vedremo impiegate nei datacenter nel corso dei prossimi mesi appare ancora più evidente come l'AI stia sempre più diventando la forza propulsiva nel mondo dell'ICT. L'impatto dell'intelligenza artificiale diventerà sempre più forte con il passare degli anni, tanto in ambito enterprise come nell'utilizzo quotidiano di ogni consumatore.

Per AMD questo implica uno sforzo che vada nello sviluppo di soluzioni hardware sempre più complesse ma al contempo anche tenendo ben fermo l'approccio open source e volto alla collaborazione con le altre aziende del settore, più volte rimarcato tanto nel keynote come nei briefing che l'hanno preceduto. In un settore così complesso e variegato come quello dell'Intelligenza Artificiale è del resto fondamentale lavorare in modo collaborativo con tutte le aziende presenti ed è questo lo spirito rimarcato, all'Advancing AI 2025, da AMD.

Advancing AI 2024: le novità di AMD per i datacenter, tra CPU e GPU

Advancing AI 2024: le novità di AMD per i datacenter, tra CPU e GPU Intervista a Stop Killing Games: distruggere videogiochi è come bruciare la musica di Mozart

Intervista a Stop Killing Games: distruggere videogiochi è come bruciare la musica di Mozart Samsung Galaxy S25 Edge: il top di gamma ultrasottile e leggerissimo. La recensione

Samsung Galaxy S25 Edge: il top di gamma ultrasottile e leggerissimo. La recensione  HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto

HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto Tesla sta per lanciare il Robotaxi nella Bay Area, ma ancora una volta è FSD con supervisore a bordo

Tesla sta per lanciare il Robotaxi nella Bay Area, ma ancora una volta è FSD con supervisore a bordo Dead Island 2 arriva su Mac, ma a un prezzo triplo rispetto a Steam e senza cross-play

Dead Island 2 arriva su Mac, ma a un prezzo triplo rispetto a Steam e senza cross-play FIA e Formula E rinnovano il matrimonio: campionato elettrico fino al 2048

FIA e Formula E rinnovano il matrimonio: campionato elettrico fino al 2048

1 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoLa verita' e' che CUDA dovrebbe essere aperti a tutti i produttori di CPU. Frega niente se e' di NVidia, in questo modo tengono una posizione troppo dominante non tanto sull'hardware quando sullo sviluppo.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".