HPE GreenLake for File Storage si aggiorna per supportare i carichi di lavoro per l'intelligenza artificiale

di Alberto Falchi pubblicata il 18 Marzo 2024, alle 15:21 nel canale Cloud

Rispetto alla versione attualmente in commercio di HPE GreenLake for File Storage, le nuove opzioni offrono una capacità 4 volte superiore e prestazioni di sistema 2 volte superiori per unità rack

La crescente diffusione dell'IA, generativa e non, sta spingendo le imprese a rivedere le loro infrastrutture, così da renderla adatta e gestire carichi di lavoro decisamente più onerosi dal punto di vista computazionale. Per questo motivo HPE ha aggiornato le funzionalità di HPE GreenLake for File Storage, soluzione di storage as a service, introducendo nuove opzioni all-flash ad alta densità.

HPE GreenLake for File Storage si rinnova: aumentano spazio di storage e prestazioni

Le nuove funzionalità introdotto in HPE GreenLake for File Storage offrono ai clienti una capacità di archiviazione quattro volte superiore e prestazioni raddoppiate per ogni singolo rack. Secondo la multinazionale, questo consentirà di raddoppiare il throughput su scala IA di due volte e allo stesso tempo di ridurre del 50% in consumi.

Queste migliorie sono dovute al nuovo controller, che garantisce il doppio della potenza di elaborazione, oltre che alle unità di archiviazione con un JBOF 1-RU da 1,3560PB di tipo NVme.

"Con questi miglioramenti, HPE compie un altro importante passo avanti per consentire ai clienti di ottenere prestazioni di livello enterprise, semplicità e maggiore efficienza, il tutto su IA di scala e data lake", afferma David Yu, senior manager product marketing di HPE Storage. "HPE sta aiutando le organizzazioni a sfruttare al meglio la potenza dell'IA e a sbloccare più valore dai loro dati; stiamo aiutando i loro data scientist, i proprietari di applicazioni line-of-business e il personale IT ad aumentare la produttività; stiamo, inoltre, fornendo ai clienti i mezzi per raggiungere un'elevata sostenibilità".

Così HPE migiora l'efficienza dei workload di IA

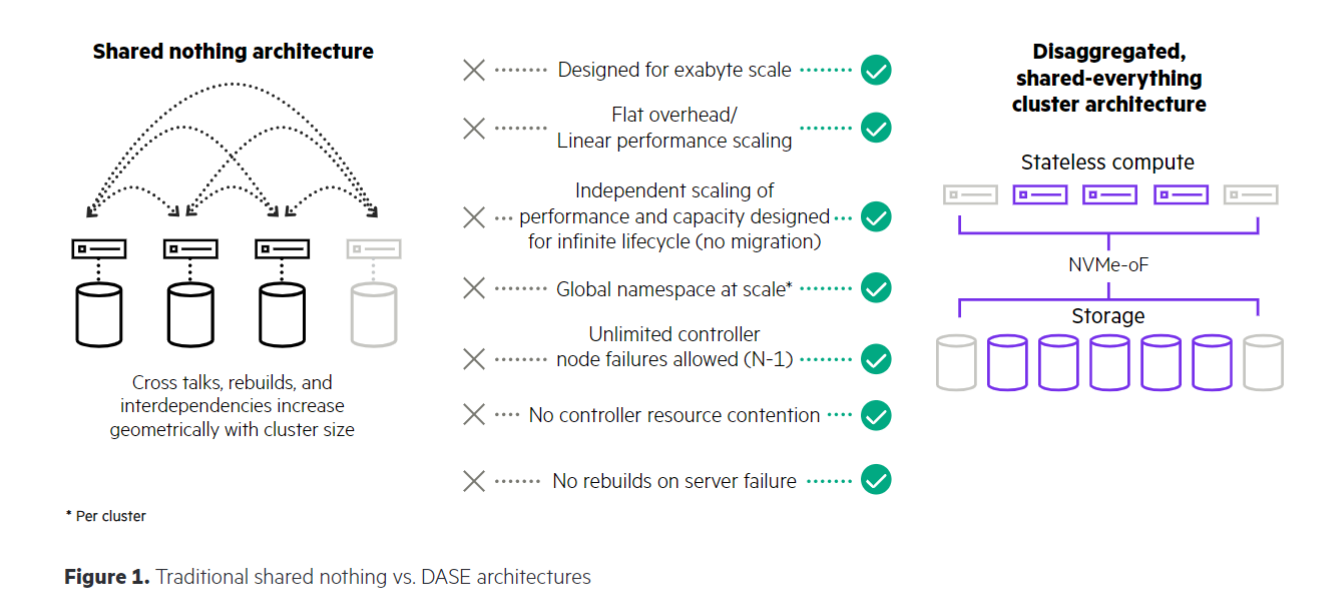

Uno dei problemi delle attuali implementazioni di intelligenza artificiale è che i sistemi di archiviazione tradizionali si basano su architetture shared-nothing, adatte ai classici carichi di lavoro, ma non in grado di scalare in modo efficiente per tenere il passo con la densità di capacità, il costo per TB e le esigenze di efficienza energetica delle elaborazioni relative all'IA.

Di qui l'idea di HPE di potenziare la sua soluzione di storage as a service con una nuova architettura hardware che, oltre ad aumentare le prestazioni, è in grado di dimezzare i consumi energetici, riducendo costi ed emissioni di CO2 in atmosfera.

HPE GreenLake for File Storage offre snapshot senza costi aggiuntivi, replica nativa e una migliore compressione dei dati grazie all'algoritmo Similarity. Quest'ultimo si differenzia dai classici sistemi che sfruttano compressione o deduplicazione in quanto riduce i dati con un approccio sia globale sia a livello di dettaglio. I risparmi sono di 2:1 per i dati delle scienze biologiche; 3:1 per i backup preridotti, i file di registro precompressi e i dati HPC e di animazione; e 8:1 per i dati delle time-series non compressi.

La soluzione di HPE supporta le tecnologie InfiniBand, NVIDIA GPUDirect e RDMA, consentendo ai clienti di avere a disposizione un massimo di 720 petabyte di spazio di archiviazione effettivo, risultando quindi adatto anche alle applicazioni di IA più complesse.

Microsoft Surface Pro 12 è il 2 in 1 più compatto e silenzioso

Microsoft Surface Pro 12 è il 2 in 1 più compatto e silenzioso Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!  Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2

Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2 Iliad offre l'upgrade gratuito ai propri utenti: fino a 200GB senza variare il costo

Iliad offre l'upgrade gratuito ai propri utenti: fino a 200GB senza variare il costo Sembra impossibile ma è scesa ancora: la scopa elettrica bestseller passa da 109€ a 104€, con tanti accessori

Sembra impossibile ma è scesa ancora: la scopa elettrica bestseller passa da 109€ a 104€, con tanti accessori Netflix: ecco tutti i titoli ''shock'' in arrivo nel 2025/26. Da Stranger Things a Narnia e molto altro

Netflix: ecco tutti i titoli ''shock'' in arrivo nel 2025/26. Da Stranger Things a Narnia e molto altro

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".