IPU, Infrastructure Processing Unit, la nuova 'scommessa' di Intel

di Manolo De Agostini pubblicata il 15 Giugno 2021, alle 17:01 nel canale Device

Al Six Five Summit, Intel ha presentato la propria visione per una infrastructure processing unit (IPU, unità di elaborazione infrastrutturale), ovvero un dispositivo di rete programmabile pensato per consentire ai fornitori di servizi cloud e di comunicazione di accelerare le operazioni di rete sgravando la CPU da tali compiti.

Si chiama IPU, ossia infrastructure processing unit, la nuova idea di Intel per dare forma a un dispositivo di rete programmabile pensato per consentire ai fornitori di servizi cloud e di comunicazione di ridurre il carico sulla CPU e velocizzare le operazioni di rete.

Fondamentalmente, si tratta della versione Intel di una DPU, anche se è una IPU sembra essere più specializzata. In ogni caso, anche qui troviamo la fusione di potenza di calcolo e tecnologia di rete, per una soluzione che rientra nel segmento delle SmartNIC.

Con una IPU, i clienti potranno usare meglio le proprie risorse e trovare un equilibrio fra elaborazione e storage. "La IPU è una nuova categoria tecnologica, ed è uno dei pilastri strategici della nostra strategia per il cloud. Prende il via dalle nostre funzionalità SmartNIC ed è progettata per fornire una soluzione alle complessità e inefficienze di un moderno data center. In Intel siamo dediti a creare soluzioni e a innovare assieme ai nostri clienti e partner, e la IPU è un esempio di questa collaborazione", ha dichiarato Guido Appenzeller, CTO del Data Platforms Group di Intel.

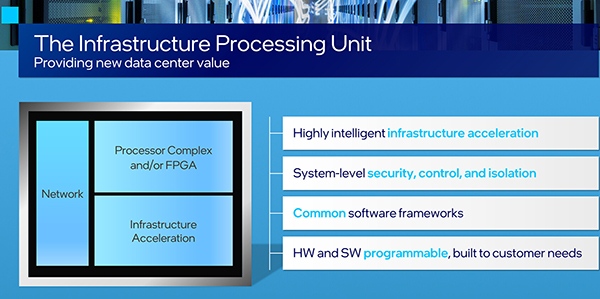

La IPU è un dispositivo di rete programmabile che gestisce in maniera intelligente le risorse infrastrutturali a livello di sistema accelerandole in maniera sicura all'interno di un datacenter. Consente agli operatori cloud di passare a un'architettura di storage e di rete interamente virtualizzata mantenendo prestazioni elevate e prevedibili, oltre a un elevato livello di controllo.

La IPU ha funzionalità dedicate per accelerare quelle applicazioni basate su un'architettura a microservizi. Secondo ricerche condotte da Google e Facebook, una percentuale variabile tra il 22% e l'80% dei cicli delle CPU viene speso inutilmente nella comunicazione tra i microservizi.

Una IPU consente di accelerare le funzioni infrastrutturali, compresa la virtualizzazione dello storage e delle reti, e la sicurezza con acceleratori di protocolli dedicati. Allo stesso tempo è possibile liberare i core delle CPU traslando le funzioni di virtualizzazione dello storage e della rete precedentemente gestite via software sulla CPU, direttamente sulla IPU.

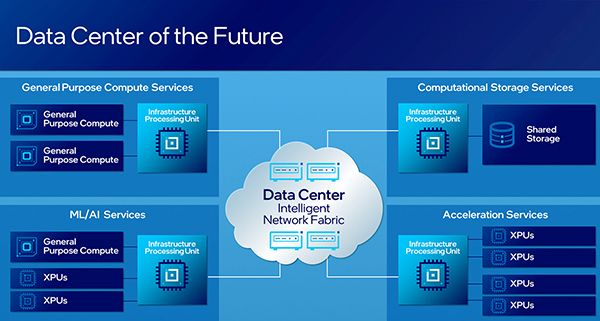

La IPU migliora anche l'uso del datacenter consentendo un'allocazione flessibile dei carichi di lavoro e consente ai fornitori di servizi cloud maggiore personalizzazione delle installazioni di funzionalità infrastrutturali.

"La collaborazione di Intel con la maggioranza degli hyperscaler ha portato l'azienda a essere già leader per volumi nel mercato delle IPU con i nostri componenti Xeon-D, FPGA e Ethernet", ha commentato Patty Kummrow, general manager dell'Ethernet Products Group di Intel. "Le prime piattaforme IPU basare su FPGA sono installate presso molteplici provider cloud e la nostra prima IPU ASIC è attualmente in fase di test".

In futuro, Intel presenterà nuove IPU basate su FPGA e ASIC dedicati. Queste soluzioni saranno accompagnate da una base software solida che consentirà ai clienti di creare software di orchestrazione cloud all'avanguardia.

Motorola edge 70: lo smartphone ultrasottile che non rinuncia a batteria e concretezza

Motorola edge 70: lo smartphone ultrasottile che non rinuncia a batteria e concretezza Display, mini PC, periferiche e networking: le novità ASUS al CES 2026

Display, mini PC, periferiche e networking: le novità ASUS al CES 2026 Le novità ASUS per il 2026 nel settore dei PC desktop

Le novità ASUS per il 2026 nel settore dei PC desktop Samsung: un trimestre da record grazie alla crisi delle memorie

Samsung: un trimestre da record grazie alla crisi delle memorie Fallout 4: crescita record dei giocatori su Steam grazie al successo della serie

Fallout 4: crescita record dei giocatori su Steam grazie al successo della serie Alphabet ha superato Apple per capitalizzazione: è tutto merito dell'AI?

Alphabet ha superato Apple per capitalizzazione: è tutto merito dell'AI?

7 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoBoh.. un chip specifico per ridurre il carico sulla CPU dei processi di rete?

E quanto mai peseranno sti processi di rete?

E soprattutto.. abbiamo CPU con 16C/32T.. è davvero necessario evitare di caricare la CPU?

Boh.. un chip specifico per ridurre il carico sulla CPU dei processi di rete?

E quanto mai peseranno sti processi di rete?

E soprattutto.. abbiamo CPU con 16C/32T.. è davvero necessario evitare di caricare la CPU?

si serve liberare carico, ti faccio un esempio se installi nsx-t su un cluster vmware solo per poter funzionare e gestire la rete ti richiede come minimo 3 server con 6 core e 24GB di ram solo per poter essere attivato, capirai che sprecare tante risorse per qualcosa che può essere fatta in maniera specializzata fatta da hardware specifico è sempre meglio anche per motivi di latenza

Se compri una cpu per dare servizio ma poi una parte rilevante viene mangiata dai servizi di base anche qui capirai che devi sovradimensionare l'hardware per sopperire al carico.

Hai presente le schede di rete con offload con IPSec e altri protocolli? il concetto è questo che senso ha far fare alla cpu una cosa che viene fatta piu velocemente e con latenza molto piu bassa da un hardware specifico?.

le cpu non vengono usate al 100% costantemente (tranne rari casi come il rendering) se lo fai vuol dire che hai tarato male l'hardware

Certo che non vengono sfruttate al 100% H24, ma i picchi li vedi al 100%

Se invece li vedi al 50% con picchi al 70/80% hai sovradimensionato la struttura.

Se il carico è fisso al 100% ampli con nuovi acquisti, ma se lo vedi al 50% fisso non è che puoi vendere.

Se invece li vedi al 50% con picchi al 70/80% hai sovradimensionato la struttura.

Se il carico è fisso al 100% ampli con nuovi acquisti, ma se lo vedi al 50% fisso non è che puoi vendere.

In un decennio non ho mai visto il mio data center raggiungere un picco del 100% avrebbe voluto dire che era tarato male. Non funziona come dici tu un sistema deve funzionare in un range più ampio di risorse libere per dare un servizio se raggiungi il 100% vuol dire che stai dando disservizio su qualche server.

Ora per esempio il mio data center usa circa il 30% delle cpu come media giornaliera. E parliamo di una struttura da migliaia di utenti e centinaia di server che devo gestire con questo hardware e relativi aumenti di bisogno per i prossimi 6 anni.

I server non si aggiungono a piacimento devi tarare il tutto in mesi di studio, non ti inventi la connettività di rete dello storiage e le licenze , backup come vuoi, aggiungere un server vuol dire rivedere tutta la struttura e tutte le licenze usate, gare da fare capitolati che vuol dire mesi e mesi di lavoro. Ora per esempio sto aggiornando lo storage e mi ha portato via 6 mesi di pianificazione e almeno 3 mesi per la messa in opera.

Ora per esempio il mio data center usa circa il 30% delle cpu come media giornaliera. E parliamo di una struttura da migliaia di utenti e centinaia di server che devo gestire con questo hardware e relativi aumenti di bisogno per i prossimi 6 anni.

I server non si aggiungono a piacimento devi tarare il tutto in mesi di studio, non ti inventi la connettività di rete dello storiage e le licenze , backup come vuoi, aggiungere un server vuol dire rivedere tutta la struttura e tutte le licenze usate, gare da fare capitolati che vuol dire mesi e mesi di lavoro. Ora per esempio sto aggiornando lo storage e mi ha portato via 6 mesi di pianificazione e almeno 3 mesi per la messa in opera.

Quando hai un picco del 100%non stai dando nessun disservizio, anzi proprio il picco ti segnala che sei entro le specifiche. Il disservizio lo puoi trovare ( e non è detto che ci sia) con carichi prolungati al 100%.

Io non vado a controllare il carico se prima non controllo le richieste esaudite, e se queste non scendono durante il picco sono ancora relativamente tranquillo.

Certo che se nel periodo di punta il sistema sta sempre al 95% con frequenti picchi al 100% e poi per 20h sta al 40% non faccio la media, ma non serve un genio a capire che il sistema è in affanno e deve essere ampliato/aggiornato.

PS, ma certo che non si mette su un datacenter come aggiungere RAM ad un PC, ma le condizioni possono variare nel tempo ed essere costretti a ampliare-migrare servizi che prima erano marginali

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".