Computer quantistici: a tu per tu con Federico Mattei, IBM Quantum Ambassador per l’Italia

di Alberto Falchi pubblicata il 24 Maggio 2023, alle 10:11 nel canale Innovazione

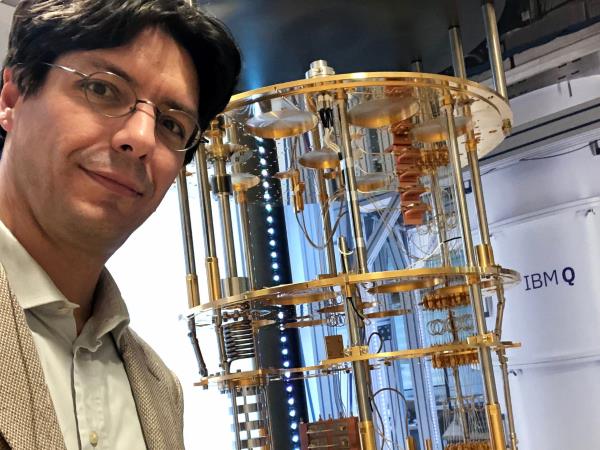

In occasione delle Olimpiadi della Fisica abbiamo avuto modo di discutere con uno degli esperti di IBM sul calcolo quantistico, Federico Mattei, che ci ha detto la sua sullo stato attuale di queste tecnologie e sugli sviluppi futuri

Alle Olimpiadi della Fisica, destinate agli studenti di fisica di tutto il mondo, non poteva mancare IBM, che è una delle aziende che più sta investendo sulla ricerca di base, con l’obiettivo di realizzare i primi computer quantistici. Secondo Federico Mattei, IBM Quantum Ambassador per l’Italia, ci troviamo di fronte a un nuovo paradigma dell’elaborazione, abilitato da tre temi chiave: il cloud, che mette immediatamente a disposizione tutta la potenza di calcolo necessaria; i neuroni o, meglio, l’intelligenza artificiale; i qubit, che permetteranno di risolvere sfide computazionali oggi impossibili grazie alle nuove modalità di elaborazione. Modalità che, ricordiamo, non sono circuiti a porte logiche, come capita con l’attuale generazione di calcolatori, ma quantistiche, cioè con risultati di tipo probabilistico.

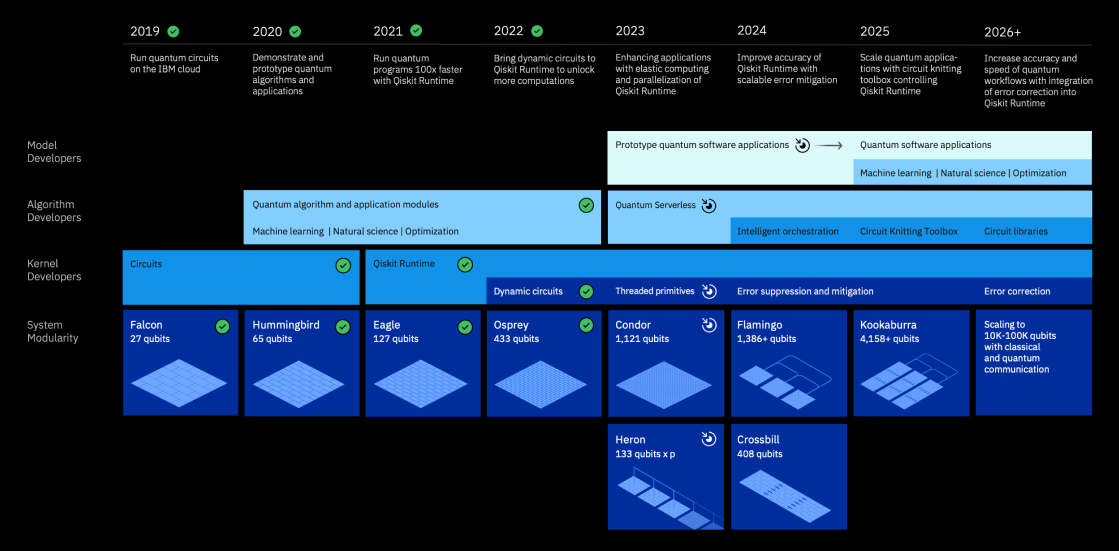

La roadmap di IBM per il quantum computing

La strada è ancora lunga, ma la roadmap prevista da IBM fa ben sperare nel vedere applicazioni reali in tempi relativamente brevi. Nel 2019 ha esordito Falcon, computer quantistico da 27 qubits, e già nel 2022 Big Blue ha presentato Osprey, architettura che vanta ben 433 qubits. Nel 2023 vedremo Condord, con 1.121 qubits e già nel 2025 dovrebbe esordire Kookaburra, con più di 4.158 qubits. Tanti, ma per vari tipologie di applicazioni ancora insufficienti: secondo Mattei, sono necessarie centinaia di migliaia di qubits e per questo IBM ha stretto una collaborazione con l’Università di Tokyo e la University of Chicago per sviluppare un supercomputer quantum-centrico da 100.000 qubit, che vedrà la luce nel 2033.

A cosa serviranno elaboratori tanto potenti? A oggi, sono tre le sfide che ancora non siamo in grado di affrontare in maniera efficace con le architetture di calcolo tradizionali. La prima è la sfida intrapresa dal CERN per scoprire i segreti dell’universo tramite il calcolo quantistico, esso infatti potrebbe accelerare enormemente l’analisi dei dati acquisiti dal LHC. Ci sono poi le analisi finanziarie, che attualmente fanno leva sulle simulazioni Montecarlo e che IBM, insieme a JP Morgan, vorrebbe accelerare tramite un algoritmo chiamato Quantum Amplitude Estimation. Ma ci sono anche scenari più facili da comprendere per chi non è esperto: IBM crede che infatti il calcolo quantistico possa aiutare a comprendere come aumentare la durata delle batterie delle vetture elettriche.

A tu per tu con Federico Mattei

Edge9: Si parla da una vita di IA, e già negli Anni ’80 erano disponibili rudimentali programmi di intelligenza artificiale come Eliza. Poi, tutto è passato un po’ sottotraccia, sino a che è esploso e in tempi rapidissimi si è arrivati alle IA generative di oggi. Cosa manca oggi al calcolo quantistico per diventare una tecnologia di larga adozione?

FM: A differenza dell'intelligenza artificiale che beneficia di un hardware, ma diciamo è principalmente algoritmica, il quantum parte direi dall’hardware stesso. Ed è stato questo il motivo per il quale dalle prime idee a quando si è realizzato il primo processore sono passati quasi quarant'anni. Il parallelo più che con l'intelligenza artificiale è con la computazione “classica”. Anche lì ci sono stati salti tecnologici che hanno consentito grandi passi in avanti. Pensiamo da quando si è passati dalle valvole ai transistor e poi ai microchip e poi una sempre maggior miniaturizzazione. Sicuramente sarà necessario fare dei salti di questo tipo. Noi oggi sulla computazione quantistica, nel panorama internazionale, vediamo almeno 5,6,7 tecnologie (a seconda di come uno le categorizza) che potrebbero aspirare ad essere le tecnologie di base per una tecnologia quantistica del futuro. Noi ne stiamo cavalcando una, per una serie di ragioni sia storiche, perché lavoriamo sui superconduttori da sempre, sia perché riteniamo sia la più promettente in questo momento. Ma non ci chiudiamo ad altro. Anzi, stiamo studiando anche per altre tecnologie perché ci aspettiamo appunto proprio questi salti che saranno quelli che ci faranno fare i passi avanti. Ci sarà però sicuramente uno spartiacque tra il presente e il futuro, esattamente come c'è stato uno spartiacque da quando la computazione quantistica si faceva sulla carta, perché i computer quantistici non c'erano. Questo spartiacque arriverà quando ci sarà il quantum advantage, cioè quanto un computer quantistico darà risultati superiori a quelli ottenibili da un computer classico.

Edge9: Ma arriverà il momento in cui il calcolo quantistico sarà superiore su tutto alla computazione tradizionale, o rimarrà confinato a specifici ambiti?

FM: Saranno ambiti sempre più ampi, ma comunque molto specifici. La statistica, la finanza, per esempio. Quindi, dire che non sarà superiore su tutto, anche se è difficile prevedere il futuro. Del resto, quanto abbiamo scoperto la teoria della meccanica quantistica non abbiamo abbandonato quella classica, che in molti ambiti funziona ancora perfettamente. La computazione quantistica non ha molto senso per il transazionale, per le web application e tematiche di questo tipo.

Edge9: Come siamo messi dal punto di vista della ricerca in Italia?

FM: Sicuramente ci sono luci e ombre, Se andiamo a vedere il numero di gruppi di ricerca, le pubblicazioni e anche il valore della ricerca che viene fatta in Italia noi siamo messi veramente molto bene. Abbiamo gruppi di ricerca lato hardware praticamente su tutti i tipi di tecnologia che studiano algoritmi in diverse direzioni, dalla chimica quantistica al machine learning, all'ottimizzazione. Questo è un grandissimo patrimonio. Ma ci sono anche i classici problemi dell’Italia: c’è molta frammentazione, manca un “contenitore” unico che riesca a valorizzare e a dare i giusti strumenti. Ma il PNRR ne porta due: il centro nazionale per la ricerca su big data e quantum computing e il partenariato esteso alle tecnologie quantistiche. Parliamo di finanziamenti importanti, nell’ordine di centinaia di milioni fra HPC, big data e quantum. Ma la Germania ha messo più di due miliardi solo sulle tecnologie quantistiche come anche la Francia.

Edge9: Si parla molto di algoritmi quantum safe. Arriverà un giorno in cui tutto quello che abbiamo oggi sarà considerato insicuro?

FM: Oggi il rischio maggiore è sulla cifratura a chiave asimmetrica. È un tema legato proprio alla componente di fattorizzazione. Se uno va a guardare gli articoli e le previsioni di quanti qubit servirebbero per rompere una crittografia asimmetrica a 2048 bit scopre che intorno al 2010 si parlava di centinaia di miliardi. Già nel 2015 si parlava di alcuni miliardi e già oggi si pensa che ne siano sufficienti alcune migliaia. Nella nostra roadmap abbiamo previsto un elaboratore quantistico da 4.000 qbit nel 2025. È quindi evidente che bisogna prestare attenzione in certi ambiti e garantire che i dati siano sicuri a lungo termine. Uno dei grossi temi è il concetto di “raccoglie oggi e decifra più avanti”: un attore malevolo può raccogliere oggi le informazioni cifrate e poi decodificarle quanto avrà a disposizione un computer quantistico. Ma non mi preoccuperei tantissimo, non creerei allarmismo su questo. Gli USA e la Cina sono già da anni al lavoro sulla certificazione degli algoritmi quantum safe.

Acer TravelMate P4 14: tanta sostanza per l'utente aziendale

Acer TravelMate P4 14: tanta sostanza per l'utente aziendale Hisense M2 Pro: dove lo metti, sta. Mini proiettore laser 4K per il cinema ovunque

Hisense M2 Pro: dove lo metti, sta. Mini proiettore laser 4K per il cinema ovunque Lenovo ThinkPad X1 2-in-1 G10 Aura Edition: il convertibile di classe

Lenovo ThinkPad X1 2-in-1 G10 Aura Edition: il convertibile di classe OnePlus Pad Lite conquista l’Italia: il nuovo tablet economico con schermo XXL già in preordine!

OnePlus Pad Lite conquista l’Italia: il nuovo tablet economico con schermo XXL già in preordine! Appuntamenti su Roblox: la controversa visione del CEO per un gioco popolato da minorenni

Appuntamenti su Roblox: la controversa visione del CEO per un gioco popolato da minorenni L’AI Meteo di Google sbarca silenziosamente su Pixel 8 e 8a. Ecco come scaricarla

L’AI Meteo di Google sbarca silenziosamente su Pixel 8 e 8a. Ecco come scaricarla

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".