AWS re:Invent 2024: il momento in cui l'IA si è fatta vera

di Riccardo Robecchi pubblicato il 30 Dicembre 2024 nel canale Cloud

Si fa un gran parlare dell'IA, che ci viene propinata in innumerevoli salse, ma è ad AWS re:Invent 2024, la conferenza annuale dell'operatore cloud, che per la prima volta abbiamo visto davvero i frutti dello sviluppo dell'IA degli ultimi anni, con molte applicazioni interessanti. Non mancano poi le basi per cui abbiamo imparato a conoscere AWS negli anni, con moltissimi nuovi servizi cloud

Definire AWS re:Invent è difficile: è un evento enorme, con oltre 60.000 partecipanti, che s'impadronisce interamente della Strip di Las Vegas per quasi una settimana. Nell'edizione del 2024 si sono succedute molteplici novità: Matt Garman, il CEO nominato all'inizio dell'anno, ha tenuto il suo primo keynote, e per molti versi c'è stato un "ritorno alle origini" con una maggiore enfasi su ciò che ha reso forte AWS negli ultimi diciotto anni, ovvero la capacità di offrire servizi semplici e ben integrati. L'IA, in particolare quella generativa, è stata senza alcun dubbio la principale protagonista della conferenza, ma per la prima volta non è stata una presenza "incorporea": si sono visti i frutti tangibili e reali degli sviluppi degli ultimi anni.

I "mattoncini" per costruire servizi e applicazioni

Un aspetto su cui AWS ha più volte posto l'enfasi è quello dei "mattoncini", o "building blocks" in inglese, che mette a disposizione dei suoi clienti. Il parallelo è con UNIX, il sistema operativo creato negli anni '70 ai Bell Labs: la sua prerogativa era quella di offrire tanti programmi, ciascuno in grado di fare una cosa sola, ma di farla molto bene, lasciando poi all'utente il compito (ma anche la possibilità) di creare funzioni più complesse mettendo insieme i programmi più semplici. Come se questi ultimi fossero, per l'appunto, semplici mattoncini usati per costruire qualcosa di più complesso.

AWS è tornata a parlare proprio di questo approccio e di come sia centrale nella sua strategia. L'azienda non ha mai smesso di usare questo approccio e di proporlo, ma negli anni precedenti c'è stato un cambiamento nel modo in cui si è presentata ai suoi clienti; per certi versi, re:Invent 2024 è un ritorno al passato.

Proprio alla complessità è stato dedicato il keynote di Werner Vogels, CTO di AWS, che ha parlato lungamente delle strategie da seguire per assicurarsi che le applicazioni e i servizi che si costruiscono siano semplici, facili da manutenere e da espandere, e in grado di spostare la complessità là dove è più facilmente gestibile. Questo perché esiste una legge in proposito, la legge di Tesler: "la complessità non può essere né creata, né distrutta, ma solo spostata altrove". Perciò Vogels ha parlato di "simplexity", crasi di "simplicity" e "complexity", per far capire proprio come semplicità e complessità siano due facce della stessa medaglia e sia impossibile eliminare completamente la complessità: si può solamente spostare, così da lasciare la semplicità lì dove serve.

In concreto, questo approccio porta AWS a muoversi su diversi livelli, a partire dall'hardware: l'azienda sta continuando a far evolvere Nitro, il chip che si occupa di gestire la virtualizzazione, la rete, la cifratura e molti altri servizi, e ha annunciato la disponibilità di Trainium2, il chip specializzato nell'addestramento dei modelli d'IA, e lo sviluppo di Trainium3, che dovrebbe avere quattro volte la potenza di Trainium2 e sarà disponibile nel tardo 2025. Contrariamente agli scorsi anni, AWS non ha annunciato una nuova generazione del suo processore con architettura ARM, Graviton.

Nitro è il chip che si occupa di gestire moltissimi degli aspetti di gestione (e non solo) dei server in AWS; l'azienda ha annunciato che vi aggiungerà ulteriori funzionalità, come la verifica hardware della cifraturae dell'integrità del segnale PCIe nei sistemi con processore Graviton 4 grazie a una catena crittografica basata sull'hardware. Il chip si occuperà anche di gestire lo storage disaggregato: anziché sfruttare storage server dedicati, AWS ha impiegato dei JBOD e vi ha inserito delle schede con processori Nitro che, di fatto, rendono possibile dare a ciascun disco la sua connessione di rete.

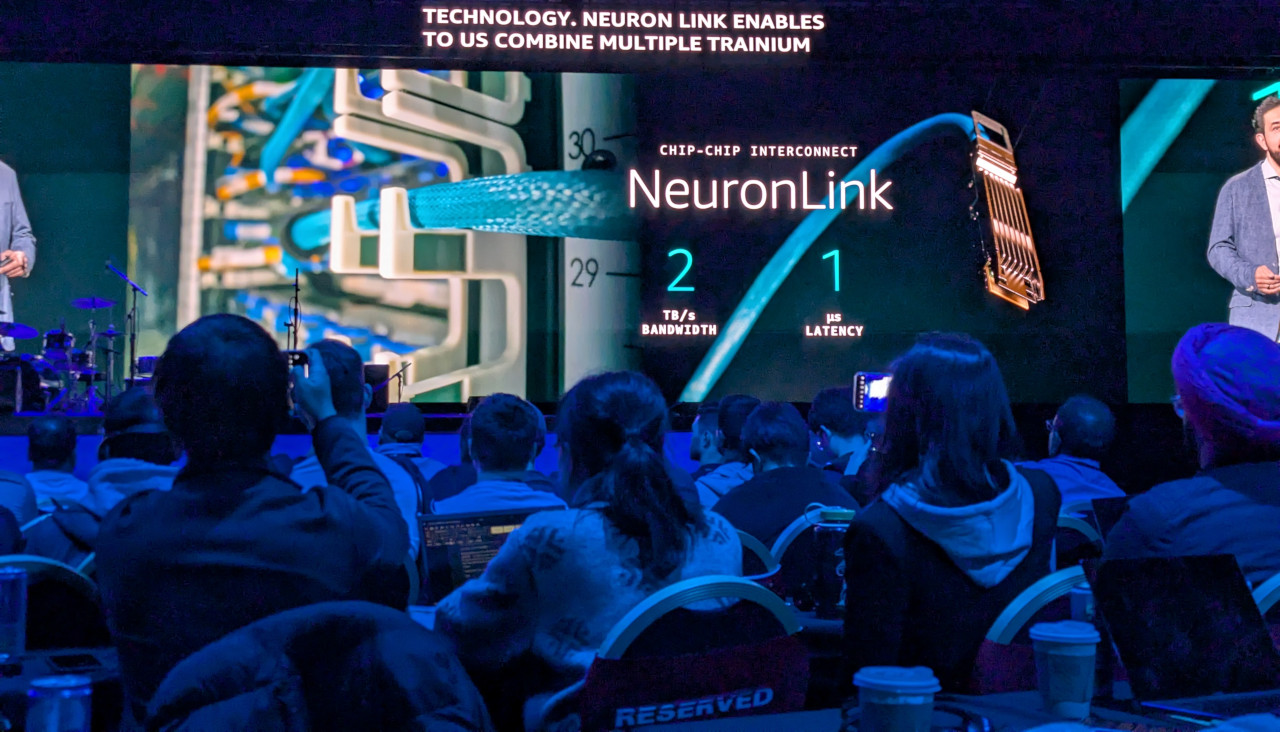

Proprio su questo punto ci sono delle novità, perché AWS ha presentato una nuova connessione che chiama "NeuronLink": è pensata per la connessione diretta tra chip e ha una banda passante di 2 TB/s (ovvero 16 terabit), con una latenza di appena 1 microsecondo. Si tratta di prestazioni eccezionali, pensate per le applicazioni più esigenti che, in questo momento storico, significa per l'intelligenza artificiale.

In effetti NeuronLink è usata all'interno di Trainium2 UltraServer: due armadi rack con 3 server blade Trn2 con 64 acceleratori Trainium2, con 1,5 TB di memoria HBM con una banda di 46 TB/s e in grado di offrire una potenza di calcolo pari a 83,2 PFLOPS. Si tratta di circa quattro volte la capacità di calcolo offerta dalle macchine Trn2, ciascuna con 16 chip Trainium2 che offrono circa 20 PFLOPS di potenza di calcolo.

Continuando con il tema dei "building blocks", l'anno scorso AWS aveva annunciato la disponibilità di un servizio di sincronizzazione degli orologi tra i vari sistemi a livello mondiale, con una precisione che arrivava al microsecondo (ovvero un milionesimo di secondo). Tale servizio, che era passato quasi in sordina, si è rivelato in realtà la base per alcune novità piuttosto rilevanti: a re:Invent 2024 AWS ha infatti presentato Aurora DSQL, un motore di database SQL distribuito compatibile con PostgreSQL, e la "coerenza stretta" per le istanze multi-regione di DynamoDB, un motore di database NoSQL. In entrambi i casi risulta fondamentale il "mattoncino" che consente di sincronizzare gli orologi: per mantenere la coerenza dei dati tra sistemi che possono essere anche agli estremi opposti del globo è infatti necessario che i riferimenti temporali siano identici o quantomeno molto simili, così da evitare sovrascritture, perdita di dati o conflitti tra letture e scritture.

Torniamo quindi alla presentazione di Vogels, che ha toccato proprio questo punto: AWS usa i suoi stessi prodotti per i propri servizi. Il tema dei "mattoncini" nasce proprio dalle esigenze interne di AWS, che si è resa conto che non aveva senso riprogettare da zero certi sistemi ogni volta che se ne aveva l'esigenza, ma che era al contrario possibile creare dei servizi "di base" su cui poi basarne altri. In questo modo era possibile nascondere la complessità dietro certi problemi, rendendo più semplice poi costruire applicazioni e servizi a loro volta complessi (ma in un campo e in un modo differenti).

Bedrock, Sagemaker e Nova: l'IA secondo Amazon

Come ci ha spiegato Sasha Rubel, Head of AI/GenAI Policy, "il nostro approccio all'IA è molto simile a quello del cloud, ovvero guardiamo a come democratizzare l'accesso a queste tecnologie e rendere facili la loro adozione e l'innovazione. Lavoriamo su tre livelli dello stack: il primo è l'infrastruttura, ad esempio con i chip come Trainium 2 e Inferentium; quello di mezzo è Bedrock, che è emblematico del nostro approccio verso ciò che riteniamo necessario per i nostri clienti per l'IA, ovvero controllo sui costi e sui modelli, nonché riservatezza; l'ultimo livello è la fornitura di applicazioni d'IA generativa come Amazon Q."

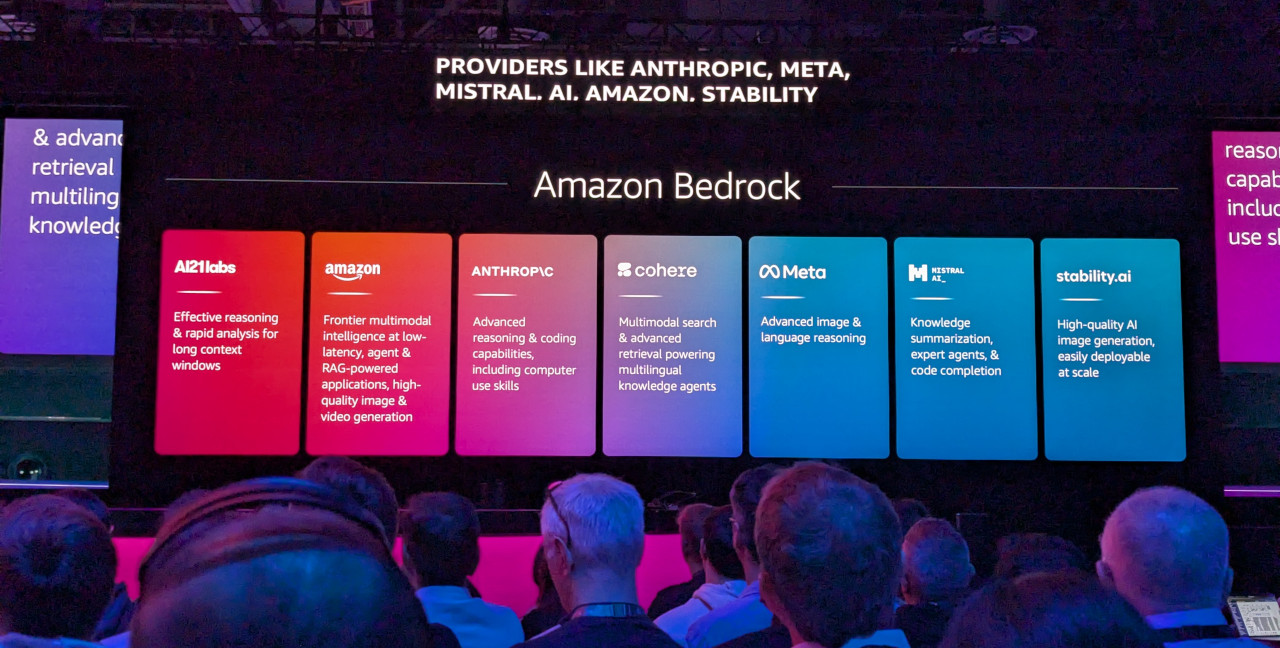

E proprio in questa direzione va l'intervento fatto nella sua presentazione dal nuovo CEO, Matt Garman, che parla esplicitamente di un "nuovo mattoncino": l'inferenza. Moltissime aziende non vogliono, non possono o non hanno bisogno di addestrare i propri modelli: hanno bisogno di un modello d'intelligenza artificiale che sia in grado di rispondere alle proprie esigenze e che possa essere facilmente integrato all'interno delle proprie applicazioni. È qui che entra in gioco Bedrock, il servizio messo a disposizione da AWS per offrire alle aziende accesso semplificato e unificato a una molteplicità di modelli.

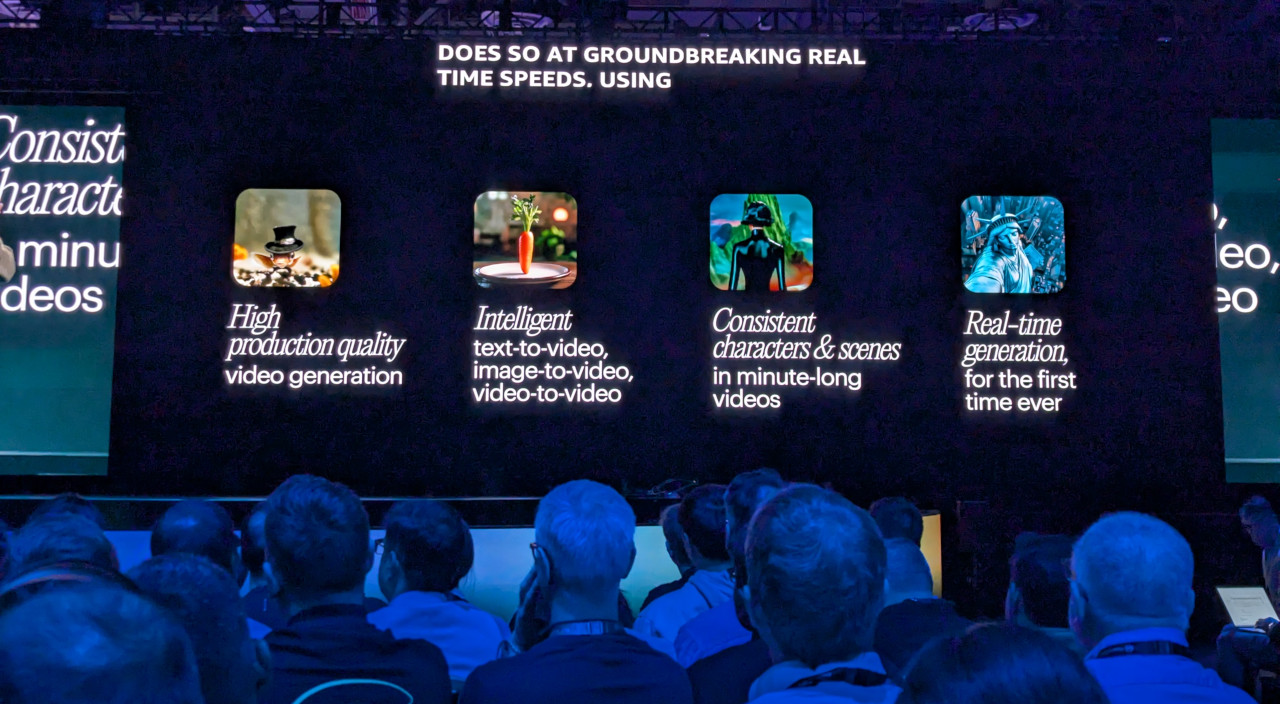

La novità più grande in questo senso sta nell'inclusione di una famiglia di modelli fondativi proprietaria di AWS, chiamata Amazon Nova. Ci sono molti modelli diversi: Micro, Lite, Pro e Premier generano testo; Canvas genera immagini; Reel genera video "di qualità professionale". I modelli testuali supportano oltre 200 lingue e sono comparabili ai concorrenti della rispettiva classe (ad esempio, Nova Pro è comparabile a GPT-4o di OpenAI); Lite, Pro e Premier sono in grado di usare immagini e video come input. Canvas genera immagini a partire da testo o immagini, mentre Reel è in grado di creare video (per il momento solo di sei secondi, più avanti fino a due minuti) a partire da un input testuale. Nel primo trimestre del 2025 arriverà anche un modello "speech to speech, ovvero in grado di comprendere il parlato e di rispondere "a voce". Per metà 2025 l'obiettivo è di offrire modelli in grado di ricevere qualunque input e di restituire qualunque output; ad esempio, produrre un video a partire da una richiesta a voce.

I modelli Nova saranno disponibili (anche) tramite Bedrock, ma non è tutto qui. Bedrock infatti ha ricevuto molte novità, tra cui spicca il "ragionamento automatizzato" ("automated reasoning"), che usa modelli matematici per verificare che quanto prodotto da un modello d'IA sia corretto, limitando così al minimo le possibilità che siano presenti informazioni non rispondenti al vero e allucinazioni. Ciò è particolarmente rilevante quando si parla di usare l'IA in settori altamente regolamentati. Un ulteriore aspetto rilevante è quello della cosiddetta "distillazione dei modelli": spesso infatti le aziende adoperano modelli di grandi dimensioni che hanno competenze e conoscenze non necessarie, col risultato che eseguire l'inferenza è spesso costoso; la distillazione consente di trasferire le conoscenze di un certo ambito da un modello più grande a uno più piccolo, mantenendo inalterate le prestazioni (e i costi) di quest'ultimo. Secondo AWS, ciò consente di contenere i costi del 75% e di migliorare le prestazioni del 500%.

Se Bedrock consente di usare modelli già pronti, SageMaker è invece il servizio di Amazon che consente di creare e addestrare nuovi modelli d'intelligenza artificiale. La novità principale presentata a re:Invent 2024 è SageMaker Unified Studio, che consente di accedere a tutti i dati aziendali da un unico punto: il nuovo strumento unifica di fatto le varie applicazioni "Studio" di Bedrock, EMR, Redshift, Glue e SageMaker Studio, e consente di trovare i dati, prepararli per l'uso da parte dei modelli d'IA, e costruire questi ultimi. In questo modo AWS semplifica notevolmente la creazione di modelli d'IA che sfruttano i dati aziendali, elemento che risolve uno dei problemi più grandi: la selezione dei dati da usare per l'addestramento.

Arriviamo dunque all'ultimo stadio, ovvero quello dei servizi costruiti da AWS usando i "mattoncini" e offerti come SaaS. Arriviamo ad Amazon Q, servizio che si divide in due: da un lato Q Business, dall'altro Q Developer. In entrambi i casi si tratta di strumenti basati sull'intelligenza artificiale generativa; il primo è uno strumento pensato per aiutare le aziende e i lavoratori a trovare le informazioni necessarie all'interno del mare magnum dei dati aziendali; il secondo è invece progettato per aiutare gli sviluppatori a scrivere codice (un po' come il più famoso GitHub Copilot) e per offrire servizi terzi.

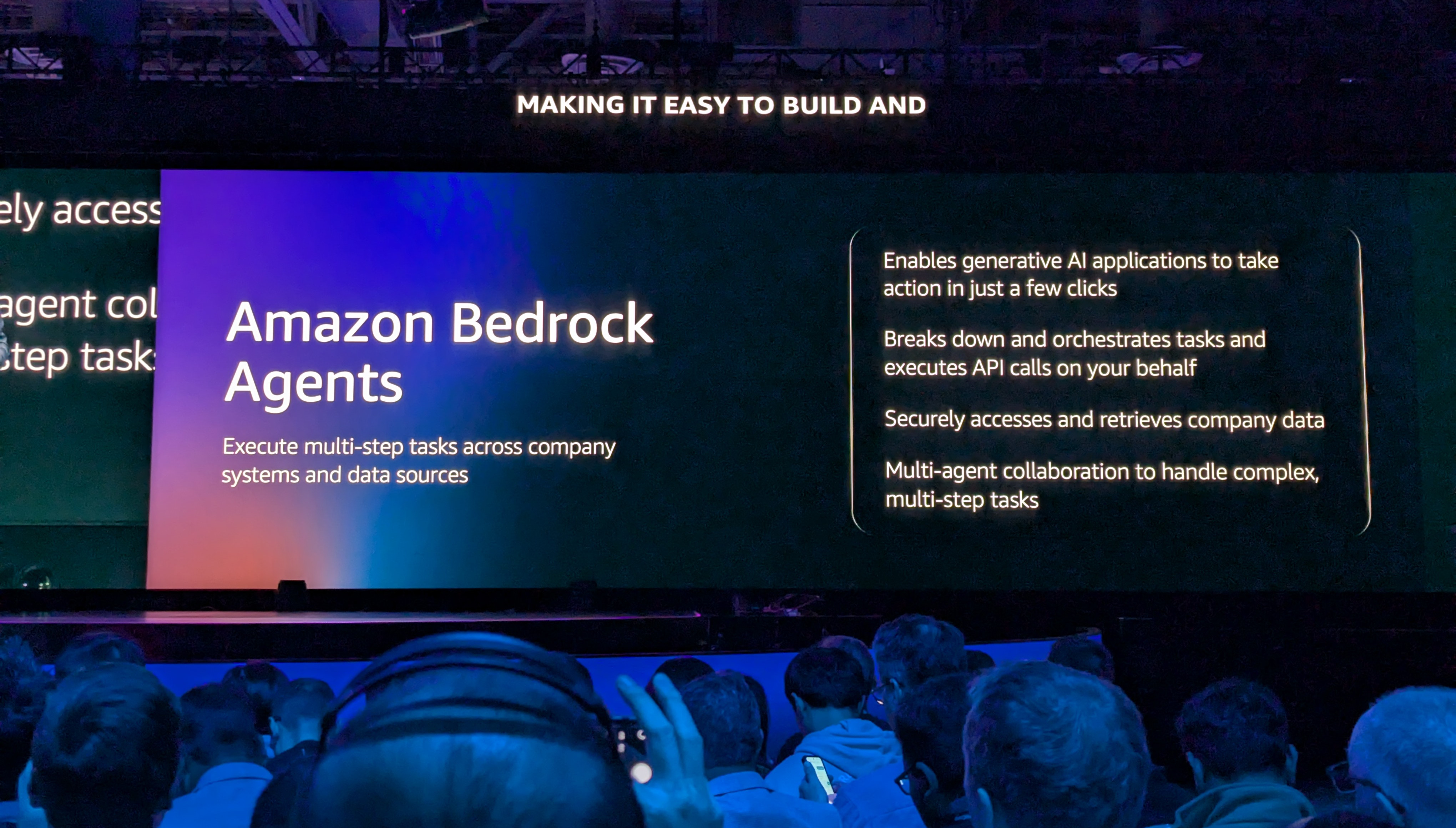

La novità principale presentata in Q Business è il fatto che è possibile creare degli agenti che non solo rispondono in automatico ad altre azioni e situazioni, ma che sono in grado di agire in maniera proattiva e di automatizzare flussi di lavoro complessi (AWS fa l'esempio di un agente che scarica il PDF di una fattura, la inserisce nell'ERP e, una volta approvata, invia una richiesta di pagamento). Q Developer, invece, ha visto un'espansione da strumento per aiutare gli sviluppatori a scrivere codice a "traduttore" in grado di effettuare automaticamente il porting da una piattaforma all'altra: ciò include il porting delle applicazioni scritte in .NET da Windows verso Linux (che, AWS afferma, consente di risparmiare fino al 40%), la conversione delle macchine virtuali da ambienti VMware ad AWS con la conversione automatica delle regole di networking; infine, la modernizzazione dei mainframe con l'analisi e la conversione del codice COBOL in Java.

AWS in Italia: un'espansione che continua

re:Invent non è stato solo un'occasione per parlare delle novità in senso generale presentate da AWS, ma anche dell'Italia. AWS ha recentemente annunciato investimenti nel nostro Paese per 1,2 miliardi di euro, per ampliare la presenza di data center intorno a Milano. Ne abbiamo parlato con Julien Groues, che ci ha detto che "con l'intelligenza artificiale generativa c'è stata un'accelerazione nella trasformazione digitale: un anno fa le società americane erano più avanti, oggi non è più così e le aziende italiane si stanno muovendo davvero velocemente, allo stesso passo di quelle americane. E se continueranno così, saranno in grado di generare ulteriori 60 miliardi di dollari di valore per l'economia italiana entro il 2030."

Groues spiega che Milano è stata scelta per l'espansione dei data center attuali perché in questo modo saranno presenti più "availability zones": sarà, in altre parole, possibile distribuire le proprie attività su AWS in diversi data center posti a una certa distanza l'uno dall'altro, così da diminuire il rischio che eventuali problemi a uno di essi portino a un'interruzione dei servizi, senza però introdurre i problemi tipici legati alla distanza, come la latenza. Questo perché i data center sono posizionati proprio tenendo conto di questo fattore, così che l'impressione sia quella di operare in un solo data center.

Groues punta inoltre i riflettori sul fatto che in Italia sono presenti molteplici startup che si occupano di intelligenza artificiale e, in particolare, d'IA generativa, e che sono distribuite in tutto il territorio.

A re:Invent 2024 abbiamo incontrato anche Simone Merlini di beSharp, azienda italiana che è stata tra le prime a scommettere su AWS in Italia ed è oggi tra le principali realtà che offrono consulenza alle aziende per l'uso del cloud id Amazon. Merlini ha raccontato come negli anni sia aumentato progressivamente (e significativamente) il livello delle competenze legate al cloud e che oggi servono competenze verticali molto approfondite per rispondere alle esigenze dei clienti. beSharp sta aggiungendo alla sua offerta i servizi gestiti, con i quali aiuta i propri clienti a gestire (anche) i servizi che ha sviluppato; tipicamente i clienti sono nel settore finanziario e manifatturiero e sono di dimensioni medio-grandi. "Per nostra scelta manteniamo poi una percentuale piccola, ma significativa, di startup tecnologiche, perché sono i clienti più sfidanti in assoluto: sono clienti che spostano sempre più in alto l'asticella e sono utili a noi per non perdere mai il polso sull'innovazione."

Merlini ci dice come ChatGPT sia stato un'arma a doppio taglio per le aziende: "da un lato ha creato sicuramente tanto entusiasmo, più che comprensibile, ma dall'altro ha creato anche tanta incertezza e confusione. È servito a democratizzare alcuni concetti molto complessi e la comprensione di alcune tecnologie legate alle IA, facendo intravedere ciò che potrebbe essere. Dall'altro lato in tanti [vi] si sono buttati a capofitto senza avere ben chiaro poi un risultato di business. Tanti hanno fatto fatica a capire dove andare."

Dopo l'investimento da parte di AWS in nuovi data center, però, è ora che cambi qualcosa in tema di investimenti tecnologici nel nostro Paese: "manca la cultura dell'investimento tecnologico, anche ad alto livello. Si è investito in altre cose, come il bonus 110%, ma se avessimo investito quelle somme in tecnologia avremmo fatto davvero un bel passo in avanti", dice Merlini.

E proprio questo è un tasto su cui è necessario insistere: sembra come dire che non ci sono più mezze stagioni, ma la tecnologia corre sempre più velocemente. Un servizio come Bedrock consente d'integrare l'IA generativa all'interno delle proprie applicazioni in maniera molto semplice, riducendo la barriera d'ingresso in maniera estremamente significativa. E ciò avviene ad appena due anni dal lancio dei primi modelli di grandi dimensioni che hanno davvero rivoluzionato il mercato e fatto capire quale fosse la direzione che il mondo avrebbe preso.

Un cambio di passo: l'IA non è più solo una "buzzword"

La sensazione che ci portiamo a casa da AWS re:Invent 2024 è che Amazon continuerà sulla strada che ha sempre percorso, con sempre più opzioni e un'offerta sempre più ampia. Starà al mercato poi usare quei famosi "mattoncini" per costruire ciò che serve: che sia un sistema per effettuare la ricerca semantica nei video o che sia per digitalizzare la pubblica amministrazione italiana e portarla finalmente nel ventunesimo secolo.

Ma l'aspetto più importante e interessante è che a re:Invent 2024 abbiamo assistito a un cambio di passo significativo per quanto riguarda l'intelligenza artificiale, in particolare quella generativa. Ne abbiamo sentito parlare costantemente e in maniera martellante negli ultimi due anni: tutte le aziende, grandi e piccole, si sono affrettate e affaccendate ad annunciare che avrebbero inserito l'IA in qualunque cosa, financo negli spazzolini da denti; è stato difficile, tuttavia, trovare dei prodotti e servizi in cui l'IA faceva veramente la differenza e in cui non era inserita per ragioni che, francamente, appaiono puramente di facciata e ben poco di sostanza. Questa è la prima occasione in cui questa sensazione si è invece capovolta e in cui sono comparse applicazioni utili e reali.

Facciamo l'esempio di Twelve Labs: una startup che ha creato un motore di ricerca all'interno dei video, in cui è possibile chiedere cose come "Braccio di Ferro visto da un cannocchiale che mangia spinaci" o "vettura di Formula 1 della scuderia Ferrari che effettua un sorpasso in curva" e il motore restituisce una lista di risultati che corrispondono a quanto richiesto. In altri termini, una sorta di "ctrl+F" per i video. Un altro esempio è .lumen, startup rumena che ha creato un dispositivo indossabile, simile ai visori per la realtà virtuale, per aiutare le persone cieche o ipovedenti a muoversi senza la necessità di un cane-guida. Il dispositivo è dotato di una fotocamera che riprende quanto avviene intorno all'indossatore; l'intelligenza artificiale analizza quanto ripreso e dei motorini montati in corrispondenza della fronte danno indicazioni su dove è possibile muoversi. Il dispositivo, per inciso, è prodotto in Italia, vicino a Como.

Questi sono solo due esempi legati a come l'IA stia uscendo da una fase più prettamente sperimentale, in cui le aziende annunciano molto ma rendono poco disponibile, e stia entrando invece in una fase in cui si arrivano a vederne gli effetti e le applicazioni nella pratica. L'ultimo esempio, quello di .lumen, è forse il più significativo, perché il possibile impatto sulla vita delle persone è enorme. re:Invent 2024, in altri termini, è per noi davvero il momento in cui siamo entrati nell'era dell'IA. Da ora in poi vedremo sempre più cambiamenti e un sempre maggiore impatto di questa tecnologia sulle nostre vite: e speriamo che sia un impatto positivo.

HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto

HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto Microsoft Surface Pro 12 è il 2 in 1 più compatto e silenzioso

Microsoft Surface Pro 12 è il 2 in 1 più compatto e silenzioso Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!  X sotto accusa in Francia: 'Ci trattano come una banda mafiosa per censurarci'

X sotto accusa in Francia: 'Ci trattano come una banda mafiosa per censurarci' CMF Watch 3 Pro: lo smartwatch con AI che cambia il fitness. E costa meno di 100 euro!

CMF Watch 3 Pro: lo smartwatch con AI che cambia il fitness. E costa meno di 100 euro! ASUS: la potenza dei supercomputer NVIDIA Grace Blackwell Ultra in formato desktop

ASUS: la potenza dei supercomputer NVIDIA Grace Blackwell Ultra in formato desktop

1 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".