Verso il milione di qubit: IBM pubblica i suoi piani sullo sviluppo dei computer quantistici

di Riccardo Robecchi pubblicata il 12 Maggio 2022, alle 11:21 nel canale Innovazione

IBM ha annunciato i suoi piani per lo sviluppo dei computer quantistici: sotto i riflettori sono i nuovi processori che dovrebbero raggiungere oltre 4.000 qubit nel 2025, ma l'attenzione va al modo in cui tale traguardo sarà raggiunto

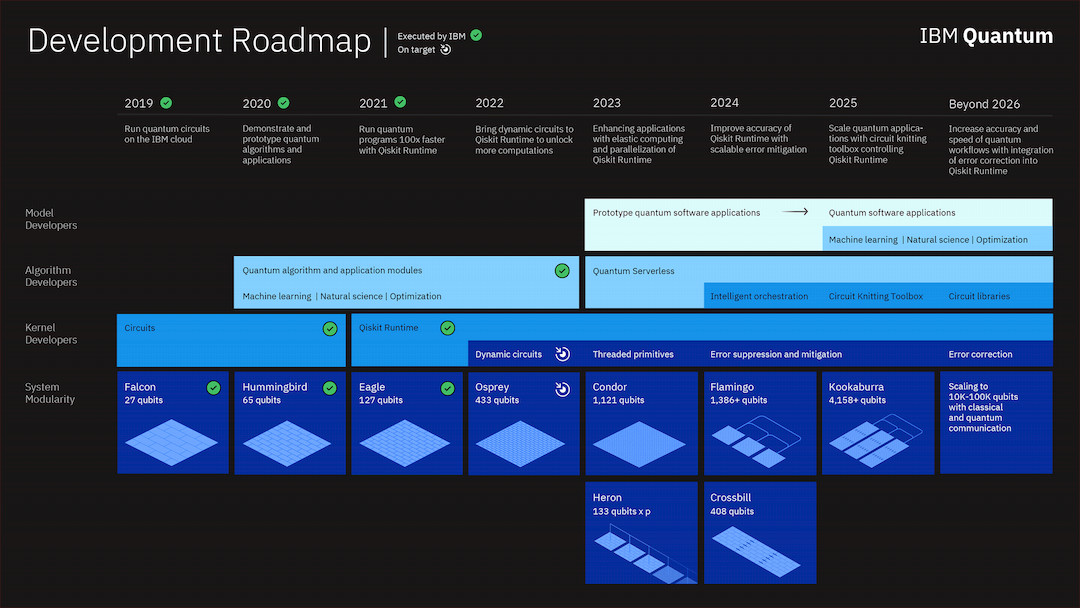

IBM ha annunciato la sua nuova tabella di marcia per lo sviluppo dei computer quantistici, andando così ad aggiornare quella che aveva annunciato nel 2020. Le novità più significative sono certamente i nuovi processori, che arrivano a oltre 4.000 qubit, ma anche il piano di sviluppo di processori interconnessi tra di loro e diverse novità relative al software. Non mancano, poi, alcuni dettagli che fanno intendere un cambio di strategia di comunicazione da parte di IBM riguardo i propri computer quantistici.

I nuovi processori quantistici di IBM: verso i 4.000 qubit nel 2025

IBM aveva già annunciato l'intenzione di lanciare il processore Osprey ("falco pescatore") da 433 qubit nel 2022 e il processore Condor da 1.121 qubit nel 2023. L'azienda ha ora espanso ulteriormente la sua tabella di marcia per includere non solo nuovi processori con più qubit, ma anche processori che sono costituiti da più chip operanti in parallelo.

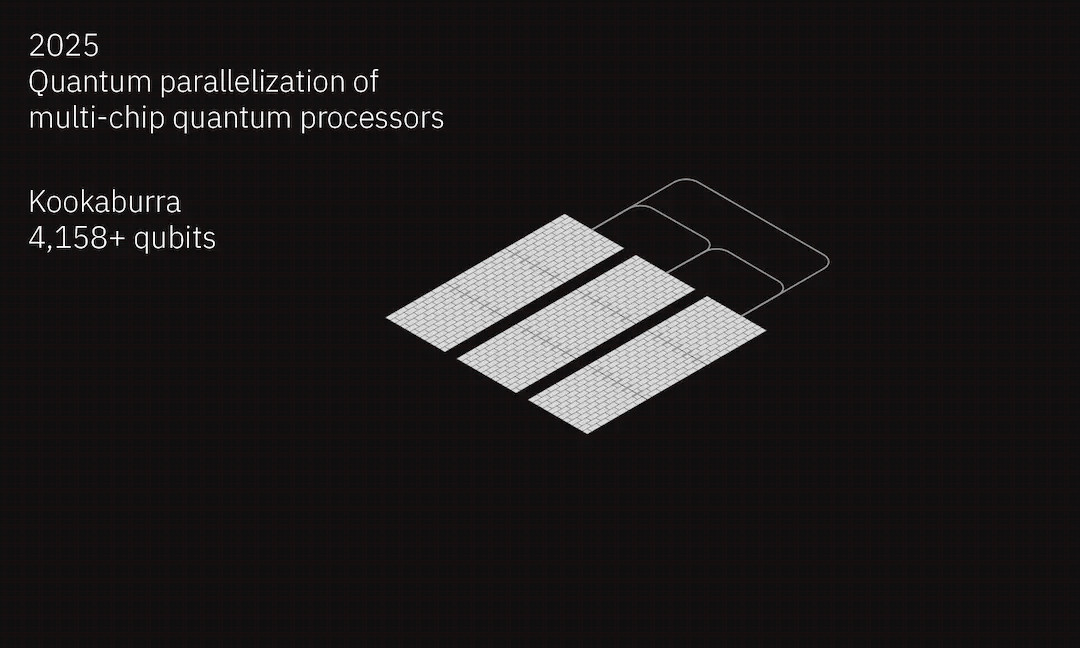

Per essere più specifici, la tabella che IBM ha pubblicato tramite un articolo sul suo blog vede tutti i processori dopo Condor composti da più chip. Flamingo (ovvero "fenicottero") sarà infatti un processore da 1.386 qubit, seguito da Kookaburra(un parente australiano del martin pescatore), da 4.158 qubit, e in entrambi i casi l'azienda intende usare più chip in parallelo per arrivare a tali numeri.

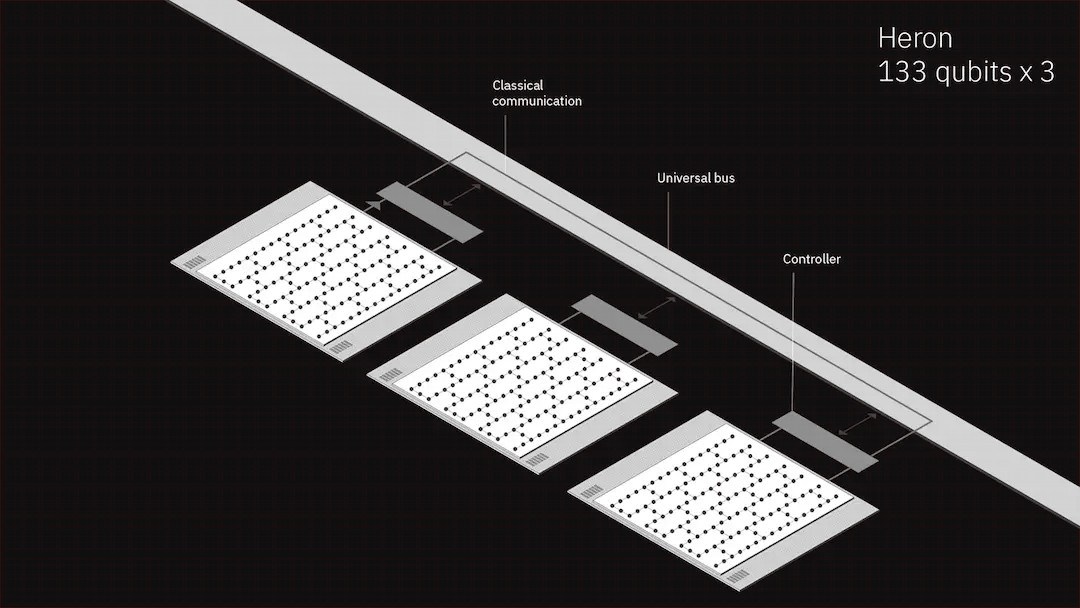

Mattone fondamentale di questo processo di parallelizzazione sarà un nuovo processore da 133 qubit, noto come "Heron" ("airone"), la cui particolarità sta nel fatto di essere progettato per comunicare con altri processori tramite reti classiche. IBM non scende nel dettaglio su cosa ciò significhi, ma è possibile ipotizzare che si tratti di una conversione dei dati tra i domini classico e quantistico, con chip di controllo interposti tra i vari processori che si occupano di tale conversione e di effettuare la comunicazione tra i vari moduli. Heron sarà composto da tre moduli da 133 qubit ciascuno, per un totale teorico di 399 qubit.

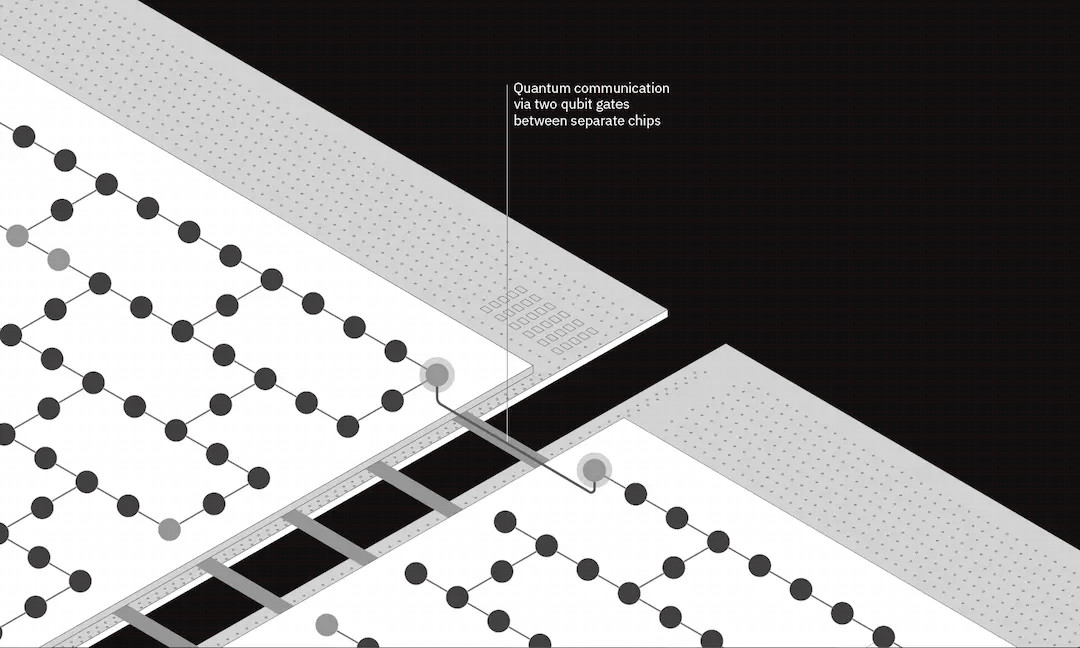

Flamingo seguirà un approccio simile, usando però connessioni quantistiche tra i chip. Anziché impiegare un unico chip con 1.386 qubit, il processore sarà composto da tre chip da 462 qubit ciascuno, interconnessi tra di loro con un collegamento quantistico. Dal momento che tale collegamento avviene con cavi fisici lunghi circa un metro che vanno da un processore all'altro dentro il criostato, IBM si attende che questo collegamento riduca il livello di fedeltà dei tre chip e abbassi le prestazioni complessive, ma si tratta di un importante passo verso la costruzione di processori quantistici in cui si ottiene un unico processore più grande, anziché più moduli.

In tale senso, un passaggio fondamentale per arrivare a questo concetto sarà Crossbill (crociere), un processore da 408 qubit costruito con tre chip che permetteranno di creare un reticolo di qubit identico a quello presente sui processori a singolo chip. IBM scrive che "l'intento di questa architettura è di far sì che gli utenti pensino di stare usando un unico grande processore [anziché tre processori più piccoli]."

Kookaburra sarà un'ulteriore evoluzione di tale architettura, di fatto composta da tre gruppi di chip, ciascuno composto a sua volta da tre chip da 1.386 qubit, per un totale di 4.158 qubit. La connessione interna ai tre gruppi di chip avverrà come in Crossbill, mentre i gruppi saranno interconnessi con la tecnica usata per Flamingo.

Queste evoluzioni architetturali saranno la base della costruzione di computer quantistici da un milione di qubit, soglia da più parti considerata come critica per dimostrare il cosiddetto "vantaggio quantistico", ovvero la capacità dei computer quantistici di effettuare calcoli fuori dalla portata dei computer classici.

La soluzione è la parallelizzazione (anche via software)?

Per poter sfruttare la potenza di calcolo messa a disposizione dall'hardware è però necessario anche il software e IBM parla anche dei suoi piani di sviluppo per tale componente. Qiskit Runtime, che si occupa di creare i cosiddetti circuiti che vengono eseguiti dai processori quantistici, verrà sviluppato ulteriormente e vedrà l'inclusione dei circuiti dinamici, che permettono di usare feedback e feedforward delle misurazioni quantistiche per cambiare il risultato delle operazioni.

Nel 2023 verranno introdotti i thread in Qiskit Runtime, cosa che consentirà di parallelizzare più facilmente i calcoli; in effetti, IBM intende automatizzare la parallelizzazione quando ciò è possibile. Nel 2024 e nel 2025 verranno implementate tecniche rispettivamente di mitigazione e di soppressione degli errori; tali tecniche mirano a ridurre gli errori e aumentare dunque la qualità dei risultati ottenuti dall'hardware quantistico e, secondo IBM, costituiscono le fondamenta su cui poi sarà possibile costruire la correzione degli errori vera e propria.

Verranno migliorate le primitive di Qiskit Runtime Service, ovvero le funzioni di base che permettono di misurare o stimare le distribuzioni di probabilità che vengono generate dai computer quantistici. Tali funzioni vengono usate per costruire gli algoritmi più complessi alla base delle applicazioni interessanti (come, ad esempio, la simulazione di composti chimici).

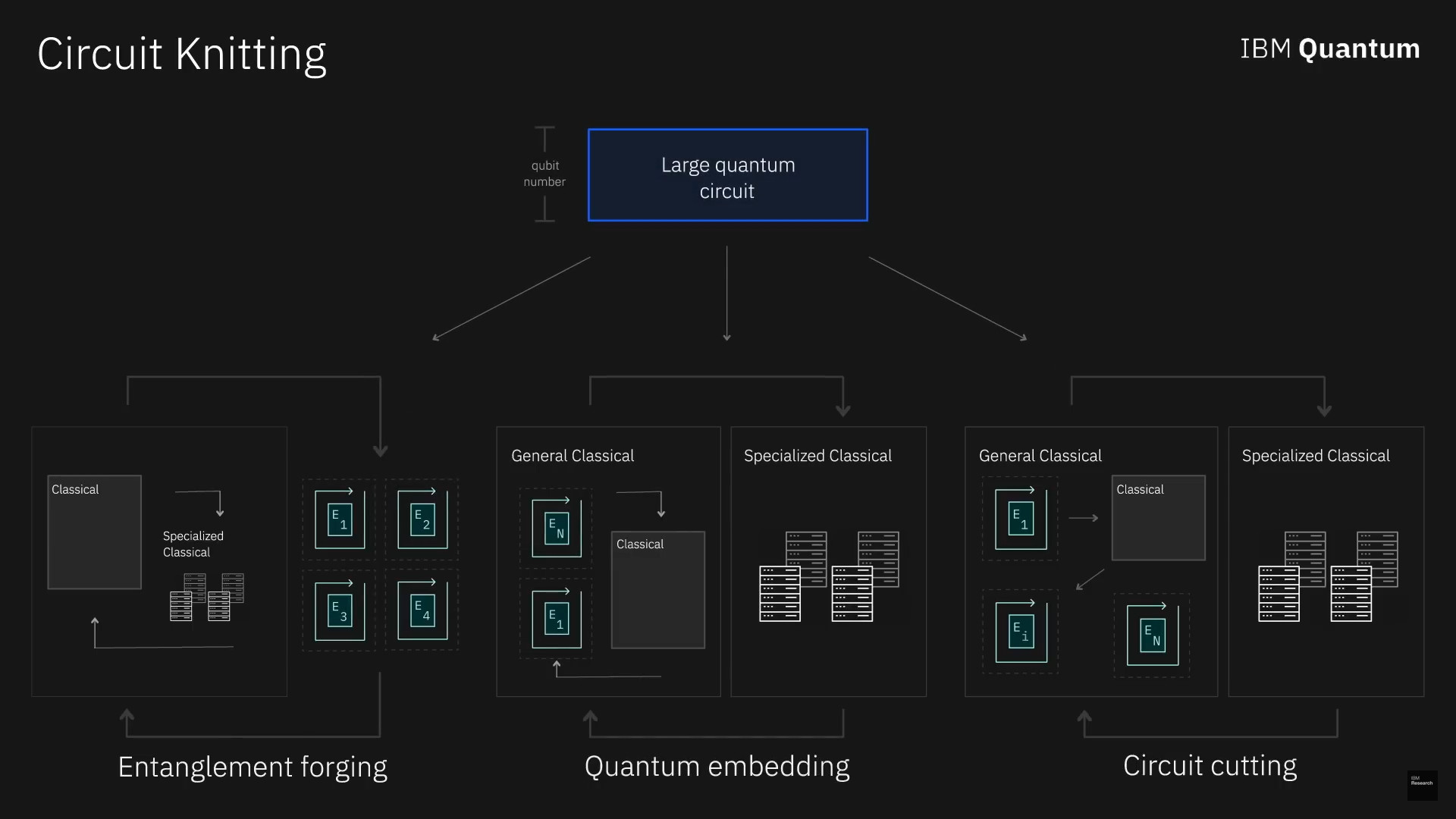

A gennaio IBM aveva annunciato un risultato significativo con la cosiddetta "forgiatura dell'entanglement", una tecnica parte della più ampia famiglia dell'intreccio di circuiti. Si tratta di un metodo simile, almeno in linea di principio, all'approccio divide et impera del mondo classico: il problema viene scomposto in parti più piccole e semplici, che vengono calcolate indipendentemente; i risultati di tali parti vengono poi ricomposti per ottenere il risultato finale. Nel caso dei computer quantistici, l'intreccio di circuiti scompone i problemi in parti più piccole da eseguire su hardware quantistico e i risultati di tali calcoli vengono ricomposti da computer classici.

Proprio la capacità di ridurre problemi grandi a problemi più piccoli è parte dello sforzo di IBM di parallelizzare i calcoli: questa divisione può infatti semplificare l'uso di processori composti da chip più piccoli e consentire, dunque, l'ottenimento di risultati pratici nonostante le limitazioni dell'architettura hardware.

Stando alle parole di IBM, dall'anno prossimo dovremmo cominciare a vedere i primi prototipi di applicazioni pratiche, a partire dal machine learning, mentre entro il 2025 dovremmo vedere applicazioni nell'ottimizzazione, nelle scienze naturali e in altri campi ancora.

"Supercomputer incentrati sulla componente quantistica"?

È interessante notare un cambiamento nella comunicazione di IBM riguardo i computer quantistici. L'azienda scrive nel suo articolo di annuncio: "il nostro obiettivo è costruire supercomputer incentrati sulla componente quantistica [quantum-centric supercomputers nell'originale inglese, NdR]. Tali supercomputer includeranno processori quantistici e classici e reti di comunicazione quantistiche e classiche, tutte componenti che lavoreranno assieme per trasformare completamente il modo in cui eseguiamo i calcoli." L'aspetto notevole è che IBM non parla più principalmente di "vantaggio quantistico" (che viene comunque nominato) o di computer quantistici in grado di operare da soli. L'azienda parla ora esplicitamente di supercomputer che vedono una collaborazione tra componente classica e componente quantistica.

La ragione di tale cambiamento non è nota, ma è possibile fare alcune ipotesi. Da un lato c'è la necessità per IBM di mostrare che tutti gli investimenti in questo settore porteranno a dei risultati in tempi relativamente brevi: far cooperare computer classici e quantistici può portare a ottenere un prodotto o un servizio vendibile alle aziende in tempi più brevi e, dunque, spostare la comunicazione su tale collaborazione può essere una strategia per portare a creare maggiore fiducia e consapevolezza verso il settore da parte del mercato e giungere a tale risultato. Dall'altro c'è forse la maggiore consapevolezza che il vantaggio quantistico richiederà ancora molto tempo per essere raggiunto, se mai lo sarà, e da qui nasce la volontà di portare l'attenzione maggiormente sulle applicazioni pratiche a breve o medio termine che sarà possibile ottenere dall'uso collaborativo di computer quantistici e classici.

Intervista a Stop Killing Games: distruggere videogiochi è come bruciare la musica di Mozart

Intervista a Stop Killing Games: distruggere videogiochi è come bruciare la musica di Mozart Samsung Galaxy S25 Edge: il top di gamma ultrasottile e leggerissimo. La recensione

Samsung Galaxy S25 Edge: il top di gamma ultrasottile e leggerissimo. La recensione  HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto

HP Elitebook Ultra G1i 14 è il notebook compatto, potente e robusto La Corea del Sud vorrebbe costruire una base lunare entro il 2045

La Corea del Sud vorrebbe costruire una base lunare entro il 2045 Rilasciati i primi risultati delle analisi sulla cometa interstellare 3I/ATLAS

Rilasciati i primi risultati delle analisi sulla cometa interstellare 3I/ATLAS Robot umanoidi low cost? Unitree ci prova con R1 a 5.900 dollari

Robot umanoidi low cost? Unitree ci prova con R1 a 5.900 dollari

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".