HPE annuncia soluzioni per l'IA generativa in collaborazione con NVIDIA: parola d'ordine "chiavi in mano"

di Riccardo Robecchi pubblicata il 30 Novembre 2023, alle 18:11 nel canale data

HPE ha lanciato nuove soluzioni sia hardware sia software pensate specificamente per aiutare le aziende ad avere a disposizione un'infrastruttura pronta all'uso per l'IA generativa

HPE ha annunciato l'avvio di una collaborazione con NVIDIA per dare alle aziende una soluzione preconfigurata per l'addestramento, il tuning e l'inferenza di modelli di intelligenza artificiale generativa di grandi dimensioni. Per quanto non si tratti di un annuncio di per sé particolarmente innovativo o significativo, mette in luce l'attenzione due aspetti riguardanti quelli che tradizionalmente sono fornitori di soluzioni hardware come HPE: tali aziende stanno ponendo molta attenzione al tema dell'IA generativa e, in particolare, al renderla maggiormente fruibile con soluzioni quanto più possibile "chiavi in mano"; secondariamente, sempre più fornitori di soluzioni hardware come HPE offrono anche servizi e soluzioni software, fatto che li mette in diretta competizione con realtà che tradizionalmente operavano in altri mercati.

HPE lancia nuove soluzioni per l'IA generativa

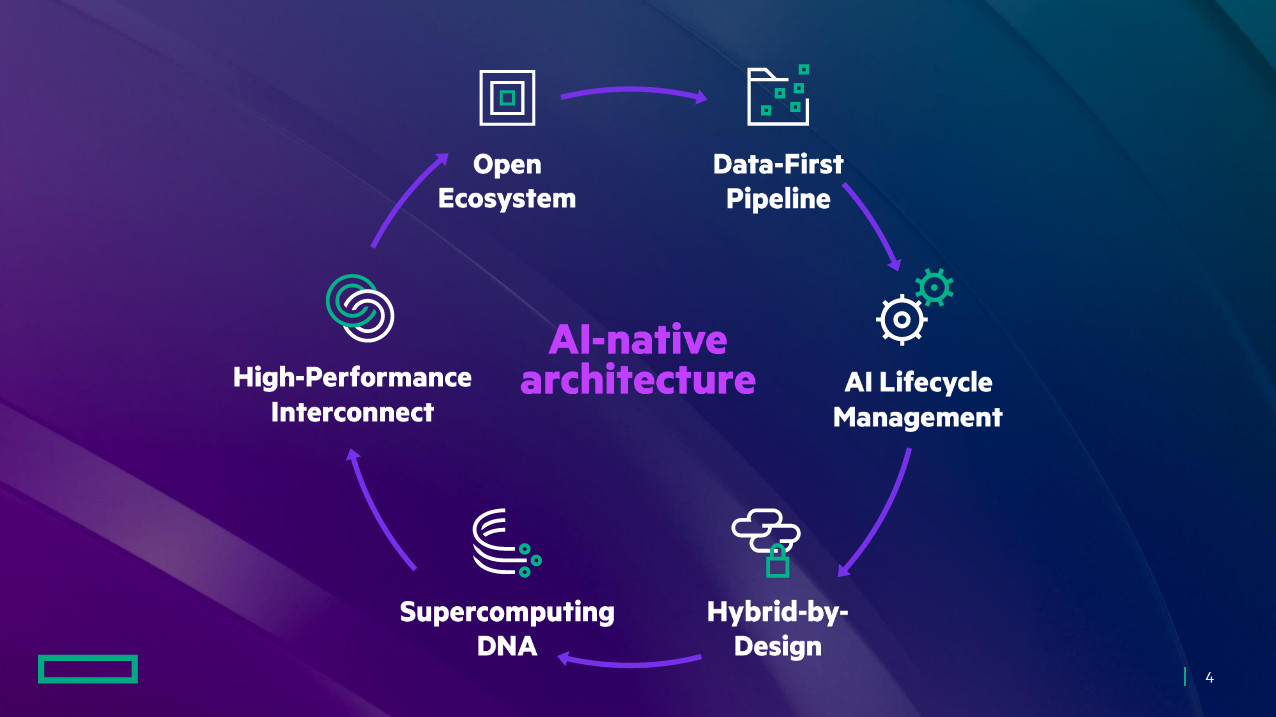

Le nuove soluzioni lanciate da HPE per l'IA generativa sono in realtà derivate dal mondo HPC, in cui l'azienda è presente da tempo (e in particolar modo dopo l'acquisizione di Cray, storico marchio del mondo del supercalcolo). Non si tratta dunque di novità in senso assoluto su questo fronte. Secondo HPE, sedici server ProLiant Compute DL380a con GPU NVIDIA L40s, DPU NVIDIA BlueField-3 e NVIDIA Spectrum-X Ethernet Networking Platform sono in grado di gestire il modello Llama 2 con 70 miliardi di parametri.

La novità sta nel software, che include HPE Machine Learning Development Environment, HPE Ezmeral Software, HPE ProLiant Compute e HPE Cray Supercomputers con NVIDIA AI Enterprise software suite, incluso il framework NVIDIA NeMo. Proprio l'inclusione di software pronto all'uso è ciò che differenzia questa nuova piattaforma dalle precedenti, non progettate specificamente per l'IA.

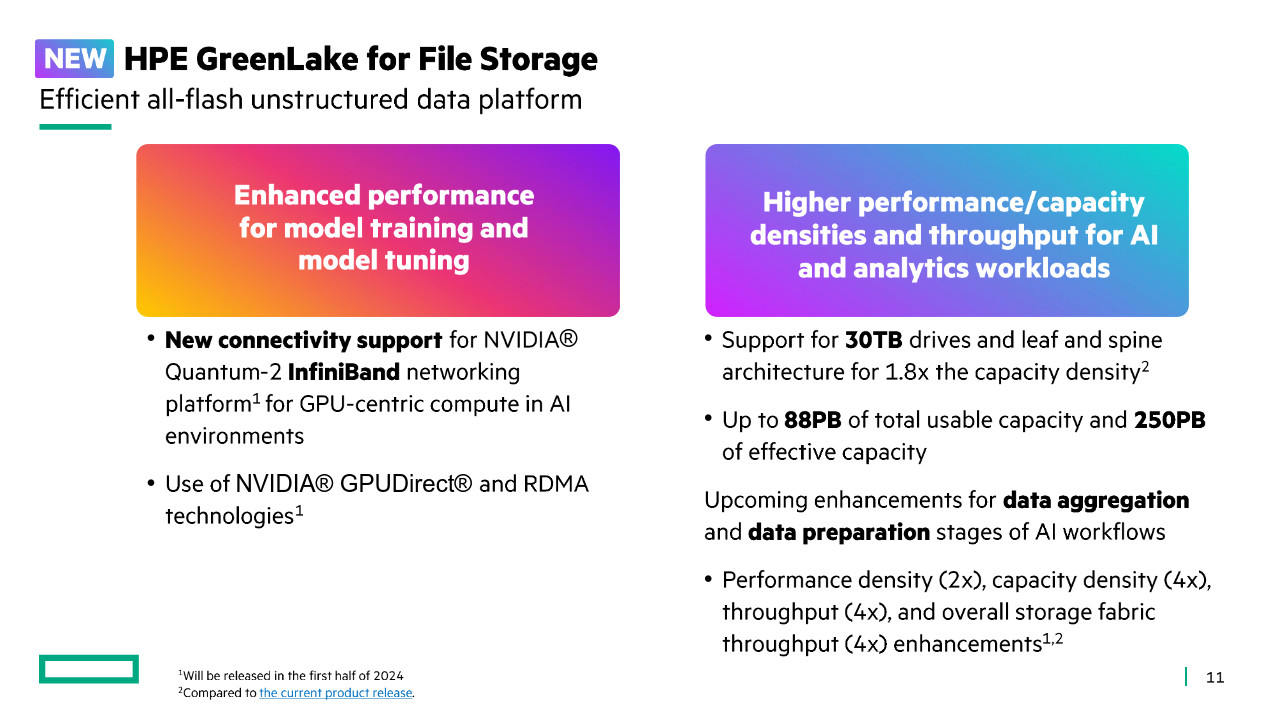

Un'altra novità annunciata da HPE è GreenLake for File Storage: si tratta di una piattaforma di archiviazione per dati non strutturati (ovvero file, come suggerisce il nome) che supporta unità fino a 30 TB, per una capacità massima impiegabile di ben 88 PB (ovvero 88.000 TB). HPE ha parlato specificamente di questa soluzione come ideale per l'addestramento dell'intelligenza artificiale. Sarà disponibile entro la prima metà del 2024.

Sul fronte del software, è da segnalare anche il lancio di HPE Machine Learning Development Environment Software come servizio gestito su AWS e altri fornitori di servizi cloud: in tal modo le aziende possono sfruttare l'ambiente di HPE per l'apprendimento automatico con un servizio che è, di nuovo, "chiavi in mano" e riduce la complessità d'implementazione dei progetti di IA.

In seguito a recenti miglioramenti che l'hanno reso maggiormente appetibile per questo campo, HPE propone anche Ezmeral Software come fondamenta SaaS per lo sviluppo di soluzioni di IA e analisi dei dati che operino in ambienti di cloud ibrido. HPE segnala miglioramenti al data lakehouse ibrido, che è ora ottimizzato per funzionare sia su CPU sia su GPU, all'allocazione di risorse sulle GPU NVIDIA, e a un migliore addestramento e affinamento dei modelli in HPE Ezmeral Unified Analytics Software grazie all'integrazione con HPE Machine Learning Development Environment Software.

Microsoft Surface Pro 12 è il 2 in 1 più compatto e silenzioso

Microsoft Surface Pro 12 è il 2 in 1 più compatto e silenzioso Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!  Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2

Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2 Theia potrebbe essere stata fondamentale per lo sviluppo della vita sulla Terra

Theia potrebbe essere stata fondamentale per lo sviluppo della vita sulla Terra Onde gravitazionali: LIGO-Virgo-KAGRA hanno rivelato la più massiccia fusione di buchi neri di sempre

Onde gravitazionali: LIGO-Virgo-KAGRA hanno rivelato la più massiccia fusione di buchi neri di sempre La sovranità digitale si applica anche all'assistenza: arrivano i servizi sovrani di SUSE

La sovranità digitale si applica anche all'assistenza: arrivano i servizi sovrani di SUSE

0 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".