L'intelligenza artificiale può risolvere i problemi, ma dev'essere aperta e trasparente. Il punto di vista di IBM

di Riccardo Robecchi pubblicata il 02 Agosto 2024, alle 13:01 nel canale Innovazione

L'IA può essere impiegata per molti scopi: uno individuato da IBM e dal Cineca è la prevenzione del rischio idrogeologico, problema molto sentito in Italia. Ne abbiamo parlato con Alessandro Curioni, esplorando anche i problemi legali ed etici dell'IA

IBM e il Cineca hanno recentemente siglato un memorandum d’intesa per sviluppare modelli d’intelligenza artificiale che sfruttano i modelli fondamentali della famiglia Granite di IBM. In particolare, le due realtà collaboreranno per effettuare ricerca sulla prevenzione dei rischi idrogeologici usando proprio i modelli Granite. Ne abbiamo parlato con Alessandro Curioni, Vice President Europe and Africa e Director IBM Research Zurich.

Il Cineca, lo ricordiamo, è un consorzio composto da 2 Ministeri, 70 Università e 46 centri di ricerca pubblici italiani. È la realtà che è stata incaricata di gestire il cosiddetto “Tecnopolo”, che include il centro di supercalcolo dove si trova il supercomputer Leonardo, che attualmente occupa la posizione numero 7 della classifica Top500. Leonardo verrà usato per molti progetti di ricerca e tra questi rientrano anche quelli sull’intelligenza artificiale.

Usare i dati geospaziali per prevedere i cambiamenti climatici e il rischio idrogeologico

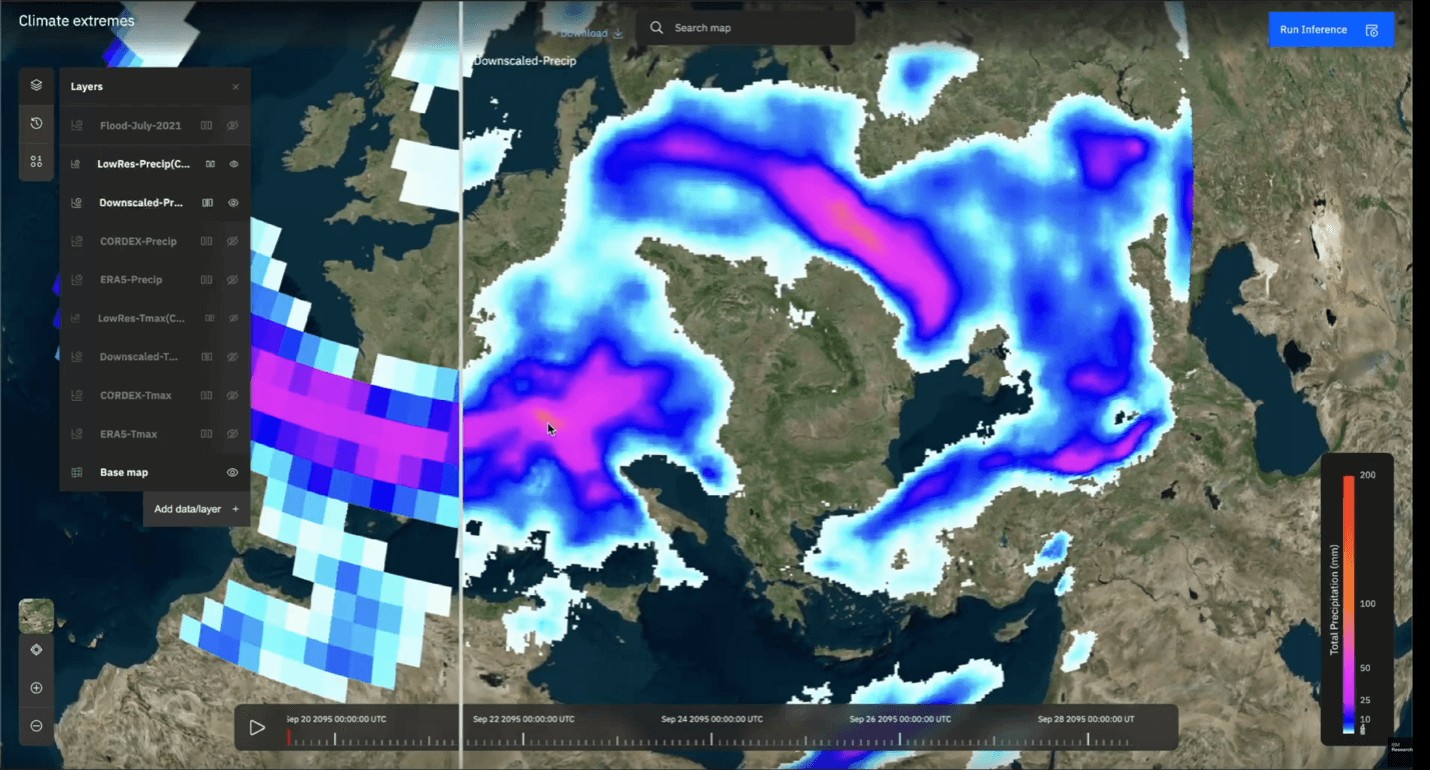

I modelli d’intelligenza artificiale possono essere addestrati non solo sui dati linguistici, ma su qualunque dato che abbia una struttura: tra questi ci sono, quindi, anche le immagini satellitari del nostro Pianeta. La possibilità di addestrare i modelli d’intelligenza artificiale sui dati geospaziali rende quindi possibile usarli per effettuare previsioni, in particolare legate al cambiamento climatico e ai rischi idrogeologici - due temi particolarmente importanti per il nostro Paese, che è tra i più esposti in Europa a entrambi.

I modelli possono essere usati per fare predizioni sia a livello locale, sia a livello globale, e prevedere dunque ondate di calore, alluvioni, precipitazioni e così via, con una risoluzione più elevata (e dunque un migliore livello di dettaglio) rispetto agli approcci passati. È anche possibile ottenere un riscontro quantitativo dei piani di riforestazione, con una proiezione sui diversi anni della crescita della nuova vegetazione e il suo impatto sul clima locale e oltre, in modo da intervenire in maniera mirata.

Curioni ci dice che ciò consente di usare un’immagine da satellite che documenta l’impatto di un’alluvione su una regione e le capacità generative del modello per desumere “come questo impatto a larga scala dell’alluvione si declina quando ci spostiamo su una scala più piccola, ad esempio vicino a un edificio. Un altro esempio: avendo delle immagini che dicono che c’è un alluvione in questo punto del mondo oggi, si può usare il modello per generare un elenco delle zone nel resto del mondo che hanno caratteristiche tali per cui questo tipo di alluvione potrebbe avvenire anche lì.”

IBM ha avviato una collaborazione con la NASA, che ora ha esteso all’ESA, per usare i dati geospaziali satellitari per addestrare modelli fondativi sulle immagini per interpretarle e generarne di nuove. “I modelli sviluppati in collaborazione con la NASA sono stati ripuliti, testati, verificati e un mese fa sono stati resi disponibili come open source con licenza Apache 2 su Hugging Face, nella nostra famiglia di modelli generativi che si chiamano Granite, che possono essere utilizzati come base da chiunque voglia integrarli con i propri dati per un certo scopo”, ci dice Curioni. Che ci spiega che IBM ha poi scelto di collaborare con il Cineca sia perché si tratta di una struttura che si occupa già di supercalcolo, e dunque ha già le competenze e le infrastrutture necessarie, sia perché voleva impiegare i propri modelli per avere un impatto positivo tanto sul mondo della ricerca, quanto su quello delle aziende, quanto poi sulla società più in generale.

L’intelligenza artificiale dal punto di vista di IBM: aperta e trasparente

IBM, conferma Curioni (in foto, sopra, con Alessandra Poggiani, Direttrice Generale di Cineca), è sempre più focalizzata sull’obiettivo di diventare leader nell’intelligenza artificiale per il business e nell’hybrid cloud. L’azienda ha da sempre un forte interesse per la ricerca, come avevamo visto quando avevamo incontrato proprio Curioni nel centro di ricerca di Zurigo. L’intelligenza artificiale rientra tra gli ambiti su cui IBM fa ricerca attiva; alla fine di maggio avevamo partecipato alla presentazione italiana dei modelli Granite, che l’azienda ha pubblicato come open source.

Per questo IBM ha deciso di creare i modelli Granite come una sorta di impalcatura su cui poi le varie organizzazioni (aziende, enti pubblici, centri di ricerca…) possono inserire i propri dati per ottenere risultati che siano rilevanti per il proprio ambito. Non ha infatti senso addestrare un modello a fare qualunque cosa quando deve eseguire pochi compiti, né ha senso competere con modelli sempre più grandi e che inglobano tutta la conoscenza possibile. Il risultato di questo approccio, infatti, è lo stesso citato nel film Gli Incredibili dal cattivo, Syndrome: una volta che tutti hanno i superpoteri, è come se non li avesse nessuno, e dunque il vantaggio competitivo dato dall’IA sparisce.

IBM sta investendo nella creazione della tecnologia di base che consente di costruire i modelli a partire dai dati aziendali o, avendo già un modello, di aggiungervi tali dati. In questo modo il modello che viene creato è differenziato rispetto a quelli presenti sul mercato ed è specifico per le necessità dell’azienda: “La specificità e differenziazione dei modelli è oggi un punto di attenzione da non sottovalutare per rendere l’AI realmente affidabile e di utilità per le aziende. Infatti i modelli fondativi pre-addestrati con le tecniche del self-supervised learning, che vengono poi particolarizzati con i dati aziendali, sono usati su grande scala, per cui errori, per esempio di bias [pregiudizio o preconcetto, NdR], presenti nel modello originale si potrebbero ripetere in tutti i modelli da esso derivati. Una volta se facevo qualcosa di sbagliato, lo correggevo nel modello; se adesso, dopo che ho creato il modello, questo mi permette di crearne altri 10.000, se c’è un bias o qualcosa di sbagliato è un problema enorme”, afferma Curioni. “Se io introduco proprietà intellettuale che non è la propria in un modello, questo reato viene perpetrato anche da tutti gli altri modelli [basati su di esso] che si creano. Per cui IBM ha creato questa infrastruttura che utilizza con i clienti per implementare l’IA, generativa e non, su grande scala con la governance adeguata. Proprio per questo abbiamo creato una piattaforma in grado non solo di arricchire i modelli con i propri dati ma anche di governare questi modelli evitando una loro deriva””

Il risultato complessivo è che si può usare l’IA in molti più campi rispetto al passato, e con risultati complessivamente migliori.

L’IA responsabile: cosa vuol dire e come arrivarci

Un punto molto importante è quello dell’IA sviluppata e impiegata responsabilmente. Un aspetto su cui IBM ha molto puntato, sin dal principio, è l’idea di usare l’IA in maniera responsabile. L’avevamo visto alla presentazione dei modelli Granite, in cui ci aveva molto colpito il fatto che l’interfaccia dicesse chiaro e tondo che il modello può produrre allucinazioni e i suoi risultati vanno dunque controllati e verificati. Ma cosa vuol dire concretamente essere responsabili nello sviluppo e nell’uso dell’IA?

“Bisogna stare molto attenti, perché questa tecnologia è un game changer [ovvero qualcosa che cambia le regole del gioco e dunque uno o più interi settori, NdR] e bisogna cercare di utilizzarla e svilupparla in modo responsabile; l’unico modo per farlo è essere trasparenti e aperti a livello dei modelli: trasparenti per quanto riguarda le sorgenti dei dati, aperti perché bisogna essere in grado di andare a vedere come un modello è fatto”, dice Curioni. Il quale solleva un punto interessante: risolvere i rischi idrogeologici dell’Italia non è una reale soluzione, se per farlo bisogna immettere quantitativi astronomici di CO2 nell’atmosfera, perché in tal caso “il ritorno d’investimento a livello sociale è zero.” Chi produce un modello “deve anche essere in grado di dire ‘il mio modello ha questa dimensione, per cui se tu lo usi hai questo impatto climatico’. Se non è in grado di dirlo o non lo si vuole dire, significa che non si sta utilizzando un modello in modo responsabile.”

Per questo IBM ha pubblicato i modelli Granite e creato l’AI Alliance, che è un gruppo di aziende, centri di ricerca e università che vogliono sviluppare un’IA aperta e trasparente. “E questo è un modo di aiutare, anche a livello comunicativo, a far capire che è la cosa giusta da fare”, afferma Curioni.

C’è poi un problema estremamente importante relativo alla proprietà intellettuale. Sono già molti i problemi sollevati da artisti, scrittori, giornalisti e aziende relativi alla liceità della pesca a strascico che OpenAI, Google e altre realtà hanno effettuato per i propri modelli linguistici di grandi dimensioni. Pesca che non ha visto, nella grande maggioranza dei casi, nessun compenso per i produttori dei contenuti. Un ulteriore aspetto, nient’affatto secondario, è che molti dei modelli attualmente disponibili pubblicamente non attribuiscono correttamente le fonti da cui prendono le informazioni, così da creare due problemi: il primo è che diventa difficile capire se la fonte originale dell’informazione fosse affidabile (ed evitare di mettere la colla sulla pizza, ad esempio), il secondo è che la fonte originale non vede alcun ritorno dal fatto che la sua informazione venga usata. Il New York Times è arrivato a citare in giudizio OpenAI, puntando proprio sul fatto che ChatGPT non attribuisce correttamente le fonti e che OpenAI non ha dato alcun contributo economico.

Creare modelli d’IA di fatto significa trasferire la conoscenza contenuta in tali dati, e quindi il suo valore, all’interno dei modelli stessi; significa anche, però, trasferire la conoscenza contenuta nella connessione tra i dati. Una volta che questo trasferimento è avvenuto, però, il valore dei dati si annulla, perché questi diventano parte del modello e non sono quindi più utili come entità a sé stante. Ecco perché è importante combattere l’approccio in cui vengono presi dati da Internet senza chiedere il permesso e senza alcun compenso: perché in tale approccio è insita la nozione che la proprietà intellettuale e la proprietà dei dati non esistano più. “Quindi rischiamo di mettere in discussione le basi della nostra società: la proprietà è un valore fondante di tutto quello che facciamo per cui, anche da quel punto di vista, fare cose non trasparenti e pretendere di integrare tutto senza darne ragione, senza farlo in modo equo, è inconcepibile ed è sbagliato.”

Potremmo dunque riassumere e dire che il modo giusto di usare l’IA è di cercare di usare dati pubblici che sono effettivamente tali, oppure il chiedere il permesso ai rispettivi proprietari; di mettere in chiaro cosa aspettarsi dai modelli e i possibili problemi di allucinazioni; di essere trasparenti circa l’impatto derivante dall’uso dei modelli; di usare modelli quanto più possibile piccoli, così da limitarne l’impatto in termini di consumo energetico e di risorse; di essere aperti, ovvero condividere i modelli come open source così che chiunque possa verificare che questi principi siano rispettati.

La strada perché questo approccio diventi comune è molto lunga: attualmente i nomi più in vista in questo campo sembrano in favore di uno più opaco e chiuso, che però potrebbe avere (e probabilmente avrà, ci sentiamo di aggiungere) ripercussioni negative su molti settori. La speranza è che l’approccio di IBM riesca, nel tempo, a imporsi, perché sembra l’unico a garantire alle aziende, agli individui e alla società più in generale un uso responsabile dell’IA.

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!

Recensione REDMAGIC Astra Gaming Tablet: che spettacolo di tablet!  Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2

Dopo un mese, e 50 foto, cosa abbiamo capito della nuova Nintendo Switch 2 Gigabyte Aero X16 Copilot+ PC: tanta potenza non solo per l'IA

Gigabyte Aero X16 Copilot+ PC: tanta potenza non solo per l'IA Monitor da urlo in offerta su Amazon: tra OLED, 240Hz e schermi curvi c'è l'imbarazzo della scelta

Monitor da urlo in offerta su Amazon: tra OLED, 240Hz e schermi curvi c'è l'imbarazzo della scelta Il boom azionario di NVIDIA sta rendendo straricchi molti dei suoi dipendenti

Il boom azionario di NVIDIA sta rendendo straricchi molti dei suoi dipendenti Elegante, senza cornici, 91€: in offerta il monitor HP 524sa, 23,8" full HD perfetto per casa e ufficio

Elegante, senza cornici, 91€: in offerta il monitor HP 524sa, 23,8" full HD perfetto per casa e ufficio

2 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoC'è chi fa 100 e dichiara 2, c'è chi fa 10 e dichiara 110,alle volte penso che certi entusiasmi giornalisti,siano gonfiati a dovere solo per gonfiare le azioni e le vendite di certe aziende.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".